3D-LaneNet:端到端3D多车道检测网络

《3D-LaneNet:end-to-end 3D multiple lane detection》

原作者:

Noa Garnett, Rafi Cohen, Tomer Pe'er

原文链接:

https://arxiv.org/pdf/1811.10203.pdf

编者按:三维车道检测是实现自动驾驶的关键技术,它需要对主控车辆的可行驶车道的三维位置进行精确估计。这篇文章提出了一个基于CNN的端到端的3D车道线检测网络3D-LaneNet,可以直接检测多个车道,并估计车道曲率,对三维车道检测的相关研究具有重大的启发与促进作用。

摘要:

这里介绍一种架构,它可以直接从一张图像预测出道路场景中的三维车道,这项工作标志着首次尝试通过在线感知解决这一任务,而不是依赖于预先映射的环境。我们的网络架构,3d-lanenet中有两个新的概念,1.网络内部的反透视变换。2.基于anchor的车道线表示。网络内反透视变换投影使得在常规图像视图和俯视图中都能方便地表示信息流.一个基于anchor的列输出表示使得我们这个端到端的方法能够替代传统的启发式方法,比如聚类和奇异点处理。此外,我们的方法精准的解决了复杂情况,比如车道的合并以及车道的分开(比如一条车道延伸之后分叉类似这种情况)。在我们的new 3D lane synthetic dataset 上,架构表现出了非常好的结果。为了和现有的方法作对比,我们验证了在image-only tuSimple lane detection benchmark 上的有效性,并获得了非常具有竞争力的表现。

1.介绍

三维车道检测是实现自动驾驶的关键技术,它包括对相对于主控车辆的可行驶车道的三维位置的精确估计。存在两种互补的技术解决方案:加载离线生成的预映射车道和基于感知的实时车道检测。离线解决方案在给定精确当前车辆定位(在地图坐标中)的情况下具有高的几何精度,但是部署和维护起来很复杂。最常见的基于感知的解决方案是使用单目摄像头作为主要传感器来解决任务。现有的基于相机的方法检测图像中的车道,然后通过平坦地面的假设,将它们投射到三维世界,当然当地面平坦这个假设不对的时候,会导致不准确的估计与检测。

受到近年来CNN在单目深度信息预测的成功激励,我们提出了直接检测3D车道线的方法。更正式地说,给定从前置摄像头拍摄的一张图像,任务是输出一组车道实体,每个实体在相机坐标中表示为3D曲线,描述车道分隔符(分隔符就是传统意义上的车道线)或车道中心线(中心线是两条传统意义上的车道线中间的线)。我们提出了3D- lanenet,一个基于CNN的模型,可以进行3D车道检测。该网络经过端到端的训练,输出是在道路的每一个纵向切片上(道路被竖着分为很多的列,每一个列相当于一个切片。),这些输出包括车道线经过这个纵向切片的置信,以及他的3D曲线坐标。我们的方法原理在图1中做了解释。 我们直接的单阶段的方法避免了使用现有方法进行后处理,包括聚类,奇异点处理等。整个网络的架构基于一个创新的双通路(并不是并行的)结构,这个结构在网络内部,对特征图进行一些透射投影变换以生成虚拟的鸟瞰视图。这种双特征表示(正常视图特征,以及鸟瞰视图特征,原文是image view 以及 top view)提高了在道路场景下,网络的推断能力。输出被表示为一个新的基于列的anchor编码(即在该anchor下的各种参数信息),这使得网络具有水平不变形,并且保证了端到端。每个输出都对应一个anchor,类似于基于anchor的单阶段目标检测办法,比如SSD[20],YOLO[27]。

图1.(a)端到端的方法的原理图解,以及在俯视图上的车道检测结果实例。(b)结果在原图上的投影。

为了完成这项任务,获取带有3D标记的地面真实数据是一项需要多传感器和昂贵的高清地图的工作,在我们的工作中,我们训练和测试我们的网络通过一个新的和合成数据集synthetic-3D-lanes,你可以获得每一条车道线的所有的精确3D位置坐标。数据集目前限制在高速公路场景中,尽管有一些道路模拟器,但是他们的目的不是为了3D车道线检测任务的。并且限制了相关场景属性(如车道曲率)的可变性。我们在该领域的主要成就是能够随机生成具有可变三维形状和车道拓扑结构的高速路段。而我们方法的主要优势在于估计3D车道线,还有纯图像进行车道线检测。我们在tuSimple数据集上对我们的直接方法进行了训练和测试,在不使用通常的后处理技术的情况下,我们获得了与现有技术相媲美的结果。

总结一下我们的主要贡献:

定义了3D车道线检测任务的度量标准,同时也第一个提出了3D检测任务的解决办法

一个创新的双通路带有内部投影变换的结构.

一个新的基于anchor的车道线输出表示,使得网络支持直接的端到端的预测。这可以应用于3D车道线检测和基于图像的检测

一种随机生成具有车道拓扑变化(车道数、汇集、分叉)和三维形状的合成样本的方法。

2. 相关工作

传统的车道检测系统(将低层次的操作(如方向滤波器)与高层次的启发式(如霍夫变换)结合起来检测图像中的连续车道。一个通常的流程包括4个阶段:局部车道特征提取(1)、车道模型拟合(2)、图像与世界的对应(3),聚合(4)。近年来,局部特征提取阶段是通过对图像应用一个或多个CNNs来完成的,但总体上流程仍然非常相似,后期处理仍然存在。

具体来说,CNNs可以通过增强边缘图或分类候选块来改进特征提取。Huval检测本地车道线通过目标检测CNN。VPGNet Lee等人遵循类似的概念,并且额外检测其他道路标记和消失点,以改进车道检测。KIM和park重新定义了特征提取阶段,将其作为一个分割问题,这个问题有两个分类类别,左车道线和右车道线,延伸网络的范围来执行(extending the reach of the network to perform clustering.)但是,仍然必须为每个cluster安装一个世界坐标车道模型,并且无法处理多车道问题。Nevenetal.[23]尝试端到端多车道检测,通过训练CNN不仅创建一个0,1车道像素掩码,而且还为每个像素点嵌入用于聚类车道点的特征向量。Ghafooria提出使用生成对抗网络使语义分割网络的工作输出在车道检测的背景下更加真实。一些工作(如Meyer等人的,Oliveira等人的)是基于类似的方法构建的,其中主车道和相邻的车道是语义类(车道内部整片而不是车道线)。

与所有提出的方法相反,3D- lanenet统一了前三个阶段的共同流程,提供了一个完整的在三维世界坐标体系的多车道表示方法,并且只通过一次前向传播。此外,以往的方法采用平面假设进行图像到世界的对应,而我们的方法估计了车道的整个三维形状。

IPM通过相机视角图像生成一个场景的虚拟的鸟瞰图,这个的具体操作Mal-lot et al. [21]在障碍检测中解释了。并且第一次被Pomer-leau在车道线检测中使用,IPM已经在车道线检测任务中被广泛的使用,因为在鸟瞰图视角中,车道线相互平行,并且他们的曲率情况可以用低阶多项式拟合。此外,进行透视变换后,使得他们看起来更加的想近了,(当然会有一些模糊效果)(本来远处的车道线在相机图像上比较小。)最近,He等人引入了一种“Dual-viewCNN”它由两个独立的子网络组成,每个子网络产生一个车道线描述(每个视图一个车道线描述),然后将描述符连接并应用于候选图像位置。Li等人使用CNN直接在鸟瞰图上检测车道标记和几何属性,如局部位置和方向,在鸟瞰图上,这些属性保持不变。此外,他们还部署了第二个循环网络,该网络遍历图像以检测一致的车道。Neven等人使用子网络(“H-net”)预测每张图像中的俯仰,将车道投影到俯视图,以改进曲线拟合。与以前的工作不同,我们使用协同的单一网络方法来利用这两种观点。

更一般地,我们提出了第一种方法,这种方法使用端到端训练的CNN直接检测多个车道,并估计每个车道的三维曲率。我们还展示了我们的方法既适用于中心线,也适用于通常意义下的车道线,并且具有处理汇聚和分叉的能力,无需任何进一步的后处理。

.jpg)

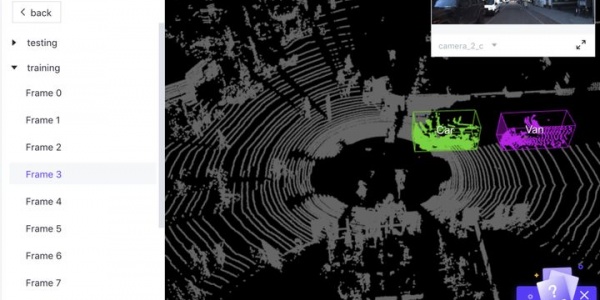

图2.在测试集’synthetic-3D-lanes dataset’上,置信度大于0.5的车道中心线估计结果实例。在每一幅图片中,对真值(蓝色)和方法的结果(红色)进行了展示,并配有一个3D的可视化。需要主要的是,3D可视化轴的尺度根据场景而变化。被忽略的车道被标记为蓝绿色。右下角是一个失败的例子,可能是由于阻塞,在这个例子中,这条路被错误地认为是右车道。

3.方法

我们的方法从安装在车辆上的前置摄像头获取单个图像作为输入,如图4。我们假设相机的内参矩阵κ已知(焦距,光心)我们还假设车辆相对于路面的侧倾角为0。我们假设不知道高度和俯仰角,因为随着车辆的动力学运动,他们是会改变的。道路场景中的车道线可以被表示为中心线的集合{Ci}i=1:Nc或者车道线的集合{Di}i=1:Nd(之后车道线就指代传统的我们说的车道线,中心线就是两条车道线中的线),如图3所示。每条车道实体(中心线或车道线)用摄像机坐标体系Ccamera下的三维曲线表示。我们将任务定义为检测给定图像的一组车道中心线和车道线。

图3. 带注释的例子。中心线用蓝色标出,车道线用黄色虚线标出

图4.相机姿态和道路投影面

3.1俯视图投影

我们简要回顾 (IPM)。简而言之,IPM是一个单应性变换,它获取一个前视图图像并生成一个虚拟鸟瞰视图图像,如图1(a)中的图像所示。这相当于应用相机旋转矩阵,然后在各个方向上进行不同尺度的缩放(放大或缩小)处理。在我们的实现中,我们想要确保鸟瞰视图图像中的每个像素在道路上对应一个预定义位置(路面坐标系下的绝对位置),这个位置独立于摄像机的内部特性及其相对于道路的姿态。

如图4所示,对照此图进行定义,相机坐标Ccamera = (´x,´y,´z) 是一个集合,´y是他的镜头面法线(´y是深度方向),Proad是路面的切面。我们这样定义路面坐标系Croad=(x,y,z),z方向是路面的法线,y是相机坐标系´y在Proad的投影,原点也是相机坐标系原点在路面切面上的投影,Tc2r是一个6自由度的变换矩阵(3个旋转,3个平移),他描述从相机坐标系到路面坐标系的一个变换,既然我们假设了侧倾角为0,那么Tc2r实际上被俯仰角θ以及高度hcam所定义。单应性矩阵(K*Tc2r-1),将路面上的每一个点映射到图像坐标系上。最后IPM通过单应性矩阵以及一组参数被获得,决定了俯视图上的边界以及从米到像素的缩放尺度,俯视图通过双线性差值采样,这个过程定义Sipm。

3.2射影转换和双特征模块

在我们的结构中一个主要的部分是射影变换层。它对Ui(普通图像视图)进行可微采样,获得Ut,Ut对应俯视特征图。具体的在俯视图投影部分讲述了(就是三维的STN)。双特征模块,正如在图5中所示,使用射影变换层,创造更高描述层级的特征图。信息在在多通道的特征图Ut(对应正常视图特征)和Vt(对应俯视图特征)之间流动,使用上述的采样方法(类STN方法)Ui被变换为Ut,并且和Vt合并,他么分享共同的空间尺度。以上就只这个基础模块,他可以在网络中重复使用。考虑现在有一个特征图Mt,他的获得是通过将Vt与Ut合并为[Vt;Ut],然后应用一个卷积层,获得Mt,Mt组合了在车道线检测中的两个有用的性质。1.首先,俯视图上的平移不变性,这十分有价值,因为在俯视图上,车道线有着相似的样子和空间上的几何结构。第二,保存了在两个视角下的信息(正常视图与俯视图),正常视图编码了一些在俯视图上没有的信息,比如栅栏,天际线,树木。这对于3D空间结构至关重要。特别的,对于远处来说,正常视图有着更加丰富的视觉信息,相比于俯视图,描述了一个更大的真实空间。

图5.双特征模块

3.3网络架构

架构总览如图6所示,信息在两条通路中被处理,正常视图通路,俯视图通路,我们管这个叫做双通路结构。正常视图通路处理和保存信息,而俯视图通路提供具有平移不变性的特征,并用于预测3D车道线输出。正常视图通路基于VGG16[29],俯视图通路类似。信息经过射影变换层后流向俯视图通路,这样的通路有四条。为了避免流入的特征图的通道(C)数超过原有的通道数,通过1*1的卷积对其进行了降维,当然除了第一次流入(第一次流入没有原来的)。

图6.3D-LaneNet的整体结构

3.3.1道路投影预测分支

这条通路估计路面投影平面Proad,具体的,分支预测Tc2r(通过监督方式),Tc2r决定了Hr2i,以及Sipm过程。这些是俯视图处理通路所需要的参数。在推理时,也被用于将网络的输出,输出是Croad坐标转换为Ccamera坐标。正如前边所描述过的,Tc2r使用俯仰角θ以及hcam定义的,因此道路投影预测分支预测这两个参数。

3.3.2车道线预测头

我们的端到端方法的核心是基于anchor的车道线结果表示,受到目标检测方法的启发,我们使用anchors去定义候选车道线,并且用精细的几何表示方法来描述每个anchor的精确的3D车道线形状。输出所在的坐标体系是Croad,这个体系被前边定义的hcam,和θ所定义。我们的ahcnors在这个坐标系下对应纵向线,对于每一个anchor,根据3D点,做最终3D车道线的精细化处理。正如图7所展示的那样。我们将anchor定义为垂直于x轴的等距纵向线,他的集合是{XiA}i=1:N,每一个XiA线对应着2K个输出,这个输出集合表示为(xi,zi)={(xij,zij)}j=1:K,K是预先定义的一个超参数,对应着预先定义好的K个y方向上的位置,他们一起组成一个3D点集。xi代表着相对于anchorXiA的水平偏移,这意味着(xi,zi)代表着点(xi,XiA,yi,zij),这个坐标是在Croad这个坐标体系下的。此外对于每一个anchor i,我们还会输出一个置信pi,这个代表着车道线与anchor的关联程度。我们使用一个预先定义的纵坐标Yref位置来表述这种关联,具体来说与XiA相关联的车道线,是在y = Yref这条水平线上,x的坐标偏移最小的那条车道线(简单看一下output的数量 2K个点加上一个置信p也就是说一个anchor对应2K+1个输出,如果只预测一条中心线,或者只预测一条车道线的话)。

图7.输出表示。注意输出的anchor的数量等于输出层的宽(图6中被标记为w/8)

每一个anchor,网络输出3种类型的车道分割,前两组代表着中心线,第三组代表着分隔线,为每个anchor分配两条可能的中心线将产生对汇聚和分叉的描述支持,这通常会导致两条车道的中心线在Yref重合,并在不同的道路位置分开,如图7中最右边的例子所示。车道线的拓扑结构相比于中心线来说,通常会更加的复杂,我们现在的这种表示方式,还不能描述所有的情况,比如图7中车道线没有经过Yref。车道线预测头被设计为输出如我们描述的那样的输出,通过一系列的y方向的无padding的卷积,特征图在H方向上逐渐减小,最终形成N×1×3×(2K+1)的输出(按照标准pytorch描述,可以说成是batch, (3*(2K+1),1,N),前面最后一个之所以乘3,是对每一个车道输出三种描述,分别是中心线,中心线,和车道线)中的一个i∈{1...N},对应着一个anchorXiA,每一个anchor,XiA,类型t∈{c1,c2,d}被输出表示为(xti,zti,pti),最终的输出还会经过一个1D的非极大抑制,就如在目标检测中的那样,只保留局部最大置信度的车道(与左右相邻anchor相比),每一个被保留的车道线,都有少量的3D(K个)点,然后利用他们,利用样条插补的方式完成光滑曲线的生成。

3.4训练与真值关联

给定一个图片,和他对应的3D曲线,训练过程如下:第一真值坐标系Croad被定义为与当前路面切面相关的,使用θ和hcam定义的,如前面所描述的那样。接下来,每一个车道曲线,投影到Croad坐标系下的X–Y平面上,并且与他们关联的anchor定义为在Yref处与他们最近的那个。(这里的关联就是这个anchor负责预测哪个,与yolo里目标中心落在哪个小方格中心,哪个小方格就预测谁类似)对于每一个anchor来说,最左侧的中心线,以及最左侧的车道线t∈{c1,c2,d}被定义为集合中的c1和d1,如果还有额外的中心线,那门它被定义为c2。这种方式将真值定义为与输出相同的形式,每一个anchorXiA和类型t相关的GT被标记为(xti,zti,pti),pti是在坐标系Croad下的分配标识(我理解为有就是1,没有就是0)。

在训练以及评估阶段,整个车道将会被忽略,如果他们在俯视图中在y = Yref处没有值,并且如果他们被地形所挡住,他呢也将被忽略(比如被小山丘挡住),整个的loss函数被给出,如下,它结合了三个等权重的loss,车道线检测(有无)(交叉熵损失)三维几何形状损失,以及道路平面估计损失。

4. 模仿合理行为

我们的实验描述按如下步骤:我们先回顾一下我们生成的synthetic-3D-lanes 数据集,我们的大多数结论产生于此。接下来,我们描述下对于3D车道检测任务的评估方法,然后,我们展示在我们制作的这个数据及上的结果,以及控制变量法检查每一个概念(方法)对于我们整个方法的贡献。最后,为了证明我们的方法在真实数据上的可用性,我们将我们的方法与其他单图片车道检测办法在tuSimple benchmark 上进行了比较。

4.1合成的3D车道数据集

我们生成synthetic-3D-lanes 数据集使用考元的图形引擎blender,我们的方法允许我们随机生成模型的各个部分,从场景的3D几何形状,到目标的类型,如图8所示。

图8.随机生成的数据集。(a)路面(b)道路拓扑结构和曲率(c)路与路面(d)渲染场景。

生成每一个场景的步骤如下:

3D地形:地形通过随机生成参数的高斯混合分布来生成,如图8a所示。

地形拓扑:车道的数量是被选定的,然后我们选择是否有第二条路,和在这条路里的车道,取决于后来在场景中相机的方向,第二车道的连接被视为一个车道汇聚或者车道分叉。

车道曲率:每一个车道在俯视图中的几何形状用三次多项式建模,如果存在汇聚/分叉,则选择连接点,这个在俯视图上的结果如图8b所示,车道的宽度被随机选择为3到4米。

3D车道:俯视图上生成的三次多项式会被映射到之前生成的地形上,第二车道也是,模仿正常道路的拓扑结构,如图8c所示的那样。

地形和道路表示:道路和地形的纹理是从一组纹理中选择的。车道标记的类型和颜色也是随机的。

目标:车辆和树木分别摆放在场景中、道路上和道路外。它们的模型是从一组可选模型中选择的。

场景生成:主车相机通过选择它的车道和他相对于车道中心的横向偏移放置在主道路上。相机的高度被随机设置为140cm到190cm,俯仰角被随机生成为0到5度,最终,光度被设置,并且场景从相机视角生成,每条车道中心线与车道线的3D点被转换为相机坐标系下的坐标,来产生真值。图8包括几个场景的例子,展现了场景的多样性与复杂性。

应用细节:正常视图通路用预训练的VGG16进行初始化,我们使用adam优化方法,学习率设置为5.1*10-4,我们使用在循环学习率上的变化机制如[30]中描述的那样,并且设置最小的学习率为10-6俯视图上的场景在真实场景中的尺寸为80m*20m,IPM在x与y两个方向上具有不同的缩放尺度,在第一次俯视图特征图上(第一次变换的)每一个像素点代表着真实世界16cm的宽度(x向)和38.4cm的长度(y向)最后一张特征图的边长是第一张的八分之一,并且每一列代表一个anchor,所以两个临近的anchor之间的距离为真实世界中的128cm(16*8),我们将K设置为6,预设的y的位置为:y={5,20,40,60,80,100}和Yref=20m。

4.1.1评估方法

我们提出一种对于3D车道检测的评估办法,他讲检测的准确率与几何估计准确率分割开来,检测准确率通过标准的平均精度办法(AP)来计算回归曲线的精度。我们首先计算真值曲线与预测曲线的加权欧式距离,我们计算在预先设定的各个y位置上距离,每80cm的图片距离代表实际的80m,远处的点的距离计算给予较低的权重,然后,我们通过选择减少相似性的配对来执行一对一(曲线)匹配,当他们的加权距离小于一个阈值,匹配被认为是成功的,迭代这个阈值,已获得更加精确地阈值。

对于配对的曲线,我们评估几何估计精度通过计算他们误差的分布,(这在计算距离的时候用到过),我们将整个数据集的车道线点分为近距离(0-30m)与远距离(30-80m)由于他们误差的巨大差异。然后我们计算误差为1δ误差的,比如百分之68这样,还有误差为2δ误差的,比如百分之95类似这样,道路中心线与车道线都各自用这种方法评估。在训练阶段被忽略的那些点,在评估的时候也被忽略。

4.1.2评估结果

在测试集上典型的网络结果如图2,用真值做标记。表1第一行为3D-LaneNet中心线检测定量结果。一个对合成数据集有必要的担心是,他的变换实在是太有限了,导致网络记住了整个样例空间,而不是去学习如何泛化,一个积极地结果表明这种情况没有发生是测试集的AP(0.952)略低于训练集AP(0.966)对于几何误差也是同样的。在接下来的控制变量实验中,我们都用训练好的3D-LaneNet的参数做初始化,用以减少训练时间。

表1.在synthetic-3D-lanes dataset 上的中心线检测结果

我们首先通过与其他结构进行比较来探求双通路结构的作用,只有正常视图通路的版本,将网络后部分直接连接到lane detection head 输出Croad下的3D坐标,就如完整版本那样,这个时候anchor 被最后一张特征图上的列所决定,对于每一列,我们在预定义的图像y坐标上选取一个像素,并将其投影到俯视图中,以确定与列对应的anchor。只有俯视图版本,首先将图片投影到俯视图上,然后后面继续进行和完整版本的俯视图通路同样的计算。除此之外,我们还测试了两个版本,它们包含双通路结构,但是这个机构的个数和位置不同。Early IPM版本包含一个双特征模块(dual context module),并且是第一个,late IPM同样只包含一个,不过包含的的是最后那个。结果在被总结在表格1中,结果表示了,带有完全体双特征模块的相对于其他变体有着非常好的超级表现,特别的,只有正常视图通路的有着最差的结果,这说明,俯视图通路的处理是十分有必要的。注意late ipm版本,只包含一个双特征模块,表现出了第二高的准确率,但是却减少了很多的计算,这使他成为一个可实时应用的候选模型。

我们尝试了几个版本的道路投影平面定义,这是我们架构和输出表示的核心,我们的第一个尝试是在没有显示监督的情况下,学习每个场景的最佳道路投影平面,类似于[23]中的“H-net”地平线估计,但是这种方法没有得到令人满意的结果。我们认为这一方向值得进一步研究,因为这是最自然的方向。另一个自然的选择是在拟合道路平面时考虑整个场景,而不仅仅是局部道路的发现。为此,我们设计了一种地面真值生成算法,该算法取最远处可见的道路点,并将其与当前道路位置相连接以确定俯仰角。由于这种方法类似于水平估计方法,所以在表格中将其称为水平(horizon)。显然,它的表现总的来说略差,虽然我们一直观察的情况下,场景地形有利于这一定义。我们也尝试假设一个固定的相机位置,其中平均俯仰角为(2.5◦)和相机高度(165厘米)这两个数据被用来定义Tc2r。

表格1中的最后一行显示了假定地面是平坦的图像到世界转换的结果。这通过将我们完整版的网络中估计的z设置为0来实现。尽管这个糟糕的结果有一些繁琐,并且有着高度的数据依赖性,但他还是告诉我们3D车道探测的重要性。带着0.966的AP,完整版的3D车道检测网络在车道线的检测上超过了中心线的检测,这可能是因为在图片中,车道线有比较明显的显示。在他们的位置误差分布上也是同样的(nearrange: 10.5cm@1σ,28cm@2σ; far range:27.3cm@1σ and 106cm@2σ)

既然输出从路面坐标系通过Tc2r转换到了相机坐标系,我们也评估了这种估计的质量以及他对最终结果的影响。俯仰角和相机高度误差的中位数为0.09°和2.4cm,为了消除这两个误差对最终结果所造成的影响,我们评估了Croad下的坐标,方法是通过直接拿到网络的原始输出。

5. 总结及未来工作

我们提出了一个单帧单次cnn前向传播,不需要其他后续处理工作的车道检测办法。在tuSimple benchmark 上,我们展现了富有竞争力的结果,并且在我们合成的3D车道线数据及上,我们的方法能够进行多车道的3D检测。最重要的是,接下来的研究证明了这是可以应用在真是世界的数据上的。我们现在的表示在(在纵向上的anchor,判断Yref存在与否)还比较粗糙,这限制了该方法对车道复杂拓扑结构的表示,比如城市内部,在接下来的工作中,我们会更新我们的表示方法使用端到端的机制来来处理这些情况。

- 下一篇:布鲁塞尔因辐射规则暂停5G计划

- 上一篇:NI:测试测量该如何乘上5G的快车?

最新资讯

-

大卓智能端到端直播实测,16公里复杂路段挑

2025-04-25 17:16

-

《汽车轮胎耐撞击性能试验方法-车辆法》等

2025-04-25 11:45

-

“真实”而精确的能量流测试:电动汽车能效

2025-04-25 11:44

-

GRAS助力中国高校科研升级

2025-04-25 10:25

-

梅赛德斯-AMG使用VI-CarRealTime开发其控制

2025-04-25 10:21

广告

广告