自动驾驶中方向盘控制的方法

在自动驾驶中需要深度学习根据自动驾驶车上的车载摄像头可以捕捉到画面,如下图:

深度学习控制方向盘的方向和角度有如下几个难点:

· 准确性,方向盘的控制一定要准确,深度学习一旦对方向盘转向判断错误,或者控制方向盘产生偏差,就有可能伤害到周围的行人。

· 实时性,因为车在高速行驶,所以要求算法的速度不能太慢。

· 应对不同天气情况/天线/白天/夜晚。

在没有深度学习前,传统的解决方案是:

第五步:切割出重点区域

第六步:霍夫转换(hough transform)直线检测

第八步:根据道路方向预测

总之根据输入图片,找到方法判断车道的两个边界线,然后确定汽车转动的方向和角度,要确定两条线的交接处在车的正前方。

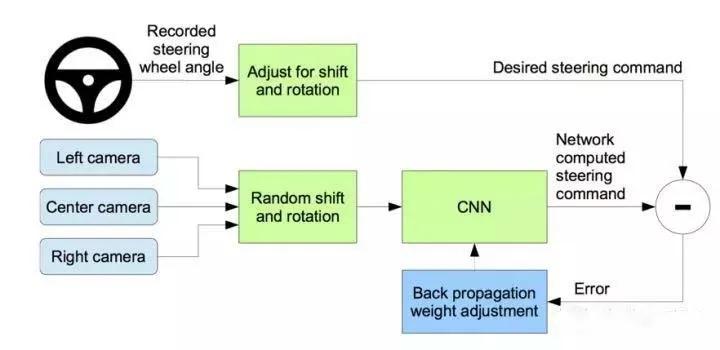

论文《End to End Learning for Self-Driving Cars》(arxiv.org/abs/1604.0731 ) 是基于深度学习的解决方案:

收集数据之后,论文中定义了一个深度神经网络,

论文中实际测试之前,在模拟器上进行了测试

论文作者还做了一个界面来观察汽车行驶(下图),帮助判断无人驾驶的安全度。

比较有趣的是把卷积神经系统的feature map,把卷积计算的数值当成当成图像的方式可视化,

论文作者还上路测试了,开了20分钟从新泽西州的holmdel到atlantic highlands,他们判断自动驾驶有效性的方法是如果自动驾驶跑偏了,人会干预纠正方向。通过公式1减去(每次人为interventions干预,假设耗时6秒钟),干预次数和6秒相乘除以总行驶时间,他们的结果再乘以100。

假设行车了600秒,中间人为干预了10次(interventions),值就是90%。(如下图)

其实在真实世界中,深度学习如果在某种情况下处理不好,我们又很难知道为什么或者怎么去调整神经网络的结构和权重,现阶段对与神经网络的微调还是很有难度的,传统的方式虽然步骤很多很繁琐,还有很多图像的技巧在里面,但是好处就是遇到处理不好地方可以加特别的处理,达到好的处理效果。所以可以在实际情况中可以把它们结合在一起,利用投票的方式,在不同的场景下采用不同的解决方案。

编辑推荐

最新资讯

-

中汽中心工程院能量流测试设备上线全新专家

2025-04-03 08:46

-

上新|AutoHawk Extreme 横空出世-新一代实

2025-04-03 08:42

-

「智能座椅」东风日产N7为何敢称“百万级大

2025-04-03 08:31

-

基于加速度计补偿的俯仰角和路面坡度角估计

2025-04-03 08:30

-

《北京市自动驾驶汽车条例》正式实施 L3级

2025-04-02 20:23

广告

广告