基于光照感知深度神经网络的多光谱数据融合行人检测

本文译自:

Fusion of Multispectral Data Through Illumination-aware Deep Neural Networks for Pedestrian Detection

文章来源:

2018 SCI Information Fusion

作者:

Dayan Guan, Yanpeng Cao, Jiangxin Yang, Yanlong Cao, Michael Ying Yang

原文链接:

https://doi.org/10.1016/j.inffus.2018.11.017

摘要:多光谱行人检测作为促进全天候应用(如安全监控和自动驾驶)鲁棒人体目标检测的一种有前景的解决方案,近年来受到了广泛关注。在本文中,我们证明了编码在多光谱图像中的光照信息可以显著提高行人检测的性能。提出了一种新的光照感知加权机制来准确描述场景的光照条件。将这些光照信息整合到双流深度卷积神经网络中,学习不同光照条件下(白天和夜间)的多光谱人体相关特征。此外,我们利用光照信息与多光谱数据结合来生成更准确的语义分割,从而提高行人检测的准确率。将所有部分放在一起,我们提出了一个强大的基于光照感知行人检测和语义分割多任务学习的多光谱行人检测框架。我们提出的方法使用精心设计的多任务损失函数进行端到端的训练,在KAIST多光谱行人数据集上表现优于最先进的方法。

关键词:多光谱融合,行人检测,深度神经网络,光照感知,语义分割

1 引言

行人检测是近几十年来计算机视觉领域的一个热门研究课题[29, 5, 8, 11, 10, 4, 41]。给定在各种现实世界监控情况下拍摄的图像,行人检测要求生成边界框,以准确定位单个行人实例。它提供了一个重要的功能,促进一系列以人体为中心的应用,如视频监控[36,1,25]和自动驾驶[37,24,39]。

尽管近年来已经取得了显著的进步,但开发一种可用于实际应用的鲁棒行人检测算法仍然是一项具有挑战性的任务。值得注意的是,现有的行人检测器大多仅使用可见光信息进行训练,因此其性能对光照、天气和遮挡的变化非常敏感[18]。为了克服上述的局限性,许多研究工作已经聚焦在开发多光谱行人检测方法上,以促进对全天候应用的鲁棒人体目标检测[22, 21, 34, 28, 16, 13]。直觉上,多光谱图像(如可见光和热图像)提供了有关感兴趣目标的互补信息,有效地融合这些数据可以得到更鲁棒、更准确的检测结果。

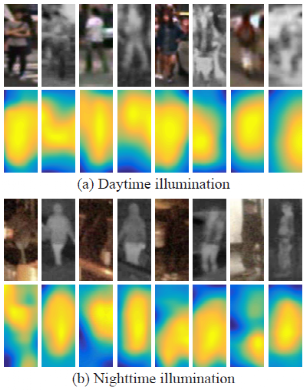

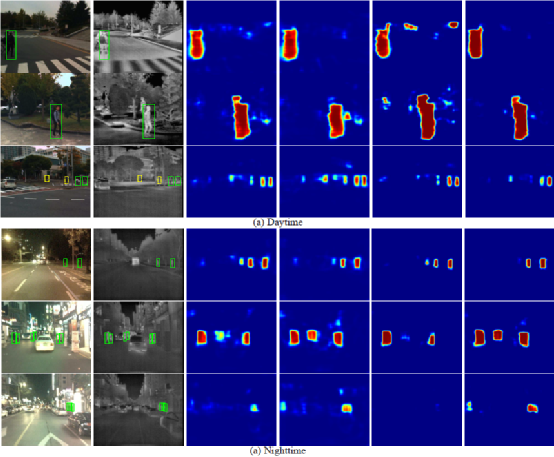

图1 在(a)白天和(b)夜间场景下拍摄的多光谱行人实例特征。(a)和(b)中的第一行是行人实例的多光谱图像。(a)和(b)中的第二行是相应行人实例特征图的可视化。可见光和热图像的特征图由在相应通道训练好的深度神经区域建议网络[38]生成。注意,多光谱行人实例在白天和夜间光照条件下展示出明显不同的人体相关特征。

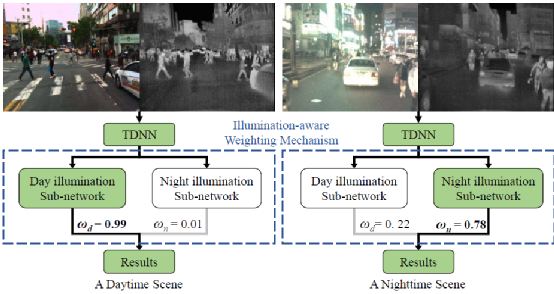

图2 光照感知加权机制的说明。给出一对对齐的可见光和热图像,双流深度神经网络(TDNN)生成多光谱语义特征图。白天-光照子网络和夜间-光照子网络利用多光谱语义特征图在不同光照条件下进行行人检测和语义分割。最终的检测结果是由多个光照感知子网络的输出融合而成。

在本文工作中,我们设计了一个框架,通过提出的光照感知深度神经网络来学习在不同光照条件下(白天和夜间)的多光谱人体相关特征。我们观察到多光谱行人实例在白天和夜间光照条件下展示出明显不同的人体相关特征,如图1所示,因此利用多个内置的子网络,每个子网络专门捕捉特定光照的视觉形态,提供一种有效的方案来处理大量由不同光照条件导致的类间差异,以实现更鲁棒的目标探测。根据多光谱数据对光照信息进行鲁棒估计,并将光照信息引入到多个光照感知子网络中学习多光谱语义特征图,用于不同光照条件下的鲁棒行人检测和语义分割。给出一对白天捕获的多光谱图像,我们提出的光照感知加权机制自适应地为白天-光照子网络(行人检测和语义分割)分配一个高权重来学习白天的人体相关特征。与此相对,夜间场景的多光谱图像被用来生成夜间-光照特征。我们在图2中说明了这种光照感知加权机制是如何工作的。最终的检测结果是由多个光照感知子网络的输出融合而成,在场景光照变化中对大的变化保持鲁棒性。本文工作有以下几点贡献。

首先,我们证明了通过一种考虑多光谱语义特征的全连接神经网络架构可以鲁棒地确定场景的光照条件,且估计的光照信息为提高行人检测性能提供了有用的信息。

其次,我们将光照感知机制整合到双流深度卷积神经网络中,以学习不同光照条件下(白天和夜间)的多光谱人体相关特征。据我们所知,这是探索光照信息用于训练多光谱行人检测器的首次尝试。

第三,我们提出了一个基于光照感知行人检测和语义分割多任务学习的完整的多光谱行人检测框架,并利用精心设计的多任务损失对其进行端到端的训练。与最先进的多光谱行人检测器相比,我们的方法获得了更低的遗漏率和更快的运行时间[16,18,19]。

本文其余部分组织如下。在第2节中,我们回顾了一些现有的多光谱行人检测方法。第3节介绍了我们提出的光照感知深度神经网络的细节。第4节对多光谱行人检测方法进行了广泛的实验比较,第5节总结了本文。

2 相关研究

使用可见光和多光谱图像的行人检测方法与我们的工作密切相关。我们在下面对这些主题的最新研究进行综述。

可见光行人检测。利用可见光信息进行行人检测已有大量方法被提出。Piotr等人提出的融合通道特征(ICF)行人检测器基于特征金字塔和增强分类器[6]。其性能通过多种方法包括ACF[7]、LDCF[27]、Checkerboards[40]等得到进一步提高。最近,基于DNN的目标检测方法[12, 31, 15]已经被用于提高行人检测的性能。Li等人[23] 提出了一种尺度感知的深度网络框架,将一个大尺度的子网络和一个小尺度的子网络组合成一个统一的架构,以描述不同尺度下行人的独特特征。Cai等人[3]提出了一种统一的多尺度深度神经网络架构,将互补的特定尺度的检测器组合在一起,从而提供大量的感受野来匹配不同尺度的对象。Zhang等人[38]利用高分辨率卷积特征图进行分类,并提出了一种利用区域建议网络(RPN)加上增强森林的行人检测有效流程。Mao等人[26]提出了一种新的网络架构,联合学习行人检测以及给定的额外特征。这种多任务训练方案能够利用给定特征的信息,在推理阶段无额外输入的情况下提高检测性能。Brazil等人[2] 开发了一种引入分割的网络,通过对语义分割和行人检测的联合监督来提高行人检测的准确率。事实证明,弱注释框提供了足够的信息获得可观的性能提升。

多光谱行人检测。多光谱图像提供了有关感兴趣目标的互补信息,因此利用多模态数据源训练的行人检测器产生鲁棒的检测结果。Hwang等人[16]建立了一个大规模多光谱行人数据集(KAIST)。使用对齐好的标有密集的行人注释的可见光和热图像对,作者提出了一种新的多光谱聚合特征(ACF+T+THOG)来处理彩色-热图像对,并应用了增强决策树(BDT)进行目标分类。Wagner等人[35]首次将DNN应用于多光谱行人检测,并对两种决策网络(early-fusion和late-fusion)的性能进行了评估。这些决策网络对ACF+T+THOG[16]生成的行人候选框进行验证,从而获得更准确的检测结果。Liu等人[18]研究了如何利用Faster R-CNN[31]来完成多光谱行人检测任务,并设计了四种卷积网络融合结构,其中双分支卷积网络是在DNN不同阶段融合的。最优的结构是Halfway Fusion,该模型利用中层卷积特征融合双分支卷积网络。Konig等人[19] 修改了RPN + BDT[38]的架构,构建了用于多光谱行人检测的Fusion RPN + BDT。Fusion RPN融合了中层卷积特征上的双分支RPN,在KAIST多光谱数据集上获得了最先进的性能。我们的方法明显不同于上述方法,它开发了一个在不同光照条件下(白天和夜间)通过提出的光照感知多光谱深度神经网络学习多光谱人体相关特征的框架。据我们所知,这是探索光照信息用于提高多光谱行人检测性能的首次尝试。

3 我们的方法

3.1 提出模型概述

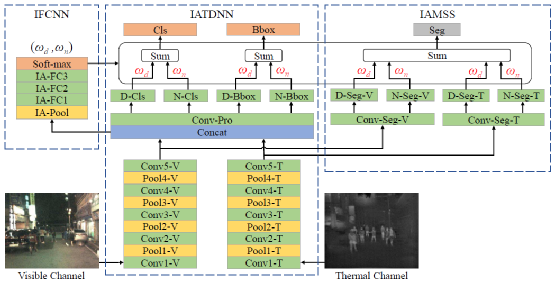

图3 我们提出的光照感知多光谱深度神经网络(IATDNN+IASS)的架构。注意,绿色方框表示卷积层和全连接层,黄色方框表示池化层,蓝色方框表示融合层,灰色方框表示分割层,橙色方框表示输出层。最好用彩图观看。

光照感知多光谱深度神经网络的架构如图3所示。它由三个集成处理模块组成,分别是光照全连接神经网络(IFCNN)、光照感知双流深度卷积神经网络(IATDNN)和光照感知多光谱语义分割(IAMSS)。给定对齐的可见光和热图像,IFCNN计算光照感知权重,以确定它是白天场景还是夜间场景。通过提出的光照感知机制,IATDNN和IASS利用多个子网络生成检测结果(分类分数- Cls和边界框- Bbox)和分割掩膜(Seg)。例如,IATDNN使用两个独立的分类子网络(D-Cls和N-Cls)分别在白天和夜间光照条件下对行人进行分类。将每个子网络的Cls、Bbox和Seg结果结合起来,通过根据场景光照条件定义的门函数得到最终输出。基于光照感知行人检测和语义分割的多任务学习,对该方法进行端到端的训练。

3.2 光照全连接神经网络(IFCNN)

如图3所示,将一对可见光和热图像送入双流深度卷积神经网络(TDNN)[19]的前5个卷积层和池化层,提取出单个通道的语义特征图。注意TDNN中特征提取层的每个流(可见光图像流的Conv1-V到Conv5-V、热图像流的Conv1-T到Conv5-T)采用VGG16[33]的1-5层卷积层作为backbone。然后融合两个通道的特征图,通过一个连接层(Concat)生成双流特征图(TSFM)。TSFM用作IFCNN的输入,计算决定场景光照条件的光照感知权重

IFCNN由一个池化层(IA-Pool)、三个全连接层(IA-FC1、IA-FC2、IA-FC3)和soft-max层(Soft-max)组成。类似于空间金字塔池化(SPP)层,消除了网络的固定大小约束[14],IA-Pool使用双线性插值将TSFM的特征调整为固定尺度的图(7×7),并为全连接层生成固定大小的输出。IA-FC1、IA-FC2、IA-FC3的通道数根据经验分别设置为512、64、2。Soft-max是IFCNN的最后一层。Soft-max的输出为

其中

3.3 光照感知双流深度卷积神经网络(IATDNN)

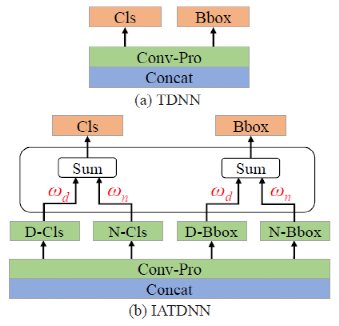

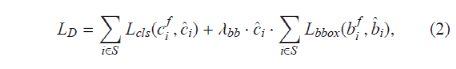

IATDNN架构是基于双流深度卷积神经网络(TDNN)[19]设计的。采用了区域建议网络(RPN)模型[38]由于其优越的行人检测性能。给定单个输入图像,RPN输出大量与置信度分数关联的边界框,通过分类和边界框回归生成行人建议。如图4(a)所示,一个3×3卷积层(Conv-Pro)连接在Concat层之后,再附加两个兄弟1×1卷积层(Cls和Bbox)分别用于分类和边界框回归。TDNN模型提供了一个有效的框架,利用双流特征图(TSFM)进行鲁棒行人检测。

图4 TDNN和IATDNN架构的比较。注意

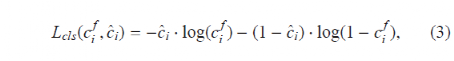

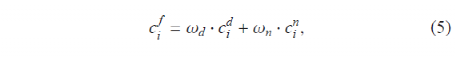

我们进一步将光照信息整合到TDNN中,以生成不同光照条件下的分类和回归结果。具体而言,IATDNN包含4个子网络(D-Cls、N-Cls、D-Bbox、N-Bbox)来产生光照感知的检测结果,如图4(b)所示。D-Cls和N-Cls分别计算白天和夜间光照条件下的分类得分,D-Bbox和N-Bbox分别生成白天和夜间场景的边界框。对这些子网络的输出使用IFCNN中计算出的光照权重进行组合,从而产生最终的检测结果。检测损失项

其中

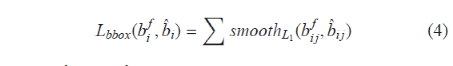

回归损失项

其中

通过上述光照加权机制,在白天场景下,白天-光照子网络(分类和回归)将被给予一个高优先级来学习人体相关特征。另一方面,利用夜间场景的多光谱特征图,在夜间光照条件下生成可靠的检测结果。

3.4 光照感知语义分割(IASS)

最近,语义分割掩膜已被成功地用作强线索提高单通道目标检测的性能[15,2]。简单的基于边界框的分割掩膜提供了额外的监督,引导共享层中的特征对下游行人检测器变得更为显著。在本文中,我们将语义分割方案与双流深度卷积神经网络相结合,实现对多光谱图像上的行人同时检测和分割。

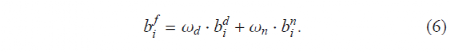

图5 MSS-F、MSS、IAMSS-F和IAMSS架构的比较。注意,绿色方框表示卷积层,蓝色方框表示融合层,灰色方框表示分割层。最好用彩图观看。

给定来自两个多光谱通道(可见光通道和热通道)的信息,在不同阶段(特征阶段和决策阶段)的融合会导致不同的分割结果。因此,我们希望研究一种适合多光谱分割任务的最佳融合结构。为此,我们设计了两种在不同阶段进行融合的多光谱语义分割架构,分别为特征阶段多光谱语义分割(MSS-F)和决策阶段多光谱语义分割(MSS)。如图5(a)-(b)所示,MSS-F首先将Conv5-V和Conv5-T的特征图融合起来,然后应用一个公共的Conv-Seg层产生分割掩膜。相比之下,MSS使用两个卷积层(Conv-seg-V和Conv-seg-T)为每个通道产生不同的分割图,然后结合两个流的输出生成最终的分割掩膜。

此外,我们希望研究考虑场景的光照条件能否提高语义分割的性能。基于MSS-F和MSS架构,我们设计了另外两种光照感知的多光谱语义分割架构(IAMSS-F和IAMSS)。如图5(c)-(d)所示,我们使用了两个分割子网络(D-Seg和N-seg)来生成光照感知语义分割的结果。注意IAMSS-F包含两个子网络,IAMSS包含四个子网络。通过光照加权机制,利用IFCNN预测的光照权重融合这些子网络的输出,生成多光谱语义分割。在第4节中,我们给出了这四种不同的多光谱分割架构的评估结果。

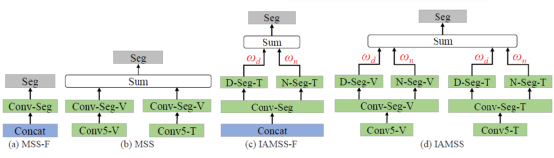

这里我们定义分割损失项为

其中

为进行光照感知行人检测和语义分割的多任务学习,我们将式1、2、7定义的损失项组合,得到最终的多任务损失函数如下

其中

4 实验

4.1 实验设置

数据集:我们的实验是利用公共数据集KAIST多光谱行人基准[16]进行的。总的来说,KAIST训练数据集包含50172张对齐的彩色-红外图像对,这些图像对拍摄于不同的城市地点、不同的光照条件下,带有密集的标注。我们每2帧对图像进行采样,并按照Konig等人[19]提出的方法获得25086张训练图像。KAIST的测试集包含2252对图像,其中797对是在夜间拍摄的。“合理”设置(行人大于55像素,至少50%可见)下的原始注释用于性能评估[16]。

实现细节:我们采用以图像为中心的训练方案,生成1幅图像和随机选取的120个anchor组成的mini-batch。如果anchor与某一真值边界框的交并比(IoU)大于0.5,则认为该anchor为正样本,否则为负样本。TDNN每个流中的前5个卷积层(可见光图像流的Conv1-V到Conv5-V、热图像流的Conv1-T到Conv5-T)使用在ImageNet数据集[32]上预训练的VGG-16[33]深度卷积神经网络参数并行初始化。所有其他卷积层和全连接层都以标准偏差(0.01)的零均值高斯分布进行初始化。深度神经网络是在Caffe[17]框架下训练的,采用随机梯度下降(SGD)[42],动量项为0.9,权重衰减为0.0005[20]。为了避免因梯度爆炸[30]导致的学习失败,我们使用了阈值10来对梯度削波。

评估指标:我们使用对数平均遗漏率(MR)[7]来评估多光谱行人检测算法的性能。如果检测的边界框结果能够成功匹配到某一真值边界框(IoU超过50%[16]),则认为该结果为真阳性。未匹配到的检测边界框和未匹配到的真值边界框分别被认为是假阳性和假阴性。根据Dollar等人[7]提出的方法,与被忽略的真值边界框匹配的检测边界框不被视为真阳性,同样未被匹配的被忽略的真值边界框标签不被视为假阴性。MR通过在

4.2 IFCNN评估

光照加权机制在我们提出的光照感知深度神经网络中提供了一个必要的功能。我们首先评估IAFCNN能否准确计算出提供关键信息的光照权重,以平衡光照感知子网络的输出。我们使用KAIST测试集来评估IAFCNN的性能,其中包含白天(1455帧)和夜间(797帧)拍摄的多光谱图像。给出一对对齐的可见光和热图像,IAFCNN将输出白天的光照权重

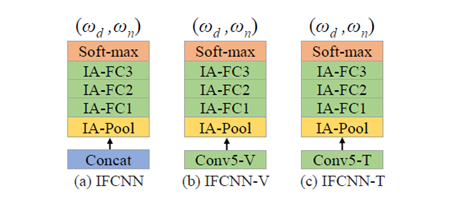

图6 IFCNN、IFCNN-V和IFCNN-T的架构。注意,绿色方框表示卷积层和全连接层,黄色方框表示池化层,蓝色方框表示融合层,橙色方框表示soft-max层。最好用彩图观看。

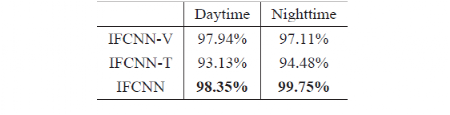

表1 使用IFCNN-V、IFCNN-T和IFCNN的光照预测准确率

结果表明,使用来自可见光图像通道的信息可以对白天和夜间场景(白天- 97.94%和夜间-97.11%)都生成可靠的光照预测。这个结果是合理的,因为人类可以很容易地根据视觉观察确定这是一个白天场景还是一个夜间场景。虽然热图像通道不能单独用于光照预测,但它提供了对可见光图像通道的补充信息,从而提高了光照预测的性能。通过对可见光和热图像通道互补信息的融合,IFCNN比IFCNN-V(仅使用可见光图像)或IFCNN-T(仅使用热图像)计算出更精确的光照权重。实验结果表明,通过考虑多光谱语义特征,基于我们提出的IFCNN能够鲁棒地确定场景的光照条件。

4.3 IATDNN评估

我们进一步评估光照信息能否用来提高多光谱行人检测器的性能。具体来说,我们比较了TDNN和IATDNN的性能。为了公平比较,TDNN和IATDNN两种架构都没有考虑语义分割的信息。我们结合式1中定义的光照损失项和式2中定义的检测损失项来联合训练IAFCNN和IATDNN,并使用检测损失项训练TDNN。TDNN模型提供了一种利用双流特征图(TSFM)进行鲁棒行人检测的有效框架[19]。然而,它没有区分在白天和夜间光照条件下的人体实例,使用一个公共的Con-Prov层生成检测结果。相比之下,IATDNN应用光照加权机制自适应地组合多个光照感知子网络(D-Cls、N-Cls、D-Reg、N-Reg)的输出,生成最终的检测结果。

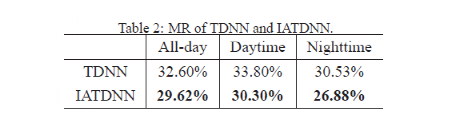

表2 IDNN和IATDNN的MR

使用对数平均遗漏率(MR)作为评估指标,IATDNN和TDNN的检测精度如表2所示。通过考虑场景的光照信息,IATDNN能够显著提高白天和夜间场景的检测精度。值得一提的是,这样的性能提升(TDNN 32.60% 对比 IATDNN 29.62% MR)是以很小的计算开销为代价实现的。基于单个Titan X GPU, TDNN模型需要0.22s来处理KAIST数据集中的一对可见光和热图像(640×512像素),而IATDNN模型需要0.24s。第4.5节提供了更多计算效率的比较结果。实验结果表明,基于多光谱数据我们能够鲁棒地估计光照信息,并进一步引入多个光照感知子网络中,更好地学习人体相关特征图,从而提高行人检测器的性能。

4.4 IAMSS评估

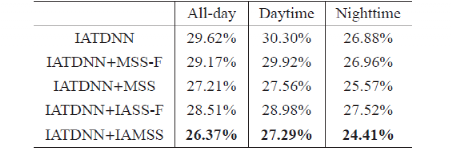

我们通过将语义分割方案与IATDNN结合来评估性能的提高。这里我们比较了用于行人检测的四种不同的多光谱语义分割模型,包括MSS-F(特征阶段MSS)、MSS(决策阶段MSS)、IAMSS-F(光照感知的特征阶段MSS)、IAMSS(光照感知的决策阶段MSS)。这四种模型的架构如图5所示。MSS模型输出大量基于边界框的分割掩膜,这样的弱注释边界框提供了额外信息,从而能够训练IATDNN中更显著的特征。表3比较了IATDNN、IATDNN+MSS-F、IATDNN+MSS、IATDNN+IAMSS-F、IATDNN+IAMSS的检测性能。

表3 IATDNN、IATDNN+SS和IATDNN+IASS的MR比较

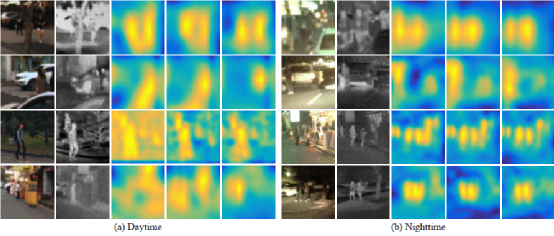

值得注意的是,使用四种不同的多光谱语义分割模型(除了夜间场景使用IATDNN+MSS-F),一般都可以通过行人检测和语义分割的联合训练来获得性能的提高。其基本原理是,语义分割掩膜将提供额外的监督,以促进训练更复杂的特征,从而实现更鲁棒的行人检测[2]。另一个观察结果是,融合方案的选择(特征阶段还是决策阶段)会显著影响检测性能。结果表明,决策阶段融合的多光谱语义分割模型(MSS和IA-MSS)优于特征阶段融合模型(MSS-F和IA-MSS-F)。对这一现象的一种可能解释是,后融合策略(如决策阶段融合)更适合结合高水平的分割结果。寻找最优的分割融合策略来处理多光谱数据将是我们未来的研究方向。最后,考虑场景的光照条件可以提高语义分割的性能。通过光照加权机制自适应地融合子网络输出,在不同光照条件下生成更准确的分割结果。图7显示了使用四种不同MSS模型的语义分割结果的比较。观察到,IATDNN+IASS(使用光照)生成的语义分割可以更准确地覆盖小目标,抑制背景噪声。更准确的分割可以提供更好的监督来训练最显著的人体相关特征图。

在图8中我们可以看到TDNN、IATDNN和IATDNN+IAMSS的特征图,来了解不同的光照感知模块所实现的改进增益。我们发现,与TDNN相比,IATDNN通过将光照信息整合到多个光照感知子网络中以更好地学习人体相关特征图,生成了更多显著的行人特征。IATDNN+IASS通过分割引入方案可以实现进一步的提高,该方案使用光照感知的可见光和热图像语义分割掩膜来监督特征图的训练。

图7 使用四种不同多光谱语义分割模型生成的多光谱行人语义分割结果示例。(a)和(b)的前两列分别显示了可见光图像和热图像的行人实例。(a)和(b)的第三至第六列分别显示了MSS-F、MSS、IAMSS-F和IAMSS生成的语义分割。注意,绿色实线边界框(BBs)表示正样本标签,黄色虚线BBs表示忽略的标签。最好用彩图观看。

图8 在(a)白天和(b)夜间场景中,由光照感知机制提升的多光谱行人特征图示例。(a)和(b)的前两列分别显示可见光图像和热图像的行人实例。(a)和(b)的第三至第五列分别为TDNN、IATDNN和IATDNN+IASS生成的特征图可视化。注意,通过逐步插入我们提出的两个光照感知模块IA(用于分类和边界框回归)和IASS(用于生成多光谱语义分割)来改进多光谱行人的特征图。

4.5与最先进的多光谱行人检测方法比较

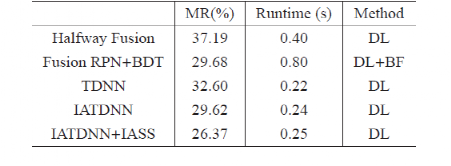

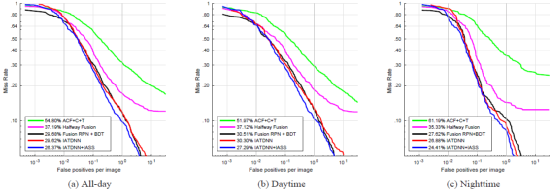

我们提出的IATDNN和IATDNN+IASS与其他三种多光谱行人检测器:ACF+T+THOG[16]、Halfway Fusion[18]和Fusion RPN+ BDT[19]进行了比较。为了比较检测器,我们通过改变检测置信度的阈值,绘制MR-FPPI曲线(使用log-log绘制),如图9所示。

我们提出的IATDNN+IASS在全天场景取得了杰出的26.37%的MR。与目前最先进的多光谱行人检测方法Fusion RPN+BDT(29.68%)相比,性能有11%的相对提升率。同时,提出检测器的性能在白天(27.29%对比30.51%)和夜间(24.41%对比27.62%)都超过了最先进的方法。

此外,我们提出的IATDNN在不使用语义分割架构的情况下,可以实现与最先进的方法相当的性能(白天:IATDNN(30.30%)对比Fusion RPN+BDT(30.51%)以及夜间:IATDNN(26.88%)对比Fusion RPN+BDT(27.62%))。

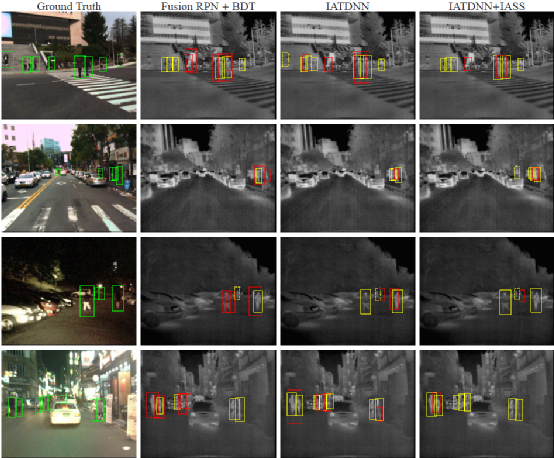

我们将Fusion RPN+BDT和我们提出的IATDNN、IATDNN+IASS的一些检测结果可视化如图10。与Fusion RPN+BDT相比较,我们提出的IATDNN和IATDNN+IASS能够在不同光照条件下成功检测大多数行人实例。同时结合光照感知的语义分割,减少了重复检测导致的假阳性。

此外,我们比较了IATDNN+IASS、IATDNN、TDNN和最先进方法的计算效率,如表4所示。在多光谱行人检测方面,IATDNN+IASS的效率大大超过了目前最先进的深度学习方法,运行时0.25s/每张图像对比0.40s/每张图像。Halfway Fusion架构是TDNN和Fast R-CNN的结合[12]。可以看出,Fast R-CNN模型使计算效率几乎减半。同时,Fusion RPN+BDT架构是TDNN和增强森林的集成。我们可以观察到,增强模块非常耗时,将运行时间增加了3倍。值得注意的是,我们提出的光照感知加权网络对网络效率的影响很小,与TDNN相比是0.25s对比0.22s。

表4 比较IATDNN+IASS和最先进方法的MR(全天)和运行时间性能。利用单个Titan X GPU对计算效率进行评估。注意DL表示深度学习,BF表示增强森林[9]。

图9 “合理“设置下在全天(a)、白天(b)、夜间(c) KAIST测试集上的比较(标签表示MR)

图10 与目前最先进方法(Fusion RPN + BDT)行人检测结果的比较。第一列为带真值的输入多光谱图像(展示了可见光图像通道),其余为Fusion RPN + BDT、IATDNN、IATDNN+IASS的检测结果(展示了热图像通道)。注意,绿色实线边界框(BBs)表示正样本标签,绿色虚线BBs表示忽略的标签,黄色实线BBs表示真阳性,黄色虚线BBs表示忽略标签的检测,红色BBs表示假阳性。最好用彩图观看。

5 总结

本文提出了一种功能强大的多光谱行人检测器,它基于光照感知行人检测和语义分割的多任务学习。利用编码在多光谱图像中的光照信息计算光照感知权重。我们证明了我们设计的光照全连接神经网络(IFCNN)可以准确地预测权重。提出了一种新的光照感知加权机制,将白天和夜间光照子网络(行人检测和语义分割)结合起来。实验结果表明,光照感知加权机制为多光谱行人检测器的性能提升提供了一种有效的策略。此外,我们探索了四种不同的多光谱语义分割架构,发现光照感知决策阶段融合的多光谱语义分割生成最可靠的输出。在KAIST基准上的实验结果表明,我们所提出的方法优于目前最先进的方法,并且使用更少的运行时间获得了更准确的行人检测结果。

参考文献

- 下一篇:典型V2X通信技术标准化进展及对比分析研究

- 上一篇:汽车测试假人的路该怎么走?

编辑推荐

最新资讯

-

飞书项目落地ASPICE解决方案,助力汽车软件

2025-04-24 09:59

-

驾驶员监控系统DMS合规认证的“中西结合”

2025-04-24 08:23

-

自动驾驶汽车测试关键行人场景生成

2025-04-23 17:12

-

R171.01对DCAS的要求⑧

2025-04-23 17:08

-

迄今为止最先进的版本:imc发布全新imc STU

2025-04-23 17:06

广告

广告