基于雷达与摄像机数据融合的自动驾驶目标检测新方法(下)【译文版】

1 基于视觉的车辆和行人检测

在车辆和行人检测中,基于机器学习的算法是最常用的方法。基于机器学习的车辆和行人检测算法的核心技术是特征提取和分类。特征提取方法包括类Haar特征、LBP特征、edgelet特征、SIFT特征、HOG特征等。分类算法包括决策树、神经网络、贝叶斯分类、支持向量机(SVM)、k最近邻分类算法等。在选择检测算法时,梯度方向直方图(HOG)特征可以很好地表达图像的边缘,满足行人和车辆检测的要求。同时,支持向量机(SVM)算法也是一种很好的分类算法,可以通过训练超平面对数据进行分类。因此,我们采用了基于HOG特征和SVM分类器的车辆和行人检测算法。在车辆和行人检测方面,本文重点介绍了在获得车辆和行人雷达产生的区域后,如何使用雷达生成的区域来检测车辆和行人。

特征提取

梯度方向直方图(HOG)特征通过计算图像局部区域的梯度信息来表示对象的边缘特征。它在局部几何形状和光学变化方面具有良好的不变性。车辆和行人的信息主要是边缘部分的梯度信息,因此已被广泛应用于行人和车辆的检测中。

为了提取HOG特征,本文使用了Dali等人提出的方法。

1.将图像转换为灰度,如图5和图6所示。

2.使用gamma校正方法对输入图像的色彩空间进行标准化,调整图像对比度,减少局部阴影和照明变化的影响。gamma压缩公式:

推荐的gamma = 0.5。

3.计算每个像素的梯度和方向,获取图像轮廓信息。图像中像素(x,y)的梯度为:

在公式中,Gx(x, y),Gy(x, y),H(x, y) 分别表示输入图像中像素(x, y) 的水平渐变、垂直渐变和像素值。像素(x, y) 的梯度幅度和梯度方向为:

4.将图像分成小块,称为单元。

5.获取每个单元格的直方图统计信息,形成每个单元格的描述符。

6.每个块由几个单元组成,包括所有单元特征描述符。

7.图像的所有HOG特征描述符构成图像的特征向量。

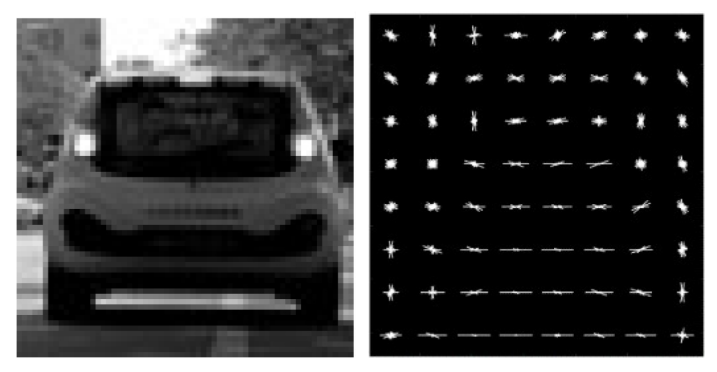

在车辆检测方面,滑动窗口被缩放为64 x 64像素,每个小块包括8 x 8像素。在梯度方向上,它分为九个块,一个块包含2 x 2个相邻单元。相邻的块重叠,步长与小块一样大。最后,将变换后的HOG字符描述为长度为1764的向量,车辆灰度及其HOG特征图如下所示:

a. 灰阶 b. HOG特征图

图5. 车辆的灰度及其HOG特征图

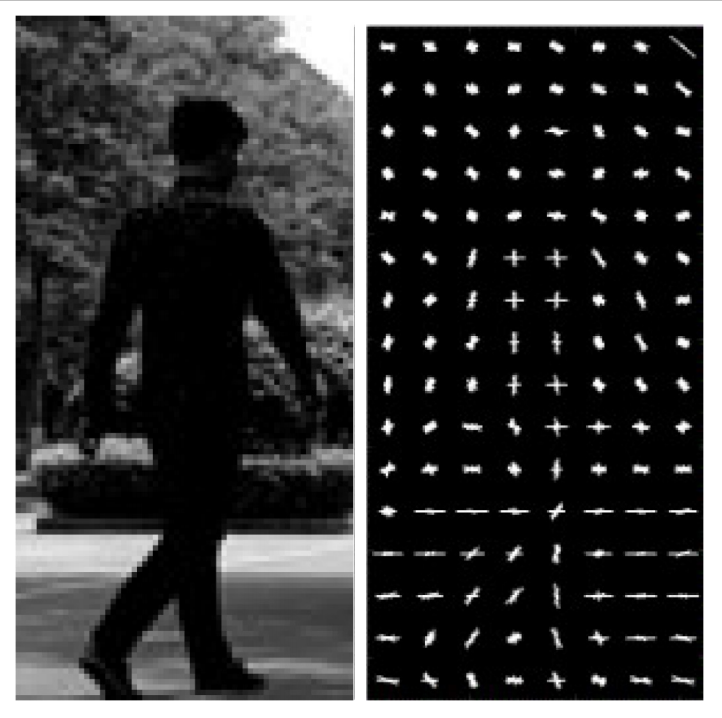

在行人检测方面,滑动窗口被缩放为128 x 64像素。其他设置类似于车辆设置。最后,HOG字符被描述为长度为3780的向量。行人的灰度及其HOG特征图如下所示:

a. 灰阶 b. HOG特征图

图6. 行人的灰度及其HOG特征图。

训练支持向量机

在支持向量机(SVM)的训练中,样本的选择对训练结果有很大的影响。有效样本数量越多,结果越接近真实。车辆检测样本来自KITTI 和GTI 车辆图像数据库,以及我们自己制作的样本。阳性样本包括通过汽车摄像头收集道路上的背面和侧面的车辆。阴性样本包括道路,车道线,护栏等。

行人检测样本来自CVC行人数据库和我们自己制作的一些样本。样本库用于高级驾驶辅助系统研究中的行人检测。阳性样本包括道路区域所有方向的行人。负样本包括非行人区域的道路区域。这些样本能够满足道路行人检测的需要。

图像的HOG特征向量被用作SVM的输入数据以训练分类器。同时,车辆和行人检测需要使用线性SVM分类方法在高精度和速度之间取得平衡。因此,通过交叉验证的方法将样本划分为测试集,并分别训练车辆和行人检测分类器。

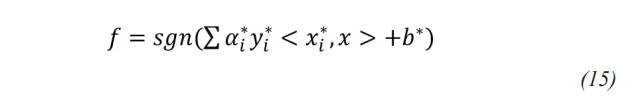

最后,训练后的线性SVM判别函数为:

x* 是支持向量,α* 是支持系数,b* 是偏移量。

滑动窗口检测

滑动窗口检测表示从单个输入图像源生成的一组窗口。窗口具有不同的大小,可以在不同的距离检测目标。窗口应覆盖目标大小的最大范围。检测窗口如下所示,不同颜色的窗口使用不同距离的检测目标。

图7. 检测窗口

2 目标融合

由于环境背景噪声,雷达在速度和距离测量中具有很高的精度,并且检测静态目标的能力有限。但是,摄像机可以检测特定场景中的静态或动态行人或车辆。因此,目标融合算法需要同时利用两者。

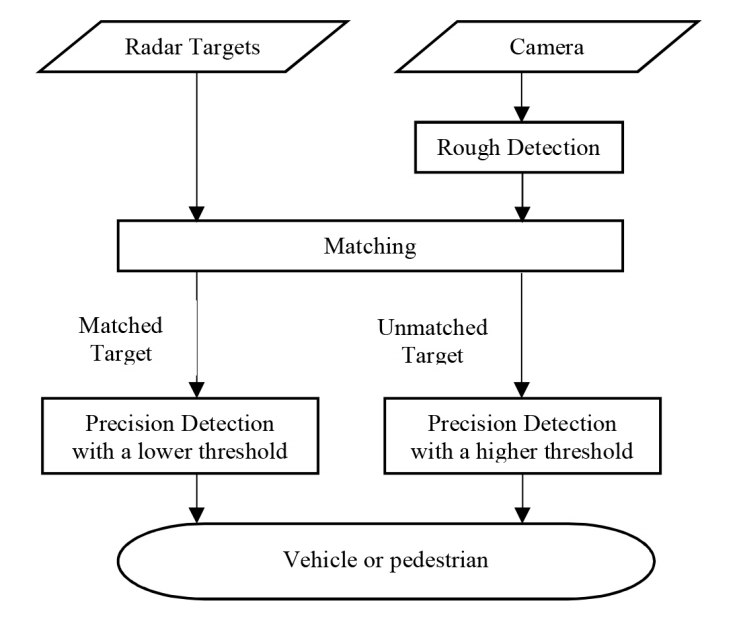

图8显示了融合算法图。雷达和摄像机的数据进行了高水平的融合。在视觉过程中,检测车辆和行人都在滑动窗口中进行,再根据雷达生成的区域对目标进行匹配。最后,由数据融合系统输出融合结果。

图8. 融合算法流程图

匹配

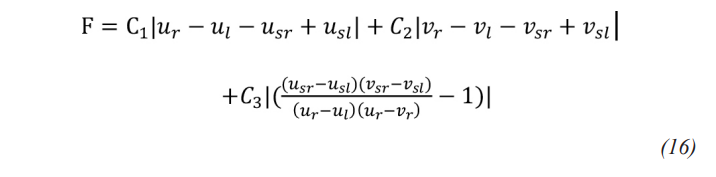

雷达在图像像素坐标系中生成的区域的左上角和右下角的坐标为[ul νl] [ur νr]。滑动窗口的左上角和右下角的坐标为[usl νsl],[usr νsr]。

实际上,由于车辆间距和非平坦道路,雷达数据生成的区域不等同于目标的滑动,由于雷达数据中存在较大的横向误差,[ul νl] , [ur νr] 不等于 [usl νsl],[usr νsr]。

不同距离的目标可以得到不同大小的雷达数据区域。然后通过匹配函数选择最合适的框架。

一个简单的匹配函数考虑了紧密接近的情况,此时的区域定义为:

其中C1和C2,C3是可调整的重量值。在视觉过程中,对粗略检测后雷达与视觉目标之间的所有匹配测量值进行计算并分类。然后对这些结果进行排序,并确定其是否大于阈值。

检测

训练了两种不同规模的分类,用于粗略检测和精确检测。粗略的检测分类可以快速过滤掉不合理的目标,而精密的检测分类可以正确检测车辆和行人。粗略检测和精确检测的区别在于训练和检测图像的规模。另外,使用具有较低阈值的精度检测分类来检测匹配的目标,并且使用具有较高阈值的精度检测分类来检测未匹配的目标。最后,通过合并和提取滑动窗口,可以检测到目标。

结 果

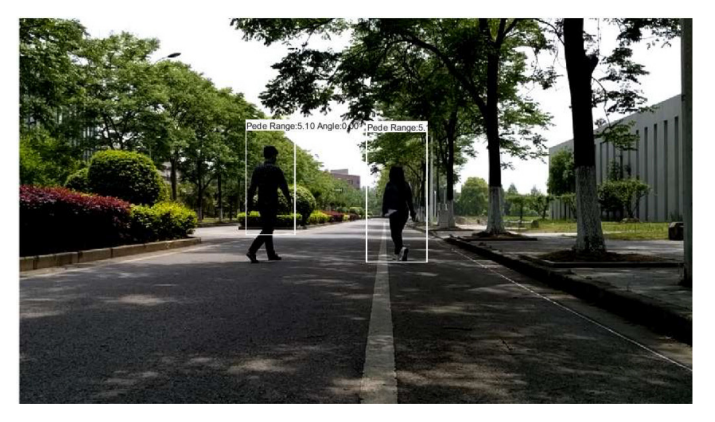

如图8和图9所示,可以获得车辆和行人的检测数据。此外,可以从雷达数据中获取匹配目标的距离和速度。

a. 车辆检测图 b. 行人检测图

图9. 车辆和行人检测图

a. 车辆在实验中的检测结果。

b. 实验中行人的检测结果

图10.实验中的检测结果

3 总 结

本文提出了一种基于雷达和摄像机数据融合的车辆与行人检测方法,并基于动态区域和目标融合算法完成了对车辆和行人的识别。测试表明,该算法能够准确地检测出车辆和行人。车辆和行人检测是高级驾驶辅助系统中最重要的部分之一。本文仅将雷达和摄像机的数据融合在一起,仅检测车辆和行人。因此,接下来将对基于融合算法的视觉检测与跟踪开展进一步研究。

本文译自:《A New Method of Target Detection based on Autonomous Radar and Camera Data Fusion》

会议名称:Intelligent and Connected Vehicles Symposium

作者:Xin Bi, Bin Tan, etc.

编辑推荐

最新资讯

-

大卓智能端到端直播实测,16公里复杂路段挑

2025-04-25 17:16

-

《汽车轮胎耐撞击性能试验方法-车辆法》等

2025-04-25 11:45

-

“真实”而精确的能量流测试:电动汽车能效

2025-04-25 11:44

-

GRAS助力中国高校科研升级

2025-04-25 10:25

-

梅赛德斯-AMG使用VI-CarRealTime开发其控制

2025-04-25 10:21

广告

广告