科恩实验室最新自动驾驶安全研究成果发布于安全顶会USENIX Security 2021-以人造扰动欺骗车道线检测系统

科恩实验室在2019年发布了对Telsa Autopilot [1]的研究,其中一项研究成果实现了对车道线系统的攻击。具体来说,我们在路面部署干扰信息后,可导致车辆经过时对车道线做出错误判断,致使车辆驶入反向车道。然而这种攻击依赖于人工调试,让攻击不够高效,不够自动化且不够隐蔽。

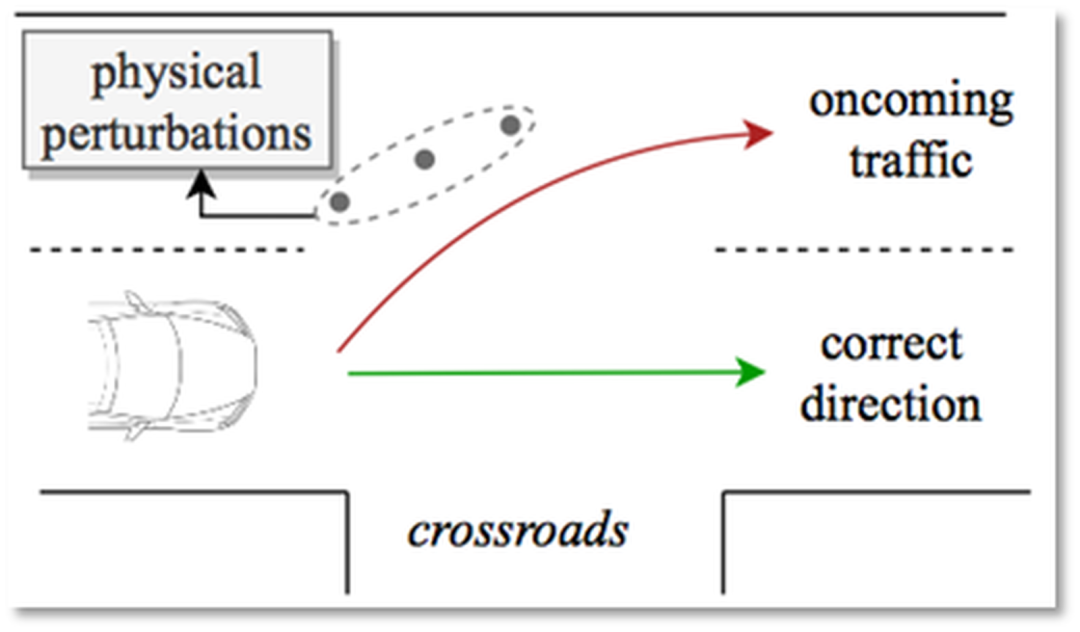

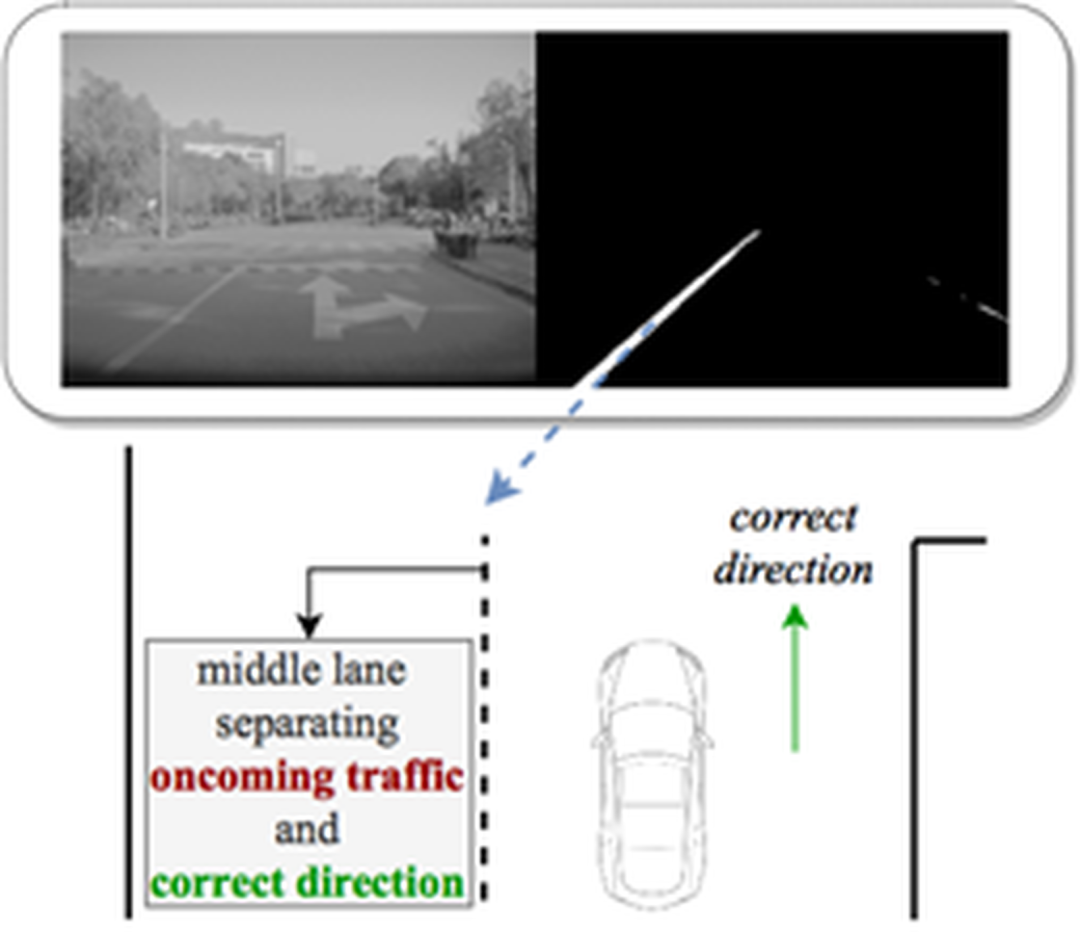

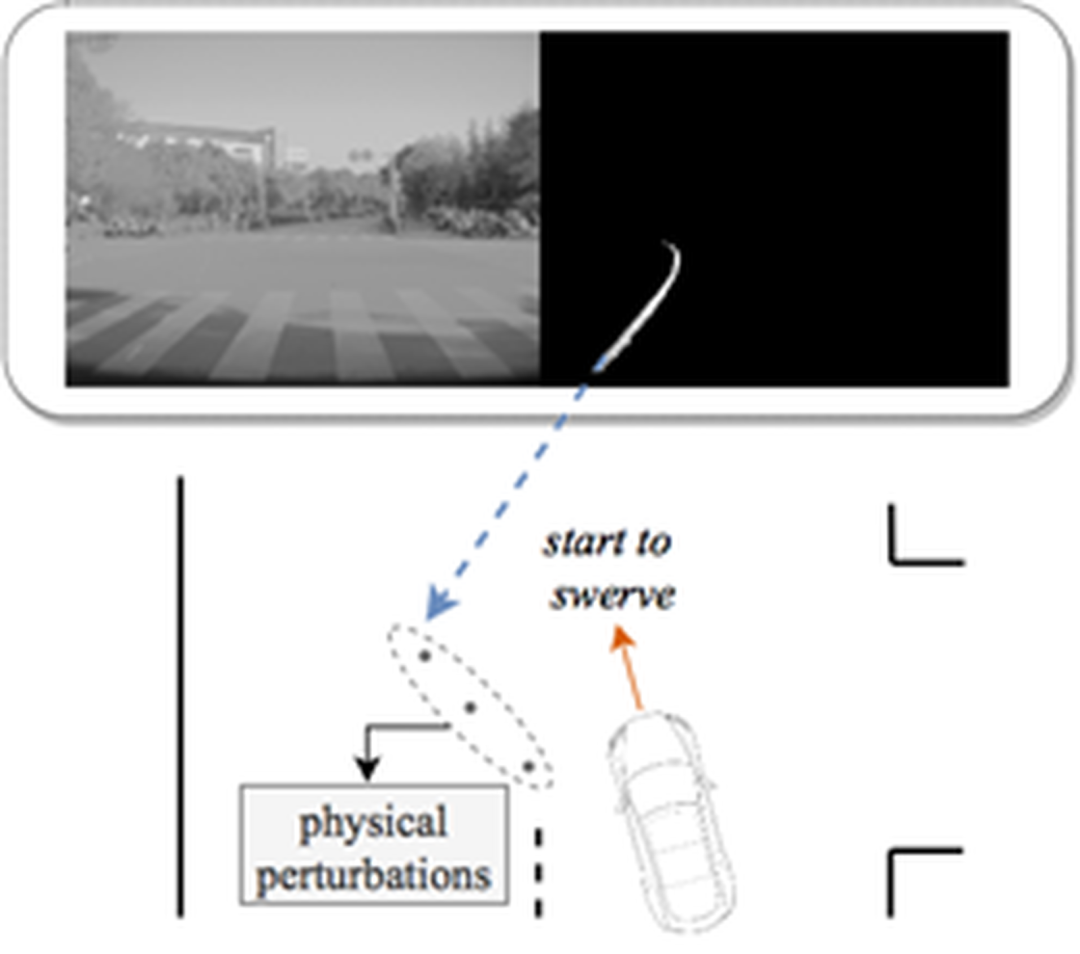

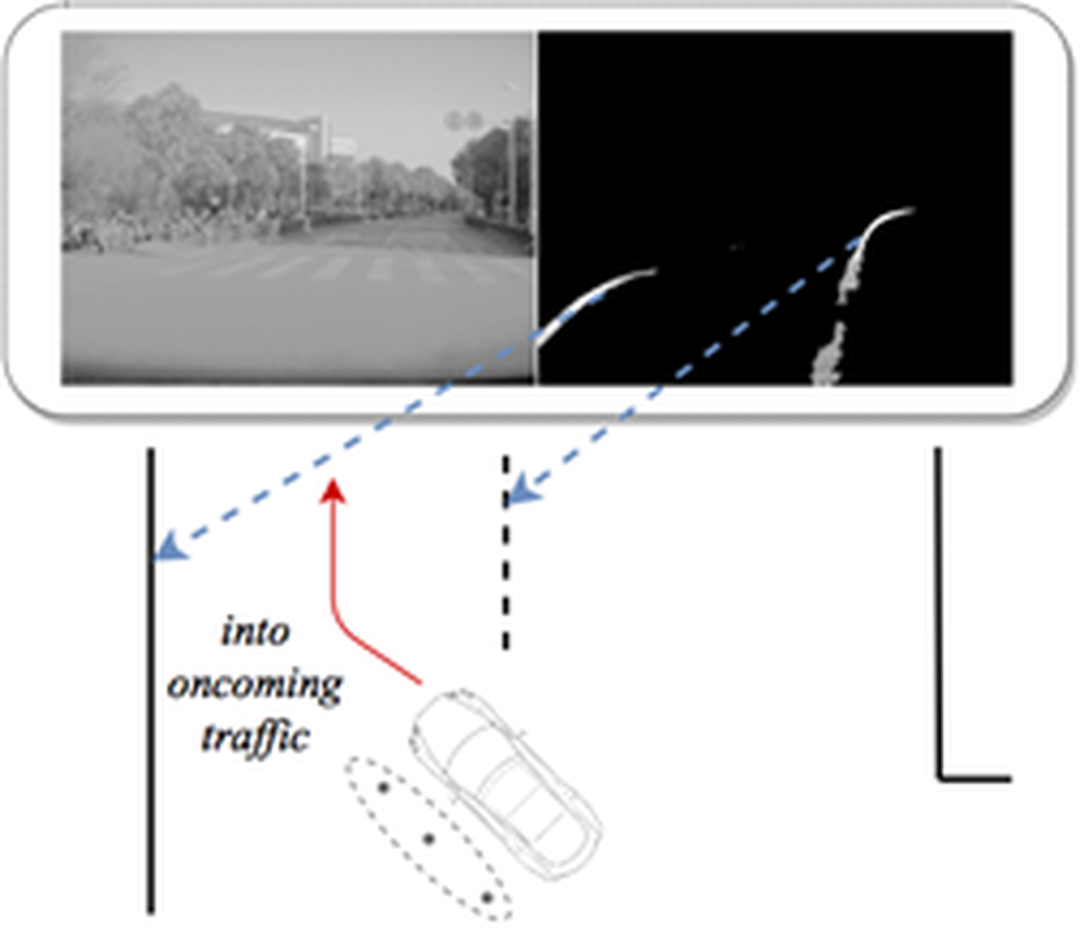

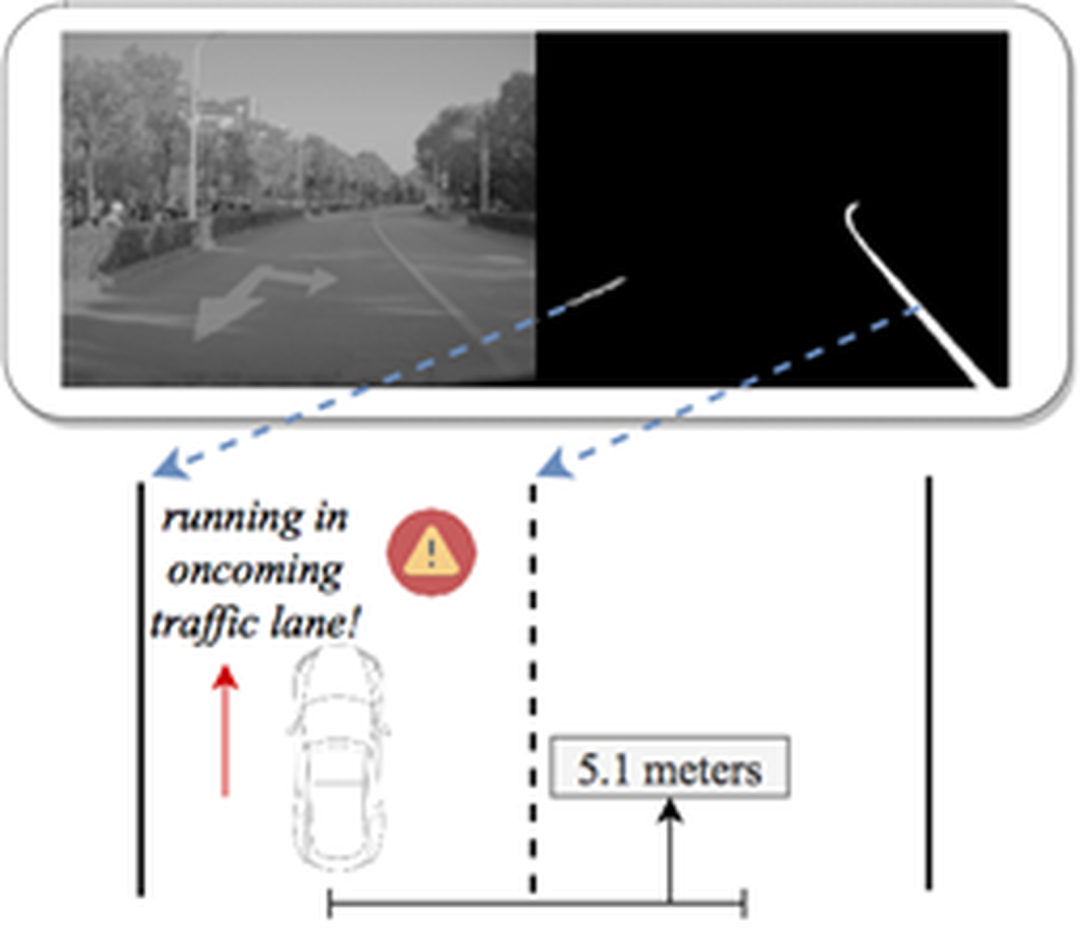

为完善该攻击方法,以及进一步测试现有车道线检测系统的安全性,我们基于黑盒测试和优化算法设计了一种自动化的攻击方法来找到人眼难以察觉,但却可以欺骗车道线检测系统的扰动。在实验阶段,这些扰动被布置在物理世界中,而处于自动驾驶状态的车辆成功被引入了逆向车道(如图.1所示)。

图.1: 攻击场景:在十字路口引导自动驾驶车辆驶入逆向车道

该研究由科恩实验室和香港理工大学罗夏朴教授团队及宾州州立大学王挺教授联合完成,且相关论文: 《Too Good to Be Safe: Tricking Lane Detection in Autonomous Driving with Crafted Perturbations》发表于安全领域四大顶会中的USENIX Security 2021。

关于USENIX Security会议

USENIX Security会议是安全领域最具影响力的顶级学术会议之一,多年来的论文接受率均低于20%。其常与Oakland S&P, CCS, NDSS并称为安全领域的四大顶会。USENIX Security 2021会议将于2021年8月11日-13日在线上举行。

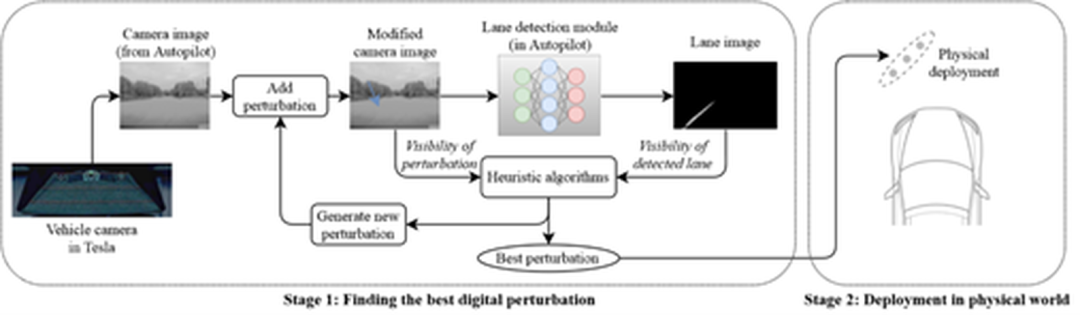

实验方法

本次研究中Tesla 具体车型为Model S 75,其Autopilot硬件版本为2.5,软件版本为2018.6.1。基于对抗样本的思想,我们期望找到 1.人眼不容易发现,2.且可以欺骗系统的扰动。找到该种扰动的Two-stage攻击的框架如图.2所示:我们先基于黑盒测试和优化算法在数字图像层面找到最佳扰动 (Stage.1),然后再将该扰动布置到物理世界 (Stage.2)。

图.2: 以欺骗车道线检测系统为目的的Two-Stage Attack

Stage.1: 找到digital层面的最佳扰动

首先,基于从 Model S中提取的camera image(该图像后续将被用于车道线检测),我们以指定的参数对该图像加入形如车道线的扰动,然后将被篡改的图像送进车道线检测系统。同样,被篡改图像对应的lane image(车道线检测的结果)也将被从车内提取出来。基于1.加入扰动的可见度和2.被检测到的车道线强度,我们运用优化算法来找到1.最隐蔽,且2.有最好攻击效果的扰动。

Stage.2: 在物理世界布置扰动并检测攻击效果

在Stage.1中,加入扰动的参数是基于物理世界的坐标进行设计的(包括扰动的长宽,以及与车的相对坐标等)。因此,这些扰动能很方便地被布置在物理世界。在Stage.2,这些扰动被布置在车的前方。通过观察车道线检测的结果,以及自动驾驶系统是否对这些扰动进行相应,攻击的有效性得以证实。

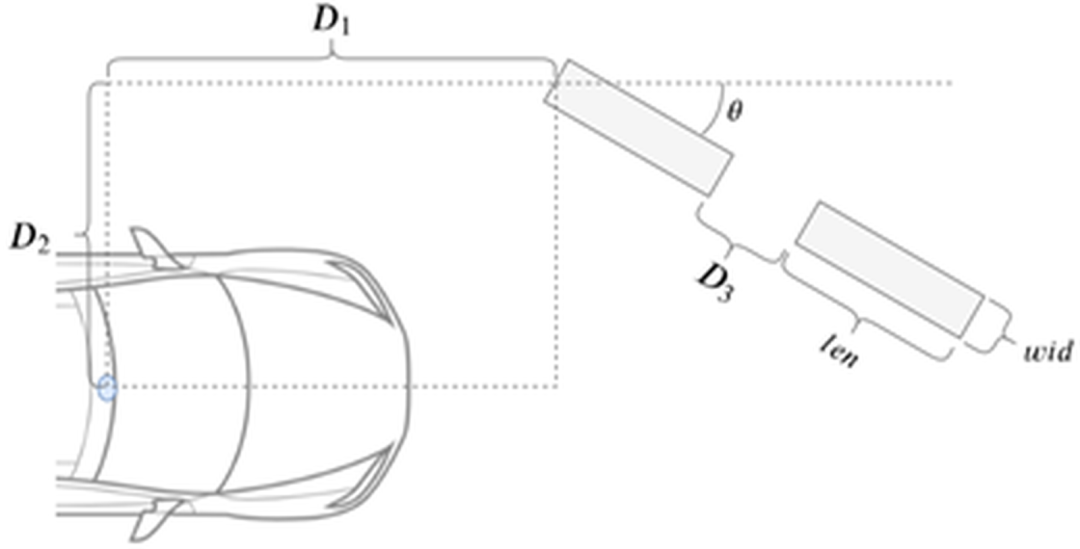

具体来说,图.3展示了如何对这些扰动进行定义:我们采用一个多维向量来表征形似车道线的扰动,该向量中包括扰动的形状,相对车载摄像头的坐标,角度,数量等参数。一组扰动将由一组物理参数唯一决定,然后基于这些物理参数,通过摄像头的针眼模型和去畸变算法,这些扰动被加入到数字图像中并应用于后续的优化算法。

图.3: 扰动的参数描述(基于物理世界坐标)

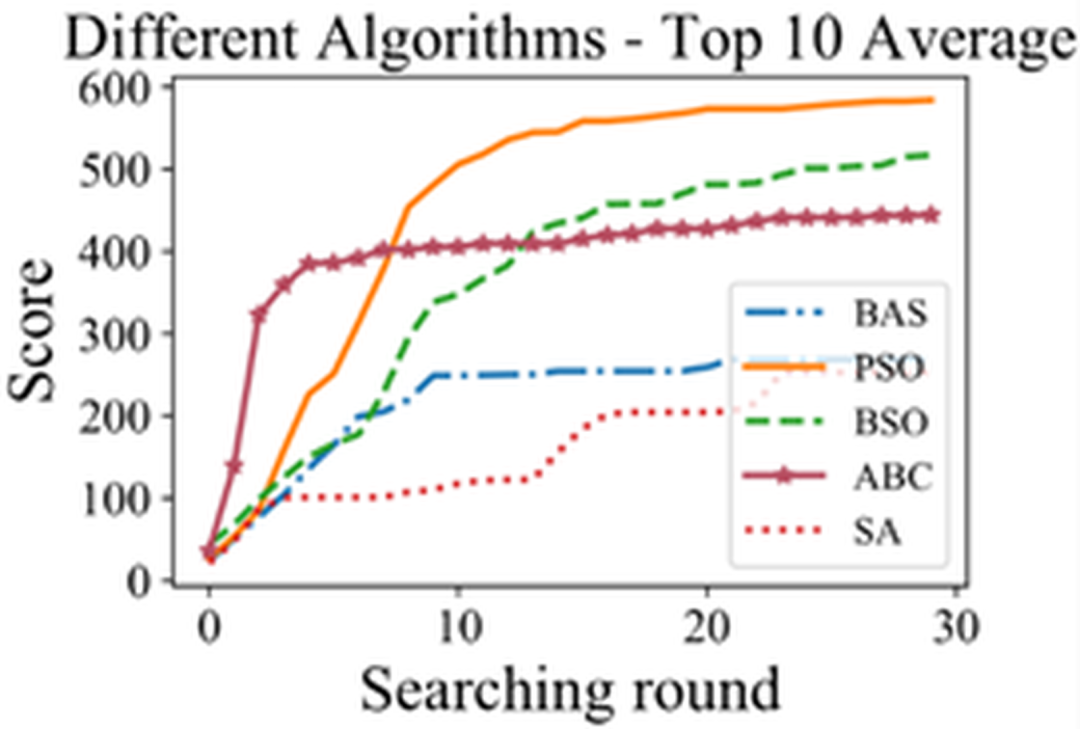

我们采用了一共5种启发式算法来寻找最优的扰动,这些算法的表现如图.4所示。其中PSO(粒子群算法)拥有最好的综合性能。

图.4: 各种启发式算法的对比:PSO拥有最好的综合性能

攻击效果

实验表明,在行驶过程中,检测模型的确将这些扰动视为真实的车道线,并且对其响应。具体来说,处于自动驾驶状态的车辆在十字路口被我们添加的扰动成功引入了逆向车道:

1.在十字路口场景下,车辆以自动驾驶模式在道路右侧行驶(此为正确的行驶方向)

2.在即将要通过十字路口时,车辆将地面上的扰动视为真实的车道线,并且随着这些扰动开始转弯

3.通过十字路口时,车辆跟随被检测到的假车道线驶入逆向车道

4.车辆保持在逆向车道上行驶

该过程中,对应的逐帧图像如下GIF所示:

补充说明

本次发布的研究成果在Autopilot的2018.6.1版本上得到验证,研究团队未对Autopilot其他更高版本进行测试Tesla是否通过升级其模型来防范该攻击。但无论何种情况,为保证安全,建议即使在Autopilot辅助驾驶开启的情况下,车主也应该全神贯注于驾驶,且随时准备接管车辆的控制。

- 下一篇:轻型商用车制动热衰退性能道路试验研究

- 上一篇:基于偏置度的车辆追尾碰撞损伤控制研究

编辑推荐

最新资讯

-

R171.01对DCAS的要求⑤

2025-04-20 10:58

-

自动驾驶卡车创企Kodiak 将通过SPAC方式上

2025-04-19 20:36

-

编队行驶卡车仍在奔跑

2025-04-19 20:29

-

全国汽车标准化技术委员会汽车节能分技术委

2025-04-18 17:34

-

我国联合牵头由DC/DC变换器供电的低压电气

2025-04-18 17:33

广告

广告