众所周知,从分布式架构向集中式域控制器架构演进已经成为下一代自动驾驶系统不可逆转的趋势。对于下一代集中式域控架构下到的自动驾驶系统来说,域控制器因为有强大的硬件计算能力与丰富的软件接口支持,使得更多核心功能模块集中于域控制器内,系统功能集成度大大提高,这样对于功能的感知与执行的硬件要求降低。但是,域控制器的出现并不代表底层硬件 ECU 的大规模消失,很多 ECU 的功能会被弱化(软件和处理功能降级,执行层面功能保留),大部分传感器也可以直接传输数据给域控制器,或把数据初步处理后给域控制器,很多复杂计算都可以在域控制器里完成,甚至大部分控制功能也在域控制器里完成,原有 ECU 很多只需执行域控制器的命令,也就是说, 外围零件只关注本身基本功能,而中央域控制器关注系统级功能实现。 此外, 数据交互的接口标准化,会让这些零部件变成标准零件,从而降低这部分零部件开发/制造成本 。

作为自动驾驶之眼的摄像头尤其是这样,在L2阶段,整个智能驾驶的视觉感知单元一般都是放在被称之为摄像头总成的零部件中,这种总成零部件都是包含了摄像头模组本身,也包含了处理摄像头感知的环境信息的软件算法模块,比如ISP、encode、神经网络、深度学习单元等AI算法。然而,在下一代高阶自动驾驶系统中,这些原本由摄像头模组处理的感知能力将会被放到 域控制器端的AI芯片 进行集中式处理。那么,问题来了,对于这类型的自动驾驶系统架构模式,摄像头模组本身的需求将会发生哪些变化,又会带来哪些新的需求呢?

本文主要介绍车载摄像头基础知识,包含摄像头模组成像的基本原理、摄像头类型、摄像头选型方法、摄像头安装方式、摄像头安装过程中的常见问题等。对于自动驾驶相关零部件设计工作来说提供较好的借鉴。

数据和特征决定了机器学习的上限,而模型和算法只是逼近这个上限而已。

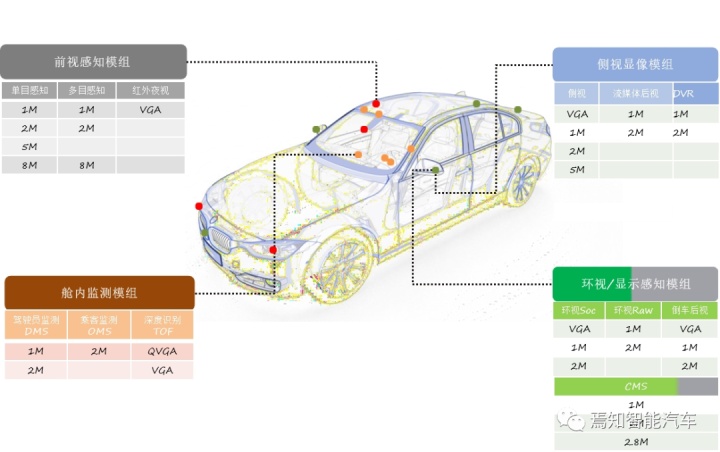

整个车载摄像头模组分为几个不同的较大模块,按照布置的不同区域以及实现的不同的功能,整个摄像头模组分为前视感知模组、舱内监测模组、显像感知模组、外摄显像模组。

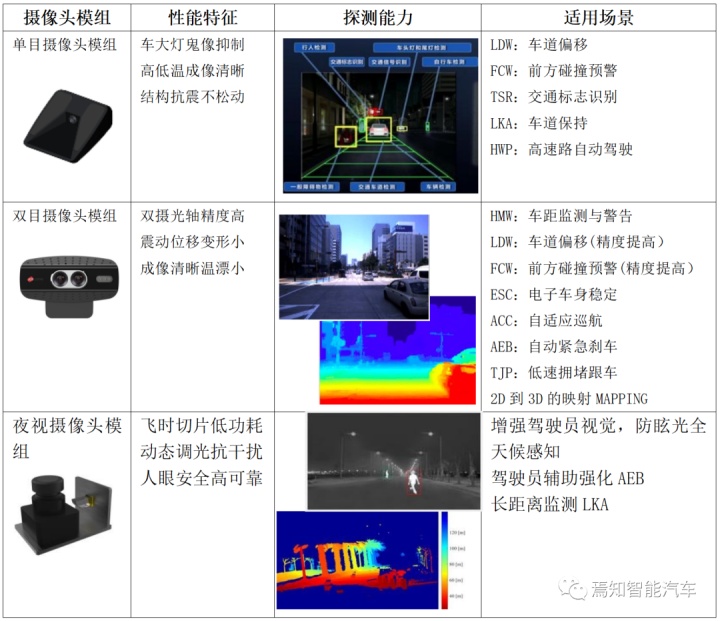

对于高阶自动驾驶系统而言,以前视感知系统为例,从摄像头的类型分类总体可以分为:包含针对更加强悍的远距离小目标类型、结构探测的单目感知模组;对距离、速度等深度信息更为敏感的双目感知模组;以及对夜间行驶下目标的红外信息更加有效的夜视摄像头模组。如下图分别表示了几种摄像头的不同探测功能性能。

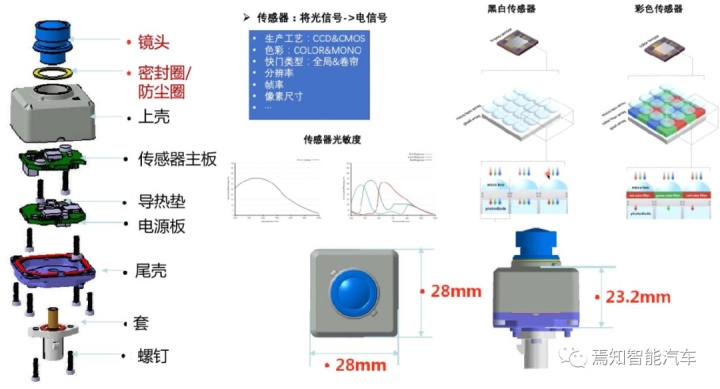

从摄像头的结构来看,主要包含镜头、基座、红外滤光片、图像传感器、PCB和FPC,其中对成像质量影响最大的两个为图像传感器和镜头。图像传感器是将光信号转化为电信号的装置,是摄像头中最为重要的部件,分为CCD和CMOS两大类。CMOS图像传感器芯片采用了CMOS工艺,可将图像采集单元和信号处理单元集成到同一块芯片上。其工作原理是将光敏元阵列、图像信号放大器、信号读取电路、模数转换电路、图像信号处理器及控制器集成在一块芯片上。虽然成像质量不如CCD,但是CMOS因为耗电省(仅为CCD芯片的1/10左右)、体积小、重量轻、集成度高、价格低迅速得到各大厂商的青睐。目前主流的车载摄像头都采用CMOS图像传感器芯片。

从摄像头应用于不同的探测功能来说,可以区分为前视、侧视、后视摄像头、舱内摄像头等。

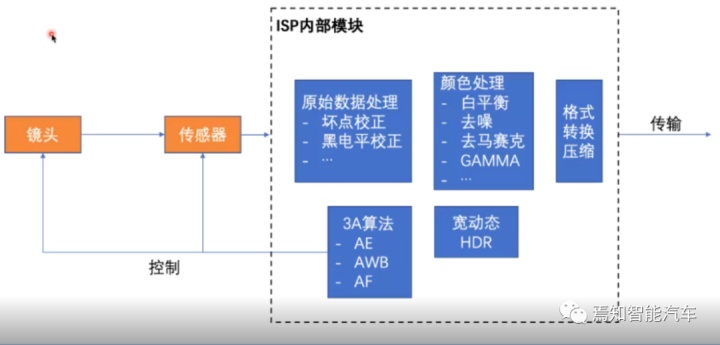

实际上,在进入真正的图像处理算法前,进入图像摄像头模组的图像就已经在摄像头模组的半导体合成芯片处理端被进行了初步的数字信号处理(ISP)处理。这个过程包含原始数据处理过程(如坏点矫正、黑电平矫正)、颜色处理过程(白平衡、去躁、去马赛克、GAMMA等)。其中常见的3A数字成像技术利用了AF自动对焦算法、AE自动曝光算法及AWB自动白平衡算法,实现了图像对比度最大、改善主体拍摄物过曝光或曝光不足情况、使画面在不同光线照射下的色差得到补偿,从而呈现较高画质的图像信息,很好的保障图像精准的色彩还原度,呈现完美的日夜监控效果。另一种采用的宽动态范围HDR技术则是在非常强烈的对比下让摄像机看到影像的特色而运用的一种技术。

需要说明的是,如果摄像头模租算法足够精进,在摄像头输出给后端AI芯片进行深度学习前也就不需要在进行基础的ISP图像处理了,而AI芯片可以集中更多的算力和资源用于后端的深度学习、神经网络等场合。这样不仅能够大大降低AI芯片的处理功耗,还可以很大程度上实现更加优质的Raw data处理性能。当然,这里内置于摄像头模组内的ISP实际上对于其是否承载了较好的半导体处理芯片提出了较高的要求,这一块也是增加摄像头模组成本的一个原因。而实际处理过程中,摄像头模组和AI芯片往往承担着双重ISP的处理过程。

摄像头成像性能会大大影响后续AI芯片对环境的认知,特别是其深度学习算法、算力都是强项关与摄像头模组输入的原始数据。原始数据中的图像大小、分辨率、视野范围、像素大小、动态范围、帧率等要素则是影响的主要因素。

整体上,对于摄像头模组而言,主要关心的指标主要有以下几个:

以主机厂主要应用的CMOS摄像头成像元件为例,这种图像传感器是将光敏元阵列、图像信号放大器、信号读取电路、模数转换电路、图像信号处理器及控制器集成在一块芯片上。在CMOS芯片中,每个像素都有各自的信号放大器,各自进行电荷-电压转换,为了读出整副图像信号,要求输出放大器的信号带宽较宽,每个像元放大器的带宽较低,大大降低了芯片功耗。

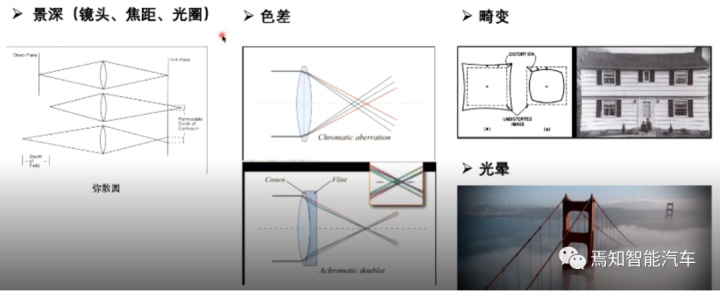

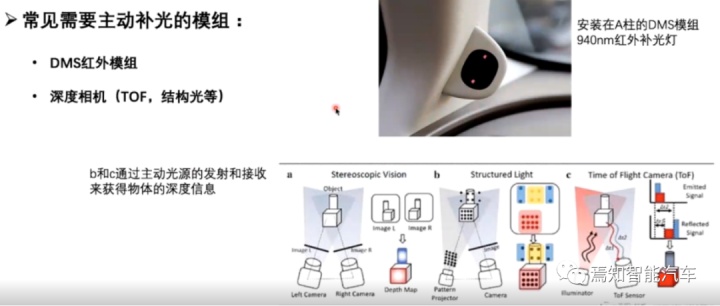

影响成像效果的因素包含主观和客观两种,主观因素是指环境动态目标实际的反射光线能力。如照明度低的隧道或阴雨雾天都是客观降低成像质量的要素,针对客观因素导致的图像成像低质量往往需要采用主动补光(一般包括DMS摄像头、TOF摄像头)或色彩补偿的方式进行质量提升;而主观因素则是针对摄像头模组本身的,比如信噪比、解析度、宽动态、灰阶、色彩还原度等等。

对于摄像头模组而言,考虑到其处理能力需要面向更多的原始场景要求,需要集成信号放大器你、信号读取电路、AD转换电路、图像信号处理器及控制器等在一块芯片上。将在前端模组中实现芯片级照相机的功能。

摄像头模组需要逐个对光敏元件进行输出,且具备多个电荷-电压转换器和行列开关控制,读出速度基本大于500f/s以上。且对于高分辨率的摄像头模组而言,往往需要下采样后进行子窗口的输出,在仅输出子窗口图像时可以获得更高的速度。比如当前应用比较广泛的是利用地平线的J3芯片处理800万像素的图像就需要进行下采样后,直接输入加串器后才能满足J3的处理能力。

当前各家摄像头供应商更倾向于CMOS工艺下的摄像头模组,这类模组往往由于缺少PN结或二氧化硅隔离层,无法实现对噪声的有效隔离。各元件、电路之间距离很近,干扰比较严重。在这一块上,对于前段模组的消噪技术提出了比较高的要求。

原来的摄像头总成往往由于其布置位置是在前挡风玻璃,且其本身集成的AI芯片会大量调用深度学习算法进行大量的运算。因此,其耗电量也是十分巨大的。当下一代自动驾驶系统架构中,摄像头仅仅担任原始图像识别的功能,作为模组而言,可以减少计算单元对其耗电单元的消费。

对于以集中式域控制器架构设计的自动驾驶控制系统来说,摄像头输入的接口数据将不再是之前可以直接用于算法控制的CAN数据,而是原始的图像数据,常用的摄像头rawdata输入接口形式包括FPD l

其中FPD-l

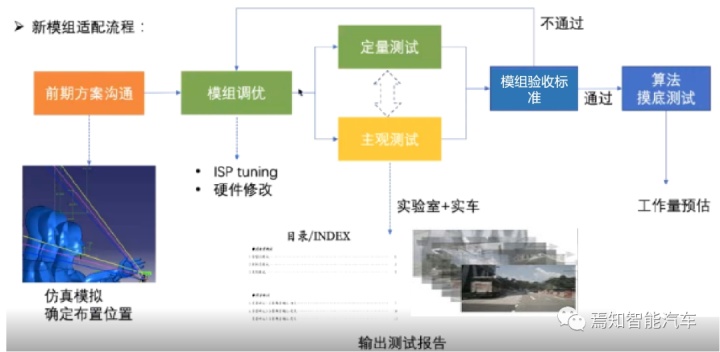

对于整个自动驾驶系统而言每上一套新的模组就需要进行环境适配。适配流程如下:

以车型外CAS为载体利用CATIA、CAD等软件建立仿真模拟确定布置位置,释放相应的位置信息给摄像头模组供应商,摄像头模组供应商进行模组调优、ISP tuning、硬件修改,随后进行主观测试、客观测试。通过行业或企业内制定的模组标准确定该模组调优结果是否通过,通过调优的模组可以进一步进行算法摸底测试了。摄像头模组选择是否合理,以最终的模组合格性测试报告为准。

综合以上情况可知,影响摄像头模组识别性能的要素包括模组性能、布置位置、探测环境光线等,当然采用图像调优可以部分解决以上问题所带来的影响,后期也可以通过标准化引导生成主观及客观测试标准,优化算法需求,集成到产品要求中。

广告

广告