KITTI数据集由德国卡尔斯鲁厄理工学院和丰田美国技术研究院联合创办,是目前最大的自动驾驶场景下的计算机视觉算法评测数据集。该数据集用于评测立体图像(stereo),光流(optical flow),视觉测距(visual odometry),3D物体检测(object detection)和3D跟踪(tracking)等计算机视觉技术在车载环境下的性能。

KITTI包含市区、乡村和高速公路等场景采集的真实图像数据,每张图像中最多达15辆车和30个行人,还有各种程度的遮挡与截断。整个数据集由389对立体图像和光流图,39.2 km视觉测距序列以及超过200k 3D标注物体的图像组成 ,以10Hz的频率采样及同步。总体上看,原始数据集被分类为‘Road’, ‘City’, ‘Residential’, ‘Campus’ 和‘Person’。对于3D物体检测,label细分为car, van, truck, pedestrian, pedestrian(sitting), cyclist, tram以及misc组成。

获取地址:http://www.cvlibs.net/datasets/kitti/

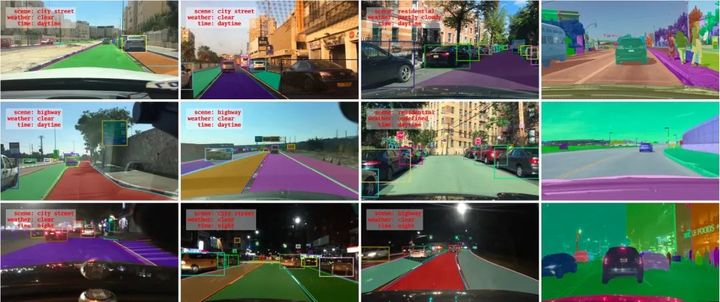

2018年5月伯克利大学AI实验室(BAIR)发布了公开驾驶数据集BDD100K,同时设计了一个图片标注系统。BDD100K 数据集包含10万段高清视频,每个视频约40秒\720p\30 fps 。每个视频的第10秒对关键帧进行采样,得到10万张图片(图片尺寸:1280*720 ),并进行标注。10万张图片中,包含了不同天气、场景、时间的图片,而且高清、模糊的图片都有,具有规模大,多样化的特点。

获取地址:https://www.bdd100k.com/

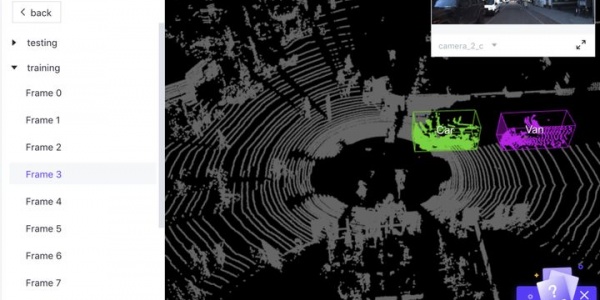

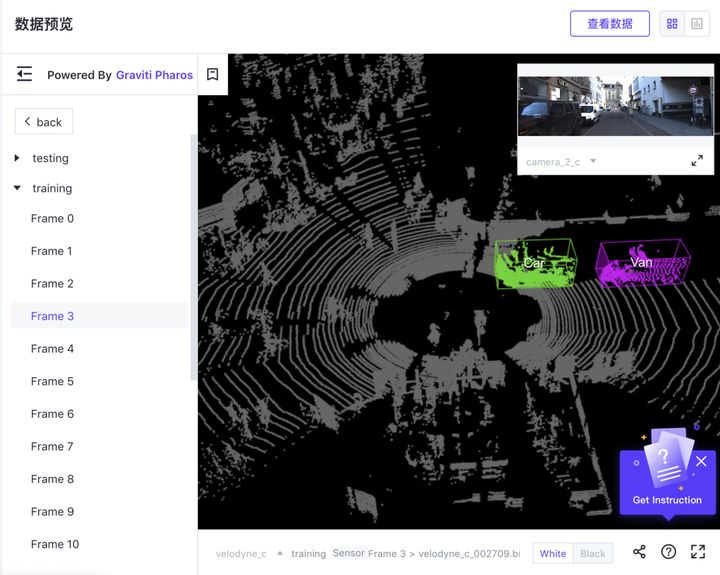

nuScenes数据集是由Motional(以前为nuTonomy)的团队开发的用于自动驾驶的公共大型数据集。Motional致力于实现安全,可靠和可达的无人驾驶环境。通过向公众发布部分数据,Motional旨在推进计算机视觉和自动驾驶的研究。

nuScenes数据集在波士顿和新加坡这两个城市收集了1000个驾驶场景,这两个城市交通繁忙,驾驶状况极具挑战性。nuScenes手动选择20秒长的场景,以显示各种驾驶操作,交通状况和意外行为。

nuScenes收集了不同大洲的数据,能让我们进一步研究计算机视觉算法在不同位置,天气状况,车辆类型,植被,道路标记以及左右手交通之间的通用性。

nuScenes完整的数据集包括约40万个关键帧中的140万个摄像机图像,39万个LIDAR扫描数据,1.4 M个RADAR扫描数据和1.4万个对象边界框。其扩展包nuScenes-lidarseg的40,000个点云和1000个场景(用于训练和验证的850个场景以及用于测试的150个场景)中包含了14亿个标注点。

获取地址:https://d3u7q4379vrm7e.cloudfront.net/download

本田研究所于2019年3月发布其无人驾驶方向数据集,使用3D LiDAR扫描仪收集的大型全环绕3D多目标检测和跟踪数据集。其包含160个拥挤且高度互动的交通场景,在27,721帧中共有100万个标记实例。凭借独特的数据集大小,丰富的注释和复杂的场景,H3D聚集在一起,以激发对全环绕3D多目标检测和跟踪的研究。

获取地址:https://usa.honda-ri.com/datasets

Mapillary Vistas是世界上最大、最多样化的街道级图像公开数据集,包括25000张高分辨率的彩色图像,分成66个类,其中有37个类别是特定的附加于实例的标签。

Mapillary Vistas 数据集具体涵盖了25,000个高分辨率图像(分为18,000个用于训练,2,000个用于验证,5,000个用于测试; 平均分辨率为~9百万像素),带有大于200万个手动绘制多边形的像素标注;100个目标类别,其中60个特定于实例(即用于枚举目标);全球地理覆盖范围,覆盖北美和南美,欧洲,非洲,亚洲和大洋洲;天气条件(太阳,雨,雪,雾,阴霾)和拍照时间(黎明,白天,黄昏,甚至夜晚)的变化;大范围的相机传感器,不同的焦距,图像宽高比和不同类型的相机噪声;不同的拍照视点(来自道路,人行道和off-road)

获取地址:https://research.mapillary.com/publication/iccv17a/

6.Mapillary Traffic Sign数据集

世界最大也最具多样性的交通标志数据集Mapillary Traffic Sign Dataset,可用于自动驾驶中交通标志的自动检测与分类的研究。

该数据集包括10万幅高分辨率图像,其中5.2万幅图像所有交通标志全标注,4.8万幅图像部分标注;300个交通标志类别,32万+个包围框;覆盖全球6大洲多个地理位置;含有天气、季节、时刻、相机和视角等的多样性变化;

获取地址:https://www.mapillary.com/dataset/trafficsign

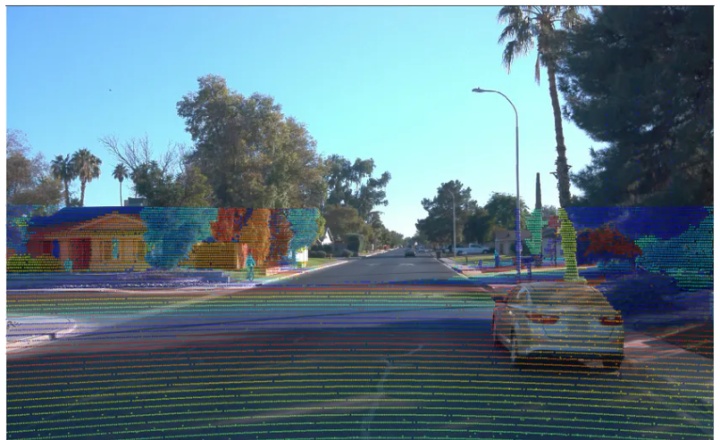

2019年8月,Wamyo曾公布其Waymo Open Dataset,此后,Wamyo又为该语料库增加了1060万个2D标签、800个语料片段。该语料库可让研究人员更容易从头开始构建安全的自动驾驶模型,而且无需承担自己收集数据的成本。

Waymo Open Dataset中包含了Waymo汽车在亚利桑那州凤凰城、华盛顿柯克兰、加州山景城和旧金山行驶了数百万英里所收集的数据,而且涵盖了在白天夜晚、黎明黄昏、晴天雨天在各种城市和郊区环境下驾驶时收集的数据。数据样本被分成1000个驾驶段,每个驾驶段通过安装在Waymo车上的传感器连续捕捉20秒驾驶数据,相当于使用10Hz摄像头捕捉20万帧图像,此类摄像头包括5个定制版激光雷达以及5个前置和侧视摄像头。

该语料库还包括经过标记的激光雷达帧以及车辆、行人、骑行者和指示牌图像。Waymo表示,摄像头和激光雷达帧已经由内部研发的3D感知模型进行了同步,该模型融合了多个来源的数据,无需人工校准。

获取地址:https://waymo.com/open/download

8.Ford Multi-AV Seasonal数据集

由福特一支车队在2017年至2018年间采集,包括混合的驾驶场景,包括底特律机场,高速公路,城市中心,大学校园和郊区。

该数据集包含了城市环境中经历的天气、照明、建筑和交通条件的季节变化,可以帮助设计自主车辆和多智能体系统的鲁棒算法。数据集中的每个日志都带有时间戳,包含来自所有传感器的原始数据、校准值、姿势轨迹、地面真实姿势和3D地图。所有数据都以Rosbag格式提供,可以使用开源机器人操作系统(ROS)进行可视化、修改和应用。

数据集还包括三维地面反射率图,三维点云地图,6自由度地面真实姿态,3自由度局部位姿和传感器转换和校准等。

获取地址:https://avdata.ford.com/

9.DeepRoute Open Dataset数据集

DeepRoute Open Dataset 由 L4 级自动驾驶解决方案提供商元戎启行发布,是用于训练 4 级自动驾驶算法的数据集。它包含深圳、武汉和杭州复杂城市道路上的真实测试场景。

数据是由设置在测试车辆顶部和侧面的三台激光雷达采集的激光雷达点云。发布的数据是从三个城市的10000帧道路测试数据中随机抽取的。使用带有图像的联合注释,障碍物由精确的 3D 边界框注释。

该数据注释了八种类型的障碍。在每种类型的障碍物中,都有包括物体类型、边界框中心位置、边界框尺寸和物体航向旋转角度等信息。

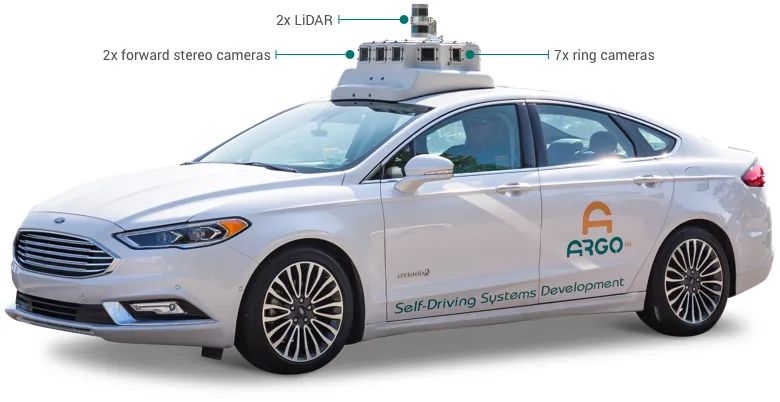

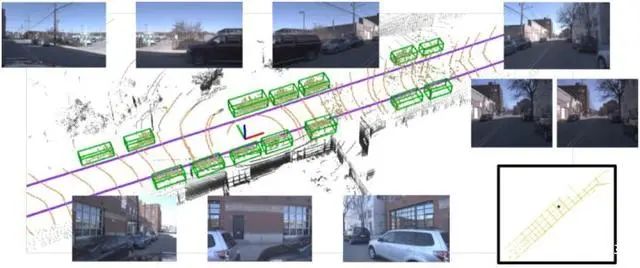

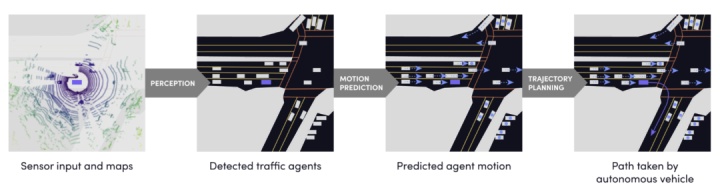

Argoverse数据集是由Argo AI、卡内基梅隆大学、佐治亚理工学院发布的用于支持自动驾驶汽车3D Tracking和Motion Forecasting研究的数据集。数据集包括两个部分:Argoverse 3D Tracking与Argoverse Motion Forecasting。

Argoverse数据集包含LiDAR数据、 RGB视频数据、前向双目数据、6 DOF的定位数据以及高精地图的数据,所有的数据都跟高精地图数据进行过配准。

Argoverse是第一个包含高精地图的数据集,它包含了290KM的带有几何形状和语义信息的高精地图数据。

获取地址:https://www.argoverse.org/data.html#download-l

Lyft数据集是目前最大的交通agent数据集合。

该数据集包括自主车队遇到的汽车、自行车者、行人和其他交通agent的运动日志,非常适合训练运动预测模型。 具体包括:小时的交通代理运动。(1000+);来自 23 辆车的数据(16K);语义图注解(15K)。

https://level-5.global/data/

该数据集包含5,277个驾驶图像和超过60K的汽车实例,其中每辆汽车都配备了具有绝对模型尺寸和语义标记关键点的行业级3D CAD模型。该数据集比PASCAL3D +和KITTI(现有技术水平)大20倍以上。

http://apolloscape.auto/car_instance.html#

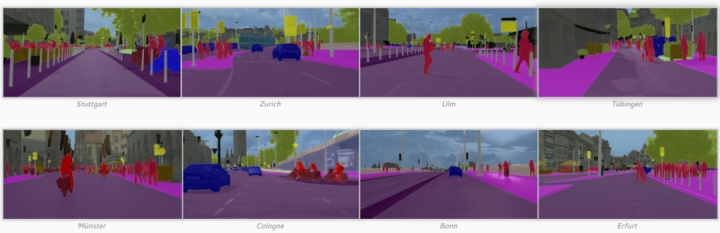

专注于对城市街景的语义理解。大型数据集,包含从50个不同城市的街景中记录的各种立体视频序列,高质量的像素级注释为5000帧,另外还有一组较大的20000个弱注释帧。因此,数据集比先前的类似尝试大一个数量级。可以使用带注释的类的详细信息和注释示例。

https://www.cityscapes-dataset.com/

加州理工学院行人数据集包括大约10小时的640

http://www.vision.caltech.edu/Image_Datasets/CaltechPedestrians/

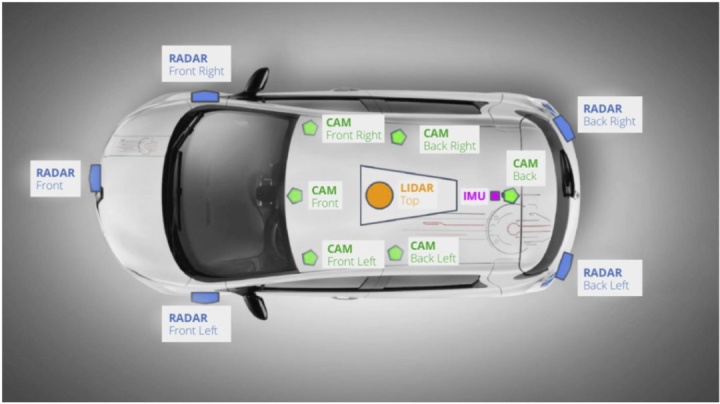

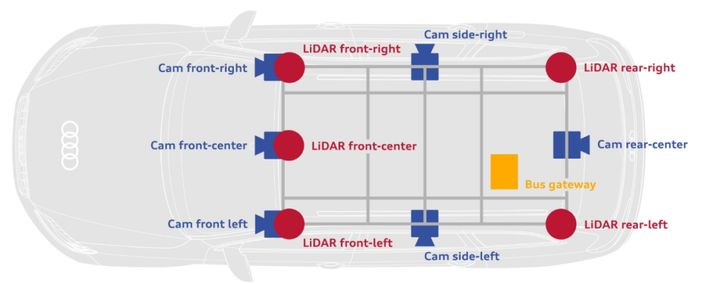

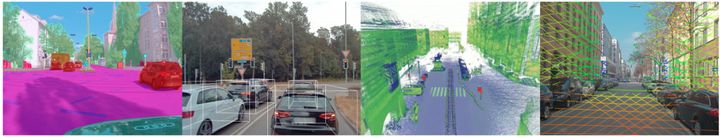

奥迪公司的大型自动驾驶数据集A2D2。这套数据集提供了摄像头、激光雷达和车辆总线数据,允许开发人员和研究人员探索多模态传感器融合方法。传感器套件包括六个摄像头和五个LiDAR单元,可提供完整的360度覆盖范围。

该数据主要来自德国街道,包含RGB图像,也包括对应的3D点云数据,记录的数据是时间同步的。目标3D包围框,语义分割,实例分割以及从汽车总线提取的数据。标注的非序列数据,41227帧,都含有语义分割标注和点云标签。其中含有前置摄像头视野内目标3D包围框标注12497帧。另外,该库还包括 392,556 连续帧的无标注的传感器数据。

https://www.a2d2.audi/a2d2/en.html

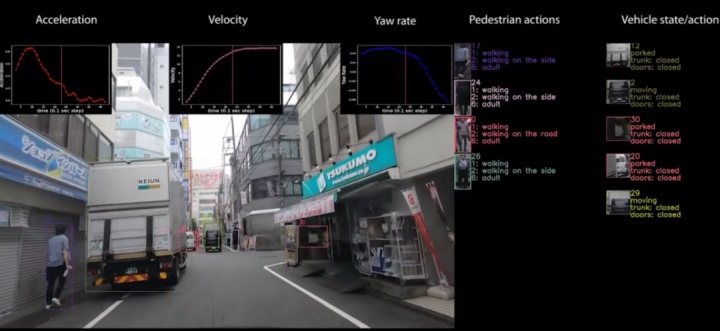

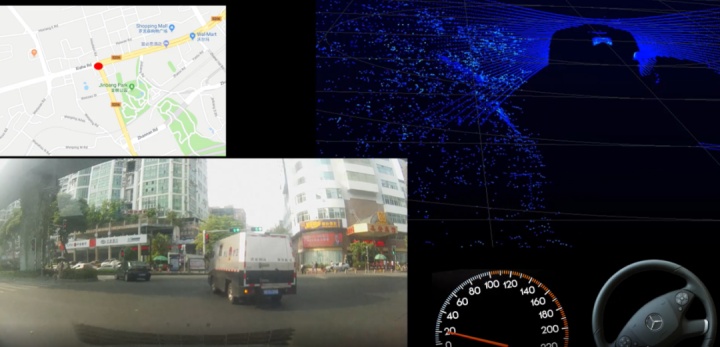

厦门大学与上海交大联合发布大规模驾驶行为数据集DBNet,专为研究驾驶行为的策略学习而设置的。DBNet 数据集记录了视频、激光雷达点云,以及对应的资深驾驶员(驾龄超过 10 年)的真实驾驶行为。

DBNet 的数据量大小 1.61T, 供下载的是压缩后约 500G 的文件。这种数据规模约为 KITTI 的 10 倍,能为学习资深驾驶员的驾驶模型提供训练数据,用于评测模型预测的驾驶行为和资深驾驶员真实驾驶行为的差距。

http://www.dbehavior.net/

西安交通大学和长安大学联合构建并公开了DADA数据集,目的在于预测正常行驶状况,危险状况和事故状况下驾驶员的注意力。为复杂交通场景中的类人理解提供一个大规模数据验证平台。

DADA数据集包含2000个视频序列,包含658,746帧,每一视频帧均提供了不少于5人观测的注意力数据。据调研,DADA是目前最大规模的驾驶注意预测数据集。经过参与者种类之间的关系,标注了54种突发事故场景类型。同时对于事故区间、事故目标进行了细致的标注。包含白天、夜间时段;各种天气条件(晴天、雨天、雪天);高速、城区、乡村、隧道等各种场景类型。

驾驶注意预测可以通过计算机模拟人类驾驶员驾驶过程中的视觉注意机制,可以帮助计算机快速定位到可能造成交通事故的目标物体,避免由于注意缺失造成的突发事件。同时驾驶注意又包含与周围环境的交互,可以用于重要交通参与者的定位(im

https://github.com/JWFangit/LOTVS-DADA

广告

广告