自动驾驶车辆测试的31个挑战:与行业及学术专家的访谈

引 言

汽车行业普遍认为,自动驾驶系统和自动驾驶汽车的出现,对质量保证的方式,尤其是测试的执行方式提出了巨大挑战。针对这个话题,编者挑选出最近读到的一篇文章与你分享,并加入了编者的评述。你遇到过、思考过其中哪些挑战?认同哪些挑战?还有没有别的挑战,需要我们共同关注的么?

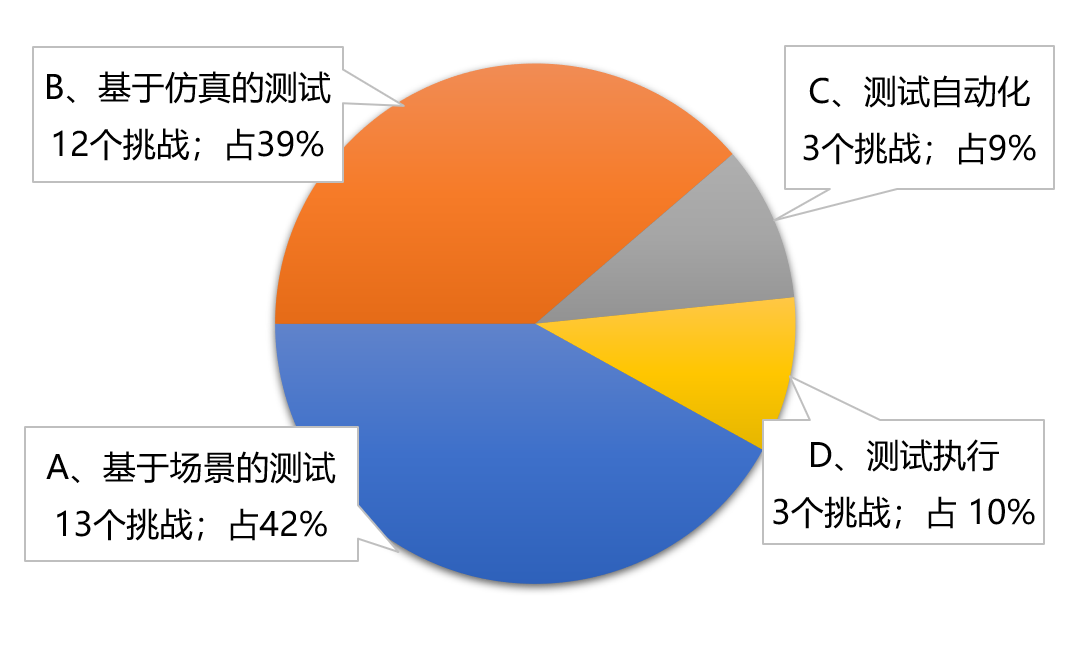

不同于大多学术论文的形式,本文采用与来自行业和学术专家进行访谈的方式,系统地讨论了在测试方法和工具方面的挑战,并指出了有待发展的方向。文章将自动驾驶汽车测试分为4个领域,共讨论了31个挑战;这4个领域分别是:基于场景的测试、基于仿真的测试、测试自动化以及测试执行。

题 目 : Thirty-One Challenges in Testing Automated Vehicles: Interviews with Experts from Industry and Research

作 者 : Felix Beringhoff, Joel Greenyer, Christian Roesener and Matthias Tichy

机 构 : Volkswagen AG, FHDW Hannover, Ulm University

编 者 : 陈君毅 邢星宇 刘镇源

自动驾驶汽车在其生命周期中面临的可能的交通情况数量庞大,然而又要全面、透明地确保其质量和安全性,同时尽量减少设计和执行测试的工作量,这对自动驾驶系统「ADS」的测试方法和工具提出了巨大挑战。测试自动驾驶系统这一复杂系统,将极大地考验汽车行业的开发和测试各个环节。

本文的主要研究对象及目标是:针对于搭载SAE 4级的自动驾驶汽车,在其ADS的测试实施和执行方面主要存在哪些挑战?

后续内容将分为以下四个部分:

PART 1 访谈研究方法介绍

PART 2 研究结果:31个挑战

PART 3 与其他相关研究结果的比较

PART 4 编者展望

本文首发于2022年9月

— 1 —

访谈研究方法介绍

访谈方式

通过网络会议工具进行半结构化的访谈,每次持续时间为35-65分钟,访谈内容由本文的第一作者转录和分析。

访谈专家基本情况

共采访了13位专家,其中10位来自行业,3位来自研究机构。对专家的选择,主要是依据他们在该领域的经验和先前的出版物。这些专家在驾驶功能测试方面的经验中位数为5年,在自动驾驶领域的经验中位数为7年。他们的职位主要为测试经理、测试设计人员、测试实施人员、测试工具开发人员、研究人员或方法专家等,其中一些专家担任过上述中的多个职位。原访谈是由德语进行的,由原作者译为英文进行发表。

访谈研究的有效性

依据Runeson和Höst[7]分类方法,作者阐述了采用访谈方式对研究有效性的考虑与设计,包括以下四方面:

结构有效性「Construct Validity」:在每次访谈开始时,主持人都会对访谈主题进行介绍,并对访谈术语进行定义。例如,阐明了所有问题都涉及SAE 4级自动驾驶系统,包括硬件和软件在内的所有模块。此外,当受访者要求解释问题或可能对问题有误解时,主持人会对问题进行阐释。

内部有效性「Internal Validity」:运用访谈指南,主持人尽可能保证每个访谈的结构相似。但访谈是以半结构化的方式进行,所以允许改变问题的顺序或提出额外的问题,以保证对话的顺利进行。由于问题顺序的改变,不能排除专家的回答受到这一改变的影响。如果时间允许,受访者可以在访谈结束时谈论其他关心的话题。由此,弱化了访谈指南对话题的限制,以减少在设计访谈指南时可能错过某些话题的影响。

外部有效性「External Validity」:为了获得对测试自动驾驶汽车挑战的不同看法,作者团队选择了来自不同公司和机构的从业者,且最多两人是来自同一部门。共13位专家参与了此次研究,但由于数量的原因,并不能保证对自动驾驶汽车测试所面临的挑战进行了全方位的总结。

可靠性「Reliability」:访谈的执行、转录和分析均由本文的第一作者完成。通过由一个人完成所有步骤,有助于在处理信息过程中保持一致性。但对访谈语句的标注和分类,存在一定程度的主观性,不免依赖于该作者的主观判断,这对研究的可靠性构成了挑战。

— 2 —

研究结果:31个挑战

以下介绍本文的主要研究结果,即31个技术挑战。这些挑战分为基于场景的测试、基于仿真的测试、测试自动化,以及测试执行共四个领域(图1)。

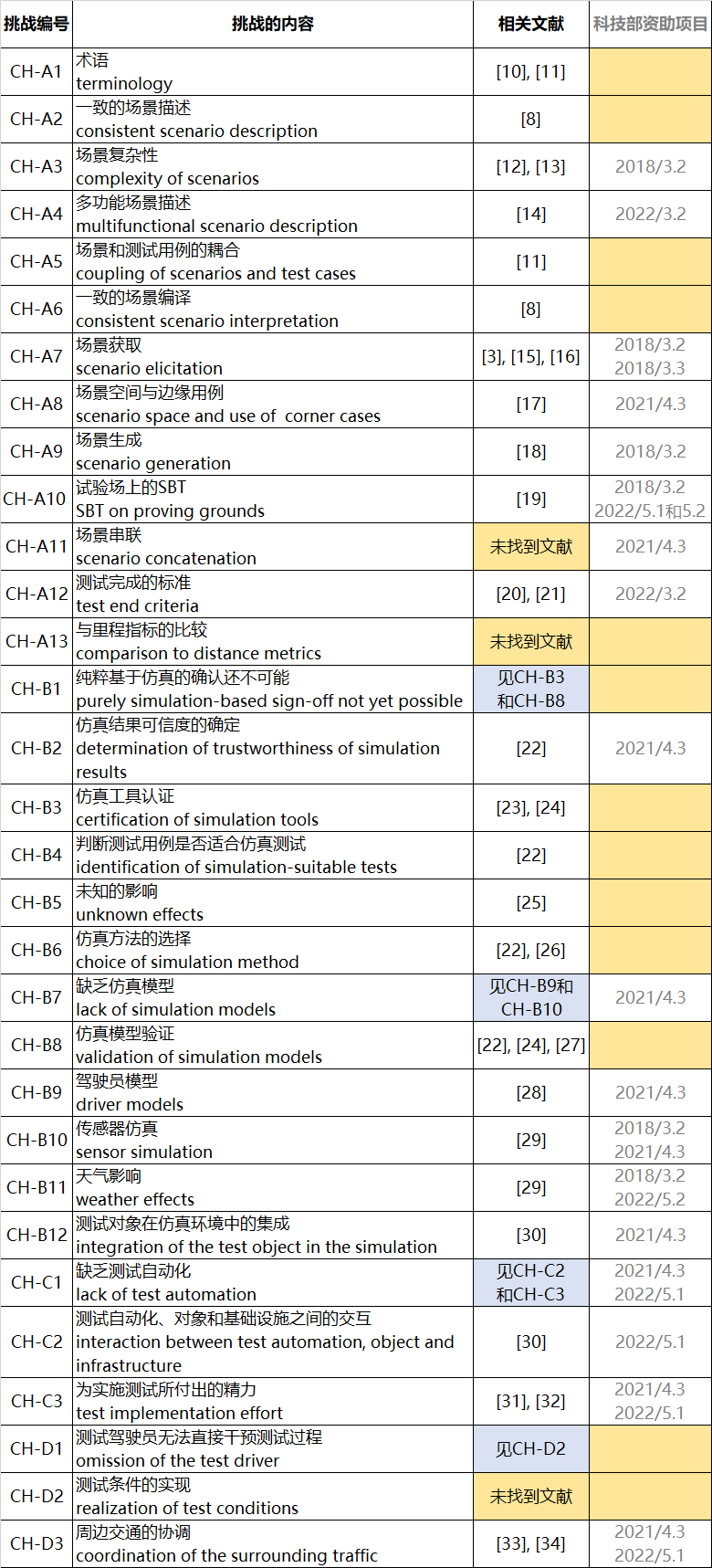

本文中对每一个挑战都进行了编码,例如「CH-A1」:「CH」为挑战一词challenge的缩写,「A」代表该挑战属于「基于场景的测试」这一领域,「1」为顺序编号。

本文中每位受访专家的原话用斜体及下划线的形式进行表示,并且对每位受访专家也进行了编码,例如「ID13」:表示第13位受访专家。

A、基于场景的测试 Scenario-based Testing

在访谈中,提到的大多数挑战都与基于场景的测试「SBT」相关。

CH-A1术语「terminology」:由于SBT框架目前还没有在汽车测试过程中确立,所以目前用于描述SBT过程的词汇被使用时并不统一。一些受访的专家提出,SBT的术语是否符合惯例是需要核查的。一位专家说:场景(scenario)这个词很常见,每个人都用它来指代不同的东西(ID13)。一些从业者使用场景这个词来描述仿真场景、测试用例,另一些人使用它来描述控制指令序列,这成为了准确交流的阻碍。

CH-A2一致的场景描述「consistent scenario description」:场景描述的标准格式有助于避免误解,往往人们讨论相同的事情,但描述不同;反之亦然(ID09)。一位专家提到的一个例子是关于场景开始点和结束点的统一定义。然而,创建一个一致的场景描述格式,以应对各种可能的驾驶场景的复杂性是具有挑战性的。

CH-A3场景复杂性「complexity of scenarios」: 谈到场景的复杂性,一位受访者将自动驾驶系统功能的测试场景与驾驶员辅助功能的测试场景进行了比较。驾驶员辅助功能只能在动态驾驶任务的一个子集中辅助人类驾驶员。受访者认为,(自动驾驶系统测试)场景的复杂性通常较高(ID02),以适合测试系统中的每个层级,例如,动作规划。因此,对场景的描述和执行会有更高的要求;即便对于专家来说,也是如此。

CH-A4多功能场景描述「multifunctional scenario description」:场景不仅在自动驾驶汽车测试中使用,而且在开发过程的各个层面都需要场景(ID13)。它们可能用于规范目的,也可能用于测试目的。它们对场景描述有不同的需求。据一位接受采访的专家说,就目前已知的手动流程来创建场景的各个层级而言,要沿着开发和测试过程的所有阶段构建(场景的)可追溯性几乎是不可行的。

CH-A5场景和测试用例的耦合「coupling of scenarios and test cases」:为了实现可追溯性,需要将场景和测试用例的不同要素联系起来。为此,正如一位专家所言,需要为每个要素提供明确的标识符。然而,一位受访专家表示,挑战是在于找到测试用例和场景之间的联系,也就是说,要找出哪些场景真正代表了这个测试用例,并且与之相关(ID11)。另一位专家提到,测试用例和场景之间的关系是他们目前遇到的一个问题。对于传统的测试用例,例如硬件在环(HiL),是在信号层面,而自动驾驶背景下的场景是在交通层面。这使得很难确定这两个要素如何一起工作以及它们是否必须一起工作。

CH-A6一致的场景编译「consistent scenario interpretation」: 仿真工具的通用情景描述格式并不能保证仿真工具对该格式实现一致的编译。然而,正如一些受访的专家所提到的那样,需要在项目和仿真工具之间实现场景的可转移性,并保证完全相同的场景的可重复性。虽然有OpenSCENARIO[8]这样的标准格式,但是对场景格式的编译不同,这就可能会导致这样的问题出现(ID08)。

CH-A7场景获取「scenario elicitation」:在许多访谈中,一个很重大的话题就是关于场景获取的话题。本主题涉及到其中一位专家提出的问题:我要测试哪些场景?这是关键问题。我从哪里得到它们(ID05)? 根据受访者的说法,需要确定哪些是相关的情景,以及如何获取这些情景。这被认为是一个连续的过程,因为随着自动驾驶车辆的发布,相关的场景可能会改变。这些新的场景可能只有在自动驾驶车辆进入真实交通之后才会被确定,并需要在持续测试过程中找到它们。一位专家提到,通过大规模行驶发现这些新场景在未来有很大的潜力。然而,对于后台的数据处理,还需要做很多工作。其中一位受访者提到,对于基于场景的流程,包括场景选择在内,应该有独立的审核流程,这证明我们尽了一切可能来保证车辆的安全。在发布法规用例的场景集之前,可能还有很长的路要走。

CH-A8场景空间与边缘用例「scenario space and use of corner cases」:除了从观察交通中提取场景外,还存在通过结合几个场景维度来人为创造场景的可能性。由于场景的参数空间是无止境的,一些受访者提到,需要有智能扫描场景空间的工具,以确定以尽可能少的场景来覆盖场景空间。一位受访专家提到,将场景的各个方面结合起来创建边缘用例是一个挑战:在我看来,挑战是在于如何智能地创建这些组合并自动测试它们(ID06)。

CH-A9场景生成「scenario generation」:在创建场景概念模型后,需要将场景转换成场景描述语言,随后通过仿真工具等执行。由于测试需要大量的场景,而一个场景脚本要包括计算轨迹和确定所有参与者的行动,从而实现预期的交通状况;因此,一位专家认为所有必要场景均由手动创建是不可能的(ID10)。

CH-A10 试验场上的SBT「SBT on proving grounds」:一位受访专家提到当不仅需要考虑参与者之间的相对条件,而且还需要考虑绝对条件,比如变道需要发生在场地中的某个位置,这就尤其具有挑战性。该挑战也引发了后续的其他几项挑战(CH-D2测试条件的实现和CH-D3精确控制交通参与者)。此外,在现实世界中执行测试期间的安全问题也需要额外关注。

CH-A11场景串联「scenario concatenation」:正如一位专家所说,在试验场进行测试时,将多个场景串联成一个连续的链条,对于提高测试时间效率非常有益。然而,开发这样一种工具来确定每个参与者的串联轨迹是具有挑战性的。

CH-A12测试完成的标准「test end criteria」:在结束测试的问题上,一位专家对此表述如下:在某种程度上,我们必须说:我们测试得够多了。我们需要正式确定,什么时候已经测试充分了(ID05)。找到可靠的测试完成的标准被认为是一个尚未解决的重要挑战,并且一位受访专家将其视为目前的研究课题。

CH-A13与里程指标的比较「comparison to distance metrics」:由于SBT方法不是汽车行业测试的经典方法,因此可能需要与目前使用的安全声明进行比较。目前,车辆通常是通过在道路上行驶达到一定的里程数进行测试的。此外,统计平均的事故间隔里程数可以描述事故发生的可能性。其中一位受访专家认为,一项挑战在于,要找到测试场景和里程数之间的转换,以便与事故统计进行比较:我认为最大的挑战是找到场景和里程之间的转换方法(ID07)。

编者评述

在「A、基于场景1的测试」中,最基本的挑战是CH-A1术语一致性和CH-A2场景描述一致性;离开了这两个,其他挑战都无从谈起了;

最困难的挑战是基于场景的测试终止条件,包括CH-A12测试完成的标准和CH-A13与里程指标的比较;

最重要的挑战是对CH-A3场景复杂性的充分理解(即从对动态驾驶任务中的一个子集进行测试的场景,到对ODD内的完整行驶任务进行测试的场景),也是引发后续很多挑战的根本源头;

最现实的挑战是,提高场景的衔接性与生成及使用的效率;前者包括CH-A4多功能场景描述,以服务于整个V型开发流程的整体使用的衔接性和一致性;后者包括CH-A7场景获取、CH-A8边缘用例、CH-A9场景生成、CH-A11场景串联等,提高效率。

B、基于仿真的测试 Simulation-based Testing

基于仿真的测试及其技术也是访谈中的一个重要话题。一些专家提到,仅靠真实世界的测试无法满足日益增长的测试需求,必须将测试更多地转移到虚拟环境中。然而,这也带来了一些挑战:

CH-B1纯粹基于仿真的确认还不可能「purely simulation-based sign-off not yet possible」: 一个关键的问题是,环境模拟与现实相差甚远。一些专家提到,目前还不可能完全放弃真实世界的测试。其中一位受访专家认为最近该问题没有什么突破(ID09),所谓突破是指可以在仿真环境中进行整体的测试,特别是最后的确认与批准。CH-B1体现了目前真实世界和仿真环境之间仍存在差距。

CH-B2仿真结果可信度的确定「determination of trustworthiness of simulation results」:为了能够将测试更大程度地转移到虚拟环境中,仍然需要回答的一个问题是:我们什么时候可以信任一个仿真测试结果(ID07)?一些受访者提到,除了仿真的缺陷之外,还必须能够确定一个概率声明,即仿真能多好地代表被测车辆在真实世界的性能。据一位专家说,这对于确定仿真测试足够可以取代真实世界测试的时间点是必要的。CH-B2体现了确定仿真环境在代表真实环境方面程度的难题。

CH-B3仿真工具认证「certification of simulation tools」:上述两项挑战涉及的是仿真与现实比较的技术难点,而对于ADS开发者来说,困难可能更多的是找到工具供应商,证明他们的仿真工具能提供完全可信的结果。一位专家称,他不知道有谁能证明或敢于保证他们的仿真软件好到甚至不需要进行真实的车辆测试(ID07)。另一位专家认为,为了确保基于仿真的测试正确进行,有必要使用经过认证的仿真工具。CH-B1和CH-B2就是CH-B3所描述的没有认证工具的结果。

CH-B4判断测试用例是否适合仿真测试「identification of simulation-suitable tests」:由于上述的挑战,并非所有的测试都能在虚拟环境中进行。需要分析哪些测试可以在仿真环境中进行,哪些测试需要在真实世界中进行。你需要确定,哪些可以用仿真环境进行测试(ID03)。一位受访专家说,关键点是对于某些测试来说,要确定其在仿真中所需的细节。

CH-B5未知影响「unknown effects」:然而,现实世界中可能仍有一些影响,是在仿真中没有考虑到的。因此,一位专家提到,人们需要提出这样一个问题:是否有我还没有考虑到的影响(ID06)。这同样适用于仿真的保真度和场景的还原度。

CH-B6仿真方法的选择「choice of simulation method」:一位受访专家表示,在回答一项测试是否适合在仿真环境中进行的问题的同时,还需要决定我想如何进行模拟(ID08)?进行仿真有不同的方式:开环测试(如回放模拟),闭环测试,或两者的混合。

CH-B7缺乏仿真模型「lack of simulation models」:为了在仿真中进行闭环测试,需要新的仿真模型,目前仍没有现成的产品。据一位受访者表示,这些模型将是一个巨大的挑战(ID06)。

CH-B8仿真模型验证「validation of simulation models」:这些模型和整个仿真环境也需要验证。然而,仿真模型的验证是一项具有挑战性的任务。正如一位受访专家所说:实际上,我们需要经过完全验证的仿真环境。而这是非常难以实现的(ID07)。

访谈中强调了两种类型的模型:驾驶员模型和传感器仿真模型。

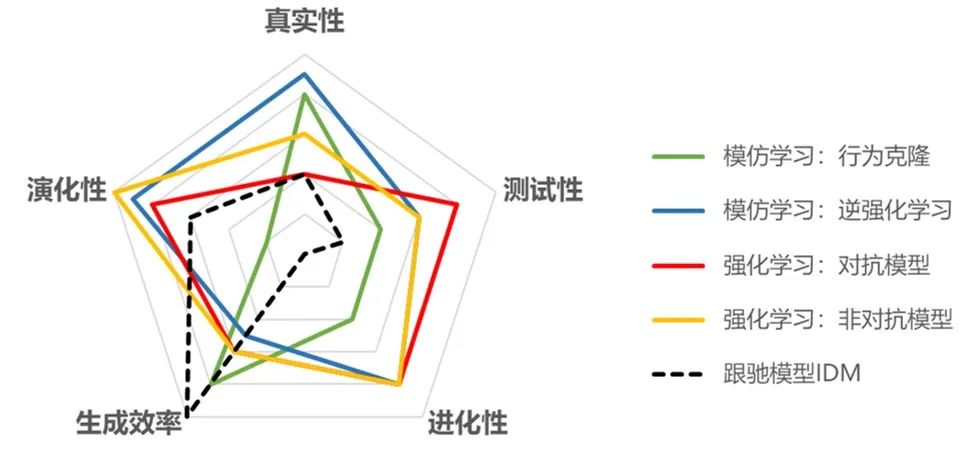

CH-B9驾驶员模型「driver models」:考虑周围交通的驾驶员模型是非常复杂的(ID05),并且缺乏描述标准。

CH-B10传感器仿真「sensor simulation」:用于传感器仿真的模型需要高质量的环境模型,包括雷达的表面反射率和相机传感器的高质量可视化。正如一位受访的专家所说:就传感器物理模型的质量而言,仍有很大的改进空间(ID05)。另一位专家将传感器仿真视为当前的重点研究课题。

CH-B11天气影响「weather effects」:与CH-B10相关的是天气影响的话题,如暴风雨、雨、雪、冰或雾等对感知模块产生影响。一位专家甚至提到这是hil测试的最大挑战(ID03),因为天气会影响多个传感器,如相机、雷达、激光雷达和超声波传感器等,所以需要在仿真系统中分别模拟对这些传感器的影响。

CH-B12测试对象在仿真环境中的集成「integration of the test object in the simulation environment」:另一个话题是被测车辆在仿真环境中的集成。据一位受访专家称,由于被测车辆和仿真的通信有延迟,因此这需要付出巨大的努力(ID03)。

编者评述

「B、基于仿真的测试」中的各个挑战之间相互关联非常紧密。

在底层,仿真系统中的环境建模(CH-B7)、传感器建模(CH-B10),尤其是天气影响下的建模与仿真(CH-B11)本身就是公认具有挑战性的技术难题,也是带来仿真环境可靠性挑战的核心原因;

在中层,模型的可验证性(CH-B8),仿真工具的可验证性(CH-B3),仿真结果的可信度(CH-B2),决定了采用仿真测试方法的可行性(CH-B4)和选择性(CH-B6);

在上层,也决定了完全基于仿真测试结果对ADS的确认还不可能(CH-B1)。

CH-B5未知的影响,与CH-A7场景获取有一定的关联,从大规模行驶数据中,获取和发现场景,有助于将更多的、对ADS性能表现有影响的场景因素纳入仿真测试,使得「场景还原度 」提升,进而对仿真工具提出新的要求,实现「仿真的保真度」的提升。

CH-B9驾驶员模型则是和上述内容相对独立的一个方面。传统的驾驶员模型基本是属于「应激性」的。其中一类是以驾驶员制动模型为代表,在以微观时刻为考量的行为动作上,能较好地代表驾驶员的「应变能力」。另一类是以跟驰模型为代表的,在以宏观交通流为考量的指标上,能较好地代表交通流动的「特征」。然而,面向ADS仿真测试所需考虑的周围交通的驾驶员模型是非常复杂的(ID05),有待进一步研究。

C、测试自动化 Test Automation

测试自动化通常用于重复性测试的执行,但不限于测试过程的这一步。测试自动化能够实现可重复的测试,同时降低测试成本和时间[9]。

CH-C1缺乏测试自动化「lack of test automation」:由于自动驾驶汽车的测试工作量预计会增加,因此测试自动化被认为是必须的。然而,目前测试过程中自动化的使用被认为不足以应对L4或L5的ADS测试需求。根据一位专家的说法,测试自动化需要进一步适应V型模式的所有层次,从软件单元测试到车辆测试,并且涉及测试用例的生成和测试执行。从受访者的经验来看,目前测试是手动完成的,或者在很小的程度上是自动化的。但是,就复杂性而言,这还没有达到L4或L5的ADS所需要的程度(ID03)。

CH-C2测试自动化、对象和基础设施之间的交互「interaction between test automation, object and infrastructure」:扩大测试自动化的范围,并从手动测试转向测试自动化是具有挑战性的。测试自动化工具需要集成在测试环境中,并且需要创建与测试对象和其他仿真工具(如环境仿真)的接口。集成测试对象、环境仿真和测试自动化软件在技术上是可行的,但这是一项具有挑战性的任务,直到所有东西都按照预期的方式一起工作(也参见CH-B12),并且只有所有东西都同步并匹配在一起时,才能避免在某些地方出现问题(ID04)。

CH-C3为实施测试所付出的精力「test implementation effort」:现今执行测试往往是昂贵的,需要特定工具的,并且每次改变系统的细节时都需要手动操作。测试用例是由人写的,因此测试用例不能被自动翻译(ID01),例如,测试自动化软件的控制输入。

编者评述

关于「C、测试自动化」,总体情况是:在自动驾驶汽车整个测试与验证流程中,

局部自动化程度高、整体自动化程度低;

仿真测试的自动化程度高、半实物或全实物测试的自动化程度低;

实施端的自动化程度高、输入/定义端的自动化程度低。

目前,跨工具跨系统的瓶颈之一,仍是场景刻画的一致性,包括描述(从使用者到软件)的一致性和编译(从软件到计算和实施)的一致性,所以与「A、基于场景的测试」中的诸多挑战是直接关联的。

D、测试执行 Test Execution

这个标题下的挑战与基于场景的测试、基于模拟的测试和真实世界的测试都有关,因此是单独分类的。在下文中,测试的执行被理解为测试运行期间的所有行为,可以是模拟的运行,也可以是在测试场地上的行驶。

CH-D1测试驾驶员无法直接干预测试过程「omission of the test driver」:当测试带有ADS的自动驾驶汽车时,车辆不再受人类测试驾驶员的控制。因此,被测车辆的动作取决于ADS的算法,并且不能轻易由测试驾驶员改变。一位受访专家举例到:作为一个测试驾驶员,我不能再靠近一点执行切入,因为控制车辆的不再是我,而是车辆在控制(ID13)。

CH-D2测试条件的实现「realization of test conditions」:考虑到装有ADS的自动驾驶汽车在没有人类测试驾驶员的情况下能自行控制车辆,因此实现测试条件的挑战就出现了,许多专家在访谈中也都提到了这一点。在测试执行过程中,必须以某些测试条件为前提,如交通情况处于某种程度的危险,场景中的某种情景,或被测车辆的某种内部系统状态等。这个挑战的重点在于,得实现某些交通场景或情景,才算作完成了测试目的;然而被测车辆可能会主动尝试避开该情景(ID07),或不符合测试设计人员的预期,这使得测试执行更加具有挑战性,甚至是不可实现的。

编者评述

「CH-D2」可能是一个伪问题。针对在ODD内完成相对连续、完整、多场景覆盖的行驶任务的L4自动驾驶系统,其测试应该以场景空间为手段;而不应该以测试用例(特别以时刻、以测试条件为核心的测试用例)为手段。简言之,测试方案需给被测系统留出足够的自主空间,而非「逼其就范」。最直接的例子就是,针对具有一定预防性安全能力的ADS,如何测试标准化的「鬼探头」「切入」用例?

这个挑战应该引发我们更突破性的思考,而不是强行去适配。是否应该从“应激式”转换到“沉浸式”的测试思路?

CH-D3周边交通的协调「coordination of the surrounding traffic」:其他交通参与者的移动扩展了一个场景的参数空间。问题是如何利用周围交通参与者的移动来创造情景的变化,以及哪些移动是需要被考虑的。另一个挑战是找到控制方法,使周围交通的行为既真实又符合场景要求。正如一位受访专家所说:困难之一是如何协调其他交通参与者的运动(ID11)。

编者评述

「CH-D3」这个挑战包含了两部分:认识「WHAT」和实现「HOW」。

前者主要是围绕对测试场景的认识和构建,主要方向是从时刻到片段,从测试工况到更大范围的场景(含更多的交通参与者及描述参与者行为的维数)。是与CH-A3场景复杂性和CH-A11场景串联等一脉相承的挑战。

后者是实现问题,包括在仿真中的实现和在场地测试中的实现。与CH-B9驾驶员模型和CH-C2测试自动化、对象和基础设施之间的交互等有关。

— 3 —

与其他相关研究结果的比较

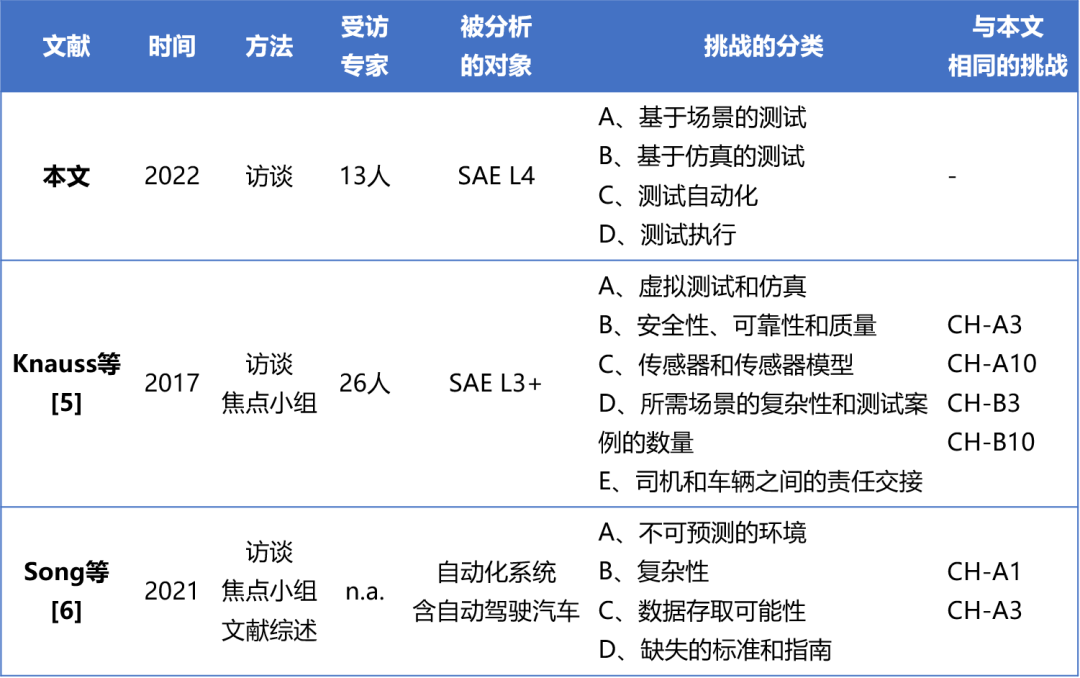

(1)与相关实证研究的对比

本文选取了两个类似的包含访谈方式的研究([5]、[6])进行了比较,具体对比内容见下表。

(2)是否已有相关方法应对上述挑战?

本文列出了现有的、应对前面提出的31个挑战的方法,共分为3种程度(见下表第三列「相关文献」):

可解决的:有相关文献直接应对该挑战

有借鉴的:不能直接与现有方法联系起来,但有其相关的挑战及对应的方法可借鉴(蓝底色)

仍空白的:没有对应的文献(黄底色)

编者评述

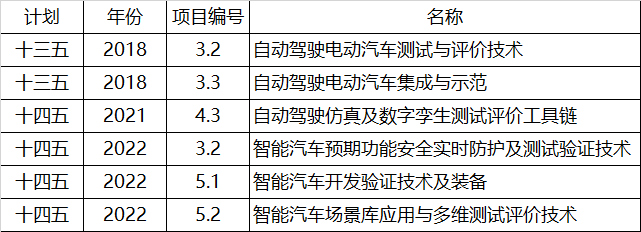

在上述表格的最右侧(第四列),编者增加了一列我国相关科研项目与之的对应情况。粗略地比较了重点研发计划“新能源汽车”重点专项近4年内的6个相关项目指南内容(见下表)与对本文31个挑战的呼应情况。

从中也能看出,有些挑战已经超出了技术研究的范畴,需要有更高维度的牵动和组织,或者两者的紧密结合。

以下接原文中对该上述表格的补充介绍。

A、基于场景的测试

CH-A7:关于场景获取,[15]和[16]提出了数据驱动和知识驱动方法的概述,可以被视为进一步研究的起点。

CH-A3:为了应对场景的复杂性,提出了一个用于场景描述的六层模型[13]和三个抽象层次,即功能、逻辑和具体场景[12]。

CH-A2:标准化小组还致力于为仿真开发一致的场景描述语言[8]。

CH-A12:测试完成标准的定义是一个当前的研究课题,可由[20]和[21]解决。

然而,对于将测试场景转换为里程指标(CH-A13)以及场景串联(CH-A11)等挑战,则没有找到相关的文献。

B、基于仿真的测试

CH-B1:汽车行业很清楚虚拟测试和真实之间的差异,这阻碍了纯虚拟测试。然而,ADS的相关认证流程也可能借鉴现有的电子稳定控制系统(ESC)的基于仿真的认证流程[24]。

CH-B8:仿真模型验证的其他建议,在[22]、[24]、[27]中被报道。

CH-B10和CH-B11:对于传感器模型,[29]对相关建模方法进行了文献综述。

CH-B5:[16]讨论了由于未知因素而遗漏相关场景的问题,并且参考了[25]和ISO/PAS 21448。

C、测试自动化

CH-C1、CH-C2、CH-C3都是汽车行业中的热点话题。关于标准化接口和测试实现的方法已有了一些,例如[31]和[32]。

D、测试执行

CH-D2:实现测试条件的挑战很突出,它被受访者提及的比例非常高,这也可以在[1]中找到。然而,克服这个问题的解决方案在文献和研究项目中讨论得很少。

CH-D3:[34]中提出的一种用于网联和自动化车辆组队协调的方法,可以应用到控制被测车辆周围交通中,尽管该方法的开发并不是为了用于自动驾驶汽车的测试过程。同时,[33]中可以找到一种专门用于测试自动驾驶汽车运动规划的方法,使用进化算法来优化其他交通参与者的轨迹。

— 4 —

编者展望

最后,编者希望介绍应对其中3个挑战的方案。

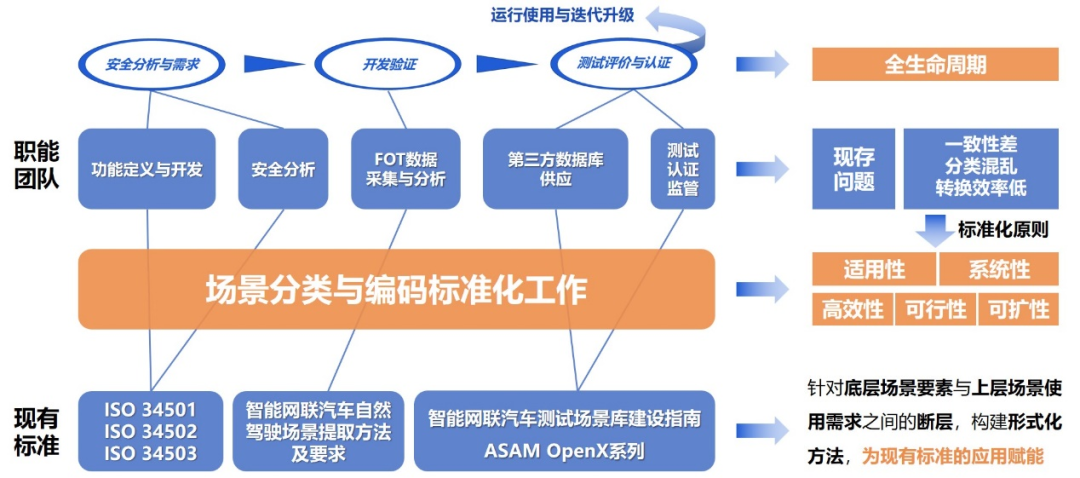

CH-A4 多功能场景描述 => 场景分类

建议一套可以服务于V型开发流程(左侧和右侧),甚至AV整个生命周期的所需的、通用的场景分类和形式化描述方法,保障场景的衔接性和一致性。

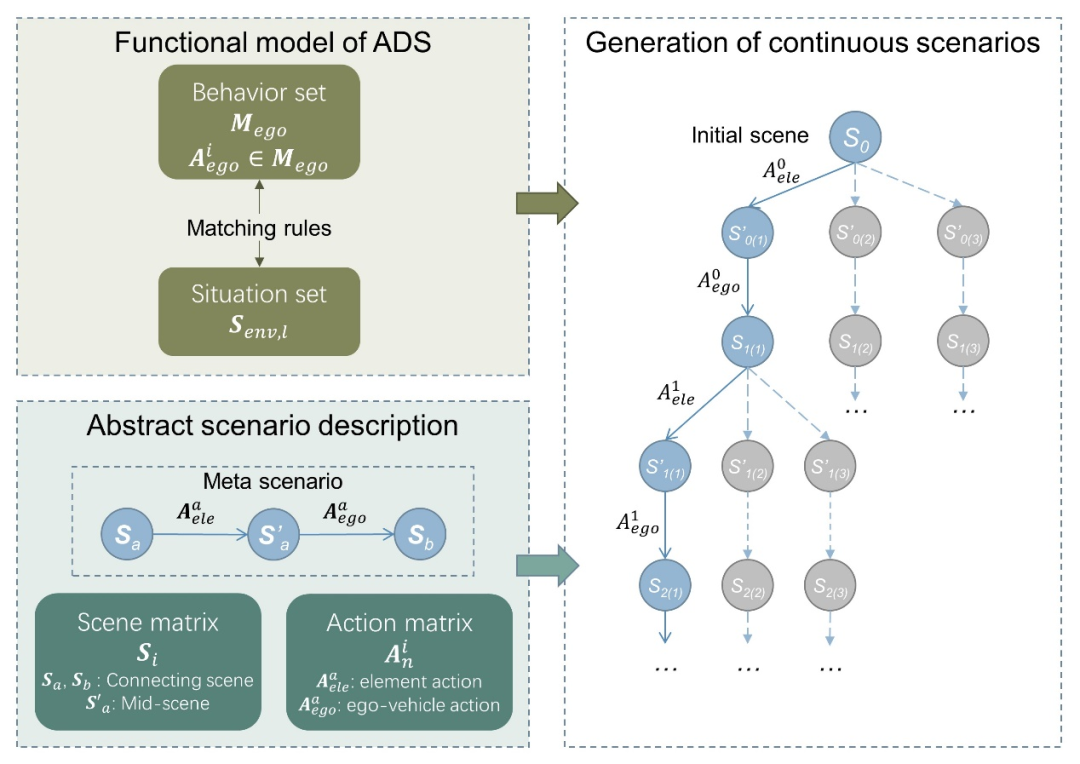

CH-A11 场景串联 => 连续场景生成方法

通过将多个基元场景(包含一次交互动作的短时场景)串联形成复杂连续场景,服务于高等级自动驾驶功能多个行为连续变换的测试,考察系统的综合性能,提高测试效率。

CH-B9 驾驶员模型 => 用于自演绎场景生成的类人驾驶模型

借助对人类驾驶员在自然交通中的行驶轨迹信息,或借助驾驶能力模型、情绪和偏好模型、决策动机模型等,以机器学习的方法获得多元化的类人驾驶模型,生成自演绎场景,乃至构成自演绎测试系统,提高测试效率并有助于发现未知(CH-B5)。

「参考文献」

[1] P. Koopman and M. Wagner, “Challenges in autonomous vehicle testing and validation,” SAE International Journal of Transportation Safety, vol. 4, no. 1, pp. 15–24, 2016.

[2] On-Road Automated Driving (ORAD) committee, Taxonomy and Definitions for Terms Related to Driving Automation Systems for On-Road Motor Vehicles, apr 2021. [Online]. Available: https://doi.org/10.4271/J3016 202104

[3] C. Roesener, F. Fahrenkrog, A. Uhlig, and L. Eckstein, “A scenariobased assessment approach for automated driving by using time series classification of human-driving behaviour,” in 2016 IEEE 19th International Conference on Intelligent Transportation Systems (ITSC), 2016, pp. 1360–1365.

[4] A. Knauss, J. Schroder, C. Berger, and H. Eriksson, “Software-related challenges of testing automated vehicles,” in 2017 IEEE/ACM 39th International Conference on Software Engineering Companion (ICSE-C), 2017, pp. 328–330.

[5] A. Knauss, J. Schroder, C. Berger, and H. Eriksson, “Paving the ¨ roadway for safety of automated vehicles: An empirical study on testing challenges,” in 2017 IEEE Intelligent Vehicles Symposium (IV), 2017, pp. 1873–1880.

[6] Q. Song, E. Engstrom, and P. Runeson, “Concepts in testing of ¨ autonomous systems: Academic literature and industry practice,” in 2021 IEEE/ACM 1st Workshop on AI Engineering - Software Engineering for AI (WAIN), 2021, pp. 74–81.

[7] P. Runeson and M. Host, “Guidelines for conducting and reporting ¨ case study research in software engineering,” Empirical software engineering, vol. 14, no. 2, pp. 131–164, 2009.

[8] ASAM e. V., “Asam openscenario.” [Online]. Available: https://www.asam.net/standards/detail/openscenario/

[9] F. Witte, “Testautomatisierung,” in Testmanagement und Softwaretest, F. Witte, Ed. Wiesbaden: Springer Fachmedien Wiesbaden, 2019, pp. 231–241.

[10] DIN SAE Consortium, “Terms and definitions related to testing of automated vehicle technologies,” 2019. [Online]. Available: https://www.sae.org/standards/content/dinsaespec91381/

[11] M. Steimle, T. Menzel, and M. Maurer, “Toward a consistent taxonomy for scenario-based development and test approaches for automated vehicles: A proposal for a structuring framework, a basic vocabulary, and its application,” IEEE Access, vol. 9, pp. 147 828–147 854, 2021.

[12] T. Menzel, G. Bagschik, and M. Maurer, “Scenarios for development, test and validation of automated vehicles,” in 2018 IEEE Intelligent Vehicles Symposium (IV), 2018, pp. 1821–1827.

[13] J. Bock, R. Krajewski, L. Eckstein, J. Klimke, J. Sauerbier, and A. Zlocki, “Data basis for scenario-based validation of had on highways,” in 27th Aachen colloquium automobile and engine technology, 2018, pp. 8–10.

[14] F. Bock, C. Sippl, A. Heinz, C. Lauerz, and R. German, “Advantageous usage of textual domain-specific languages for scenario-driven development of automated driving functions,” in 2019 IEEE International Systems Conference (SysCon), 2019, pp. 1–8.

[15] S. Riedmaier, T. Ponn, D. Ludwig, B. Schick, and F. Diermeyer, “Survey on scenario-based safety assessment of automated vehicles,” IEEE Access, vol. 8, pp. 87 456–87 477, 2020.

[16] C. Neurohr, L. Westhofen, T. Henning, T. d. Graaff, E. Mohlmann, and ¨ E. Bode, “Fundamental considerations around scenario-based testing ¨ for automated driving,” in 2020 IEEE Intelligent Vehicles Symposium (IV), 2020, pp. 121–127.

[17] D. Bogdoll, J. Breitenstein, F. Heidecker, M. Bieshaar, B. Sick, T. Fingscheidt, and M. Zollner, “Description of corner cases in automated driving: Goals and challenges,” in Proceedings of the IEEE/CVF International Conference on Computer Vision, 2021, pp. 1023–1028.

[18] A. Heinz and J. S. Wolfram Remlinger, “Track-/scenario-based trajectory generation for testing automated driving functions,” in 8. Tagung Fahrerassistenz, 2017.

[19] H.-P. Schoner and W. Hurich, “Testing with coordinated automated ¨ vehicles,” in Handbook of Driver Assistance Systems, H. Winner, S. Hakuli, F. Lotz, and C. Singer, Eds. Cham: Springer International Publishing, 2016, pp. 261–276.

[20] F. Hauer, T. Schmidt, B. Holzmuller, and A. Pretschner, “Did we test all scenarios for automated and autonomous driving systems?” in 2019 IEEE Intelligent Transportation Systems Conference - ITSC, 2019, pp. 2950–2955.

[21] W. Wang, C. Liu, and D. Zhao, “How much data are enough? a statistical approach with case study on longitudinal driving behavior,” in IEEE Transactions on Intelligent Vehicles, 2017, pp. 85–98.

[22] M. Wood, P. Robbel, M. Maass, R. D. Tebbens, M. Meijs, M. Harb, J. Reach, K. Robinson, D. Wittmann, T. Srivastava, et al., “Safety first for automated driving,” Aptiv, Audi, BMW, Baidu, Continental Teves, Daimler, FCA, HERE, Infineon Technologies, Intel, Volkswagen, 2019.

[23] Y. Page, F. Fahrenkrog, A. Fiorentino, J. Gwehenberger, T. Helmer, M. Lindman, O. op den Camp, L. van Rooij, S. Puch, M. Franzle, ¨ et al., “A comprehensive and harmonized method for assessing the effectiveness of advanced driver assistance systems by virtual simulation: The pears,” in . ., 2015, pp. 1–12.

[24] H. Abdellatif and C. Gnandt, “Use of simulation for the homologation of automated driving functions,” ATZelectronics worldwide, vol. 14, no. 12, pp. 68–71, 2019.

[25] H. Lakkaraju, E. Kamar, R. Caruana, and E. Horvitz, “Identifying unknown unknowns in the open world: Representations and policies for guided exploration,” in Thirty-first aaai conference on artificial intelligence, 2017.

[26] M. Steimle, N. Weber, and M. Maurer, “Toward generating sufficiently valid test case results: A method for systematically assigning test cases to test bench configurations in a scenario-based test approach for automated vehicles,” IEEE Access, vol. 10, pp. 6260–6285, 2022.

[27] S. Riedmaier, J. Nesensohn, C. Gutenkunst, T. Duser, B. Schick, ¨ and H. Abdellatif, “Validation of x-in-the-loop approaches for virtual homologation of automated driving functions,” in 11th Graz Symposium Virtual Vehicle, 2018.

[28] J. Klimke, D. Becker, and L. Eckstein, “System design of an agent model for the closed-loop simulation of relevant scenarios in the development of ads,” in 29th Aachen Colloquium Sustainable Mobility 2020, 2020, pp. 1493–1530.

[29] M. Hoss, M. Scholtes, and L. Eckstein, “A review of testing objectbased environment perception for safe automated driving,” Automotive Innovation, pp. 1–28, 2022.

[30] T. Fricke, F. Schuck, J. Vogelpohl, J. Ax, R. Stolpe, and H. Amelunxen, “Collaborative development of a test environment for automated driving,” in 20th International Congress and Exhibition, ser. VDI-Berichte, 2021, vol. 2384, pp. 5–16.

[31] ASAM e. V., “Asam xil.” [Online]. Available: https://www.asam.net/standards/detail/xil/

[32] C. Karthaus, A. Bick, B. Douglas, and F. Hanke, “X-in-the-loop-a universal testing methodology,” ATZelectronics worldwide, vol. 16, no. 11, pp. 46–51, 2021.

[33] M. Klischat and M. Althoff, “Generating critical test scenarios for automated vehicles with evolutionary algorithms,” in 2019 IEEE Intelligent Vehicles Symposium (IV), 2019, pp. 2352–2358.

[34] J. Wu, S. Ahn, Y. Zhou, P. Liu, and X. Qu, “The cooperative sorting strategy for connected and automated vehicle platoons,” Transportation Research Part C: Emerging Technologies, vol. 123, p. 102986, 2021

最新资讯

-

中汽中心工程院能量流测试设备上线全新专家

2025-04-03 08:46

-

上新|AutoHawk Extreme 横空出世-新一代实

2025-04-03 08:42

-

「智能座椅」东风日产N7为何敢称“百万级大

2025-04-03 08:31

-

基于加速度计补偿的俯仰角和路面坡度角估计

2025-04-03 08:30

-

《北京市自动驾驶汽车条例》正式实施 L3级

2025-04-02 20:23

广告

广告