反向强化学习(IRL)的三种方法

反向强化学习(IRL)是一种旨在解决自主决策问题的方法,它可以通过推断输入和输出之间的潜在因果关系来避免传统方法的局限性。IRL方法需要在开始时收集一组专家轨迹,并且不是简单地学习状态-动作映射,而是首先推断这些专家轨迹,然后基于复杂的奖励函数优化行为策略。IRL方法可以分为最大裕度方法、贝叶斯方法和最大熵方法三类。

在最大裕度方法中,IRL利用专家轨迹评估奖励函数,该函数使得最优策略和次优策略之间的裕度最大。这些方法使用线性组合算法表示具有一组特征的奖励函数,其中所有特征都被认为是独立的。Andrew Wu是该领域的先驱,他引入了第一个最大裕度IRL方法,该方法提出了三种计算精细奖励函数的算法。此外,Pieter等人设计了一种优化算法,该算法假设专家奖励函数可以表示为已知特征的手动线性组合,以揭示权重和特征之间的潜在关系。

然而,IRL方法的局限性在于,专家轨迹的质量和分布设置了该方法性能的上限。作为回应,Umar等人提出了一种基于博弈论的IRL方法,称为乘法权重,用于学徒学习。它能够将关于每个特征权重的先验策略导入代理,并利用线性规划算法来修改奖励函数,使其策略是稳定的。

另一方面,贝叶斯方法通常利用奖励的优化轨迹或先验分布来最大化奖励的后验分布。Ramachandran等人提出了第一个贝叶斯IRL方法,从贝叶斯的角度参考了IRL模型,并从先验分布推断出估计的奖励函数的后验分布。Levine等人将核函数集成到贝叶斯IRL模型中,以提高估计奖励的准确性,并提高隐形驾驶的性能。

最大熵方法是通过在优化例程中使用最大熵来估计奖励函数来定义的。与以前的IRL方法相比,最大熵方法更适合连续空间,并且具有解决专家轨迹次优影响的潜在能力。Ziebart提出了第一个最大熵IRL模型,该模型利用了与相同的方法,可以缓解专家轨迹中的噪声和不完美行为。代理试图通过将特征线性映射到奖励来优化监督下的奖励函数。

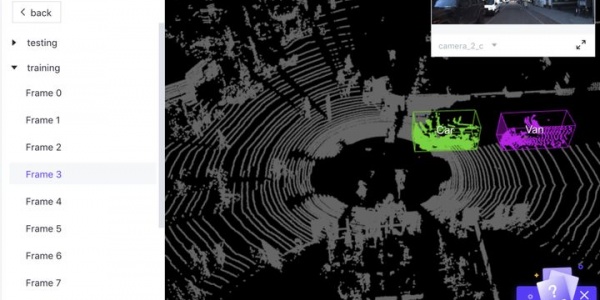

在自动驾驶领域,IRL为许多出色的工作提供了支持。然而,与上述方法一样,它在拐角情况下也存在长尾问题。如何有效地提高IRL的稳健性和可解释性也是未来的方向。

在最大裕度方法中,Andrew Wu提出了三种计算精细奖励函数的算法,其中一种是基于非负矩阵分解(NMF)的方法。该方法将专家轨迹表示为一个矩阵,其中每一行是一个状态特征向量,每一列是一个动作。通过NMF算法分解这个矩阵,可以得到一个非负的奖励函数,该函数可以在给定的状态下最大化最优策略和次优策略之间的裕度。

在贝叶斯方法中,IRL的主要挑战是后验分布的计算。Ramachandran等人提出了一个基于随机梯度哈密尔顿蒙特卡洛(SGHMC)的算法,用于有效地计算后验分布。该算法使用随机梯度下降来估计奖励函数,并利用哈密尔顿蒙特卡洛算法来采样后验分布。该方法可以有效地处理大规模数据集,并在实验中表现出更好的性能。

在最大熵方法中,IRL的主要挑战是设计合适的特征函数和权重。Ziebart提出了一种基于状态分布的特征函数,用于捕捉状态之间的相似性。该方法可以缓解专家轨迹中的噪声和不完美行为,并提高IRL方法的性能。

除了传统的IRL方法外,还有一些新的IRL方法被提出。例如,DeepIRL方法使用深度神经网络来近似奖励函数,并结合生成对抗网络(GAN)来生成专家轨迹。InfoGAIL方法利用信息瓶颈理论来提高GAIL的性能。Directed-InfoGAIL方法使用信息瓶颈理论来指导GAN的生成过程。Co GAIL方法使用协作GAN来生成专家轨迹和竞争策略,并且在连续控制问题中表现出更好的性能。

虽然IRL在自主决策问题中取得了很大的进展,但仍然存在一些挑战和未解决的问题。首先,IRL方法需要收集专家轨迹,但专家轨迹的质量和分布会直接影响IRL方法的性能。此外,IRL方法在拐角情况下容易出现长尾问题,因此需要更好的方法来提高IRL的稳健性和可解释性。

其次,IRL方法需要大量的计算资源来处理大规模数据集。在实际应用中,如何有效地利用硬件资源来加速IRL方法的计算成为一个重要问题。

最后,IRL方法在解决自主决策问题时需要考虑多种因素,如环境约束、安全性、效率和可解释性等。如何平衡这些因素,以实现一个既能够提供高质量决策,又能够保证安全和效率的自主决策系统,是IRL方法未来研究的一个重要方向。

总之,IRL作为一种新的自主决策方法,已经在自动驾驶、机器人控制、游戏智能等领域取得了广泛的应用。未来,IRL方法将面临更多挑战和机遇,我们需要不断探索新的技术和方法,以实现更加智能、高效、安全和可解释的自主决策系统。

最新资讯

-

大卓智能端到端直播实测,16公里复杂路段挑

2025-04-25 17:16

-

《汽车轮胎耐撞击性能试验方法-车辆法》等

2025-04-25 11:45

-

“真实”而精确的能量流测试:电动汽车能效

2025-04-25 11:44

-

GRAS助力中国高校科研升级

2025-04-25 10:25

-

梅赛德斯-AMG使用VI-CarRealTime开发其控制

2025-04-25 10:21

广告

广告