“端到端”自动驾驶的安全问题

4.1 汽车功能安全方法论简述

在汽车行业,功能安全是保障车辆安全运行的关键要素,其核心依据是国际标准 ISO 26262《道路车辆功能安全》 。该标准专门针对汽车电子电气系统,旨在降低因系统故障而引发的不合理风险,确保车辆在整个生命周期内的安全性。功能安全的核心目标在于追求系统运行的确定性,尽可能避免故障发生,并在故障不可避免时,保障车辆和人员的安全 。

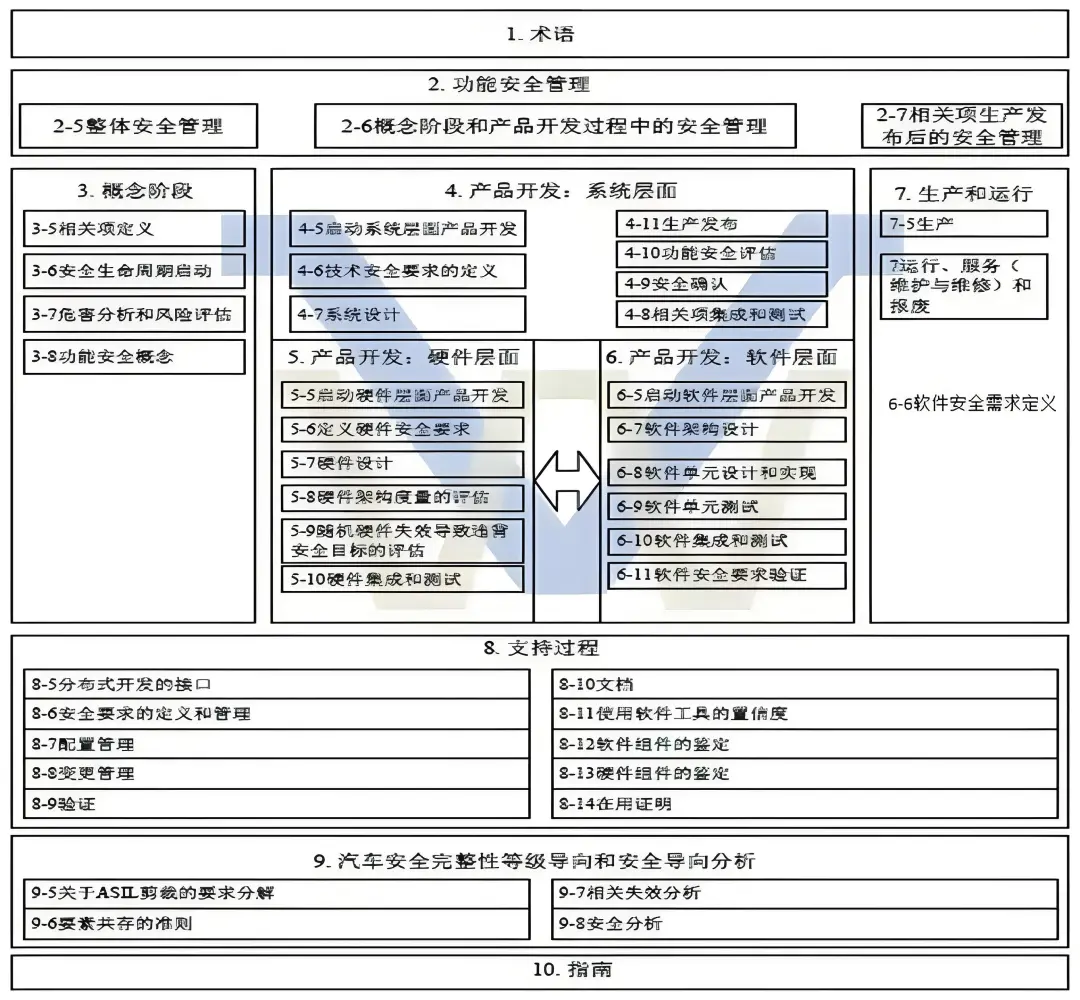

图 4:汽车功能安全标准 ISO 26262 框架图

为了实现这一目标,ISO 26262 从多个维度进行了规范和约束。在系统开发流程上,它遵循严格的 V 模型开发流程,从项目概念阶段开始,逐步进行需求分析、设计、实现、测试和验证等环节,每个环节都有明确的输入、输出和审查要求 。在需求分析阶段,需要对车辆的功能需求进行详细梳理,明确每个功能的安全目标和安全需求,并将其转化为具体的技术指标和规范。在设计阶段,要考虑系统的架构设计、硬件设计和软件设计,确保系统具备足够的安全性和可靠性。例如,采用冗余设计、故障检测与诊断机制等,以提高系统的容错能力。在实现阶段,要按照设计要求进行硬件和软件的开发,并进行严格的代码审查和测试,确保代码的质量和安全性。在测试和验证阶段,要通过各种测试手段,如功能测试、性能测试、可靠性测试、安全性测试等,验证系统是否满足安全要求和设计规范 。

在风险评估方面,ISO 26262 引入了汽车安全完整性等级(ASIL)的概念,根据危害事件的严重度、暴露率和可控性,将风险分为 ASIL A、ASIL B、ASIL C 和 ASIL D 四个等级,其中 ASIL D 表示最高风险等级 。对于不同的 ASIL 等级,标准规定了相应的安全措施和开发要求,以确保风险得到有效控制。对于 ASIL D 等级的系统,要求采用高度可靠的硬件和软件设计,具备多重冗余和故障检测机制,以最大程度地降低故障发生的概率和影响。

在安全分析方法上,ISO 26262 推荐了多种方法,如故障模式及影响分析(FMEA)、故障树分析(FTA)、危害分析与风险评估(HARA)等 。这些方法从不同角度对系统进行分析,识别潜在的故障模式和危害,评估其对系统安全的影响,并制定相应的风险应对措施。通过 FMEA,可以分析系统中每个组件的故障模式及其对整个系统的影响,确定故障的严重程度和发生概率,从而采取相应的预防和纠正措施;通过 FTA,可以从系统的顶事件出发,逐步分析导致顶事件发生的各种原因,构建故障树,找出系统的薄弱环节,采取针对性的改进措施 。

4.2 矛盾点剖析

1. 确定性与不确定性的冲突:

汽车功能安全方法论的核心是追求确定性,通过严谨的开发流程、风险评估和安全分析方法,确保系统在各种工况下都能按照预期运行,将风险控制在可接受的范围内 。而端到端自动驾驶方案由于基于人工智能技术,其决策过程存在内在的不确定性。如前文所述,端到端模型的黑盒特性使得其内部的决策逻辑难以解释,无法像传统系统那样提供明确的决策依据和确定性的行为预测 。在遇到复杂的交通场景时,端到端模型可能会因为对环境信息的理解偏差或训练数据的局限性,做出不可预测的决策,这与功能安全追求的确定性原则背道而驰。当遇到道路上有异物或非标准交通标志时,端到端模型可能无法准确判断,导致车辆采取错误的驾驶行为,如不减速或不避让,从而引发安全事故 。

2. 风险评估与应对的差异:

功能安全方法论通过严格的风险评估流程,如 HARA 等方法,对系统可能面临的各种危害进行全面识别和分析,根据风险等级制定相应的安全措施,以降低风险发生的概率和影响 。而端到端自动驾驶方案由于其不可解释性,难以用传统的风险评估方法来准确量化和评估风险。由于无法清晰地了解模型的决策过程和潜在的故障模式,很难确定在不同场景下模型可能出现的错误以及这些错误对车辆安全的影响程度 。在面对新的、未在训练数据中出现的场景时,传统的风险评估方法无法有效地评估端到端模型的安全性,使得风险应对措施难以制定。这就导致在实际应用中,端到端自动驾驶方案可能面临着无法有效评估和应对的安全风险,增加了事故发生的可能性 。

5.1 典型安全事故案例列举

近年来,端到端自动驾驶汽车发生了多起引人关注的安全事故,这些事故不仅给人们的生命和财产带来了损失,也引发了公众对自动驾驶技术安全性的担忧。2018 年,一辆特斯拉 Model X 在自动驾驶模式下失控,撞上了加州的一辆移动救护车,导致司机和乘客受伤 。事故发生时,车辆正处于自动辅助驾驶状态,据推测,可能是由于系统对救护车的识别出现偏差,或者在决策过程中未能及时做出正确的避让动作,从而导致了碰撞事故的发生。

2019 年,Uber 的自动驾驶汽车在亚利桑那州进行测试时,撞到一名行人,导致其死亡 。这起事故是自动驾驶领域的一个重大事件,引发了对自动驾驶汽车测试的安全性和道德问题的广泛讨论。在事故发生时,车辆的传感器应该能够检测到行人的存在,但由于端到端模型的决策机制不明确,可能未能准确判断行人的意图和行动轨迹,导致车辆未能及时采取制动或避让措施。

2022 年,一辆特斯拉 Model 3 在加州高速公路上发生自动驾驶事故,车辆未能正确识别前方道路上的障碍物,导致撞车 。据分析,可能是因为当时的光照条件、障碍物的形状或颜色等因素影响了传感器的数据采集,而端到端模型在处理这些复杂数据时,无法准确理解环境信息,从而做出了错误的决策,未能及时刹车或改变行驶方向,最终导致了事故的发生。

2024 年 7 月 7 日下午,武汉市汉阳区发生一起涉及 “萝卜快跑” 无人驾驶出租车的交通事故 。事故发生在鹦鹉大道与国博大道交叉口,无人车在绿灯亮起启动时与一名闯红灯的行人发生轻微碰撞。虽然此次事故未造成严重后果,但也引发了人们对自动驾驶车辆在复杂交通场景下应对能力的质疑。在这种情况下,端到端自动驾驶系统可能由于对行人的行为预测不准确,或者对交通信号灯变化后的复杂路况处理不当,导致未能及时做出有效的避让反应。

5.2 从不可解释性角度深挖原因

从这些事故中可以看出,端到端模型的不可解释性是导致事故发生的一个重要因素。由于无法准确判断事故发生时系统的决策依据,很难确定事故的根本原因,也难以采取有效的预防和解决措施。在特斯拉 Model X 撞上救护车的事故中,由于端到端模型的黑盒特性,无法确切知道模型是如何识别救护车的,是将其误判为其他物体,还是在决策过程中出现了逻辑错误,这些都无法得到明确的答案 。这使得研发人员难以针对问题进行针对性的改进,也无法向公众解释事故发生的原因,从而降低了公众对自动驾驶技术的信任度。

在 Uber 自动驾驶汽车撞人事故中,同样由于模型的不可解释性,无法确定系统在检测到行人后,为什么没有及时采取有效的制动或避让措施 。是因为模型对行人的运动轨迹预测不准确,还是在决策过程中受到了其他因素的干扰,这些都无从得知。这种不确定性使得自动驾驶系统在面对复杂的交通场景时,存在着巨大的安全隐患,一旦出现错误决策,就可能导致严重的后果。

对于特斯拉 Model 3 在高速公路上的撞车事故,端到端模型的不可解释性使得我们无法了解系统在面对前方障碍物时的决策过程 。是因为传感器数据的噪声干扰导致模型对障碍物的识别错误,还是模型内部的算法在处理数据时出现了偏差,这些都难以确定。这也使得在后续的技术改进中,缺乏明确的方向和依据,无法有效地提高系统在复杂环境下的安全性和可靠性。

在武汉 “萝卜快跑” 无人驾驶出租车与行人碰撞事故中,端到端自动驾驶系统对行人闯红灯这一异常行为的处理能力受到质疑 。由于模型的不可解释性,无法明确系统是否正确识别了行人的行为,以及在决策过程中是否考虑到了行人闯红灯的可能性。如果不能深入了解模型的决策机制,就难以对系统进行优化,提高其在复杂交通场景下的应对能力。

6.1 可解释人工智能(XAI)技术的引入

1. XAI 技术原理及应用前景:

可解释人工智能(XAI)技术致力于打破人工智能模型的黑盒特性,让模型的决策过程和输出结果变得可理解、可解释 。其核心原理是通过一系列的技术手段,揭示模型内部的工作机制和决策逻辑。其中,特征重要性分析是一种常用的方法,它通过计算每个输入特征对模型输出的影响程度,来确定哪些特征在决策过程中起到了关键作用 。对于一个基于图像识别的自动驾驶决策模型,通过特征重要性分析可以发现,车辆前方行人的位置、速度以及与本车的距离等特征,对于模型做出避让决策具有较高的重要性。

可视化技术也是 XAI 的重要组成部分,它将模型的内部状态和决策过程以直观的图形或图像形式展示出来 。在自动驾驶中,可以利用可视化技术展示神经网络中各层的激活情况,以及不同特征在模型中的传播路径。通过热力图可以直观地看到图像中哪些区域被模型重点关注,从而帮助理解模型是如何从图像中提取关键信息并做出决策的。在遇到十字路口的场景时,通过可视化可以清晰地看到模型对交通信号灯、其他车辆和行人等关键元素的识别和处理过程,使决策过程更加透明。

在端到端自动驾驶中,XAI 技术具有广阔的应用前景。它可以帮助研发人员更好地理解模型的行为,发现模型中的潜在问题和缺陷,从而有针对性地进行优化和改进 。在模型训练过程中,通过 XAI 技术可以实时监控模型的决策过程,及时发现模型是否出现过拟合或欠拟合现象,以及是否存在对某些特殊场景的误判。在模型部署后,XAI 技术可以为驾驶员或监管人员提供决策解释,增强他们对自动驾驶系统的信任和接受度 。当车辆在行驶过程中做出紧急制动或避让决策时,XAI 技术可以向驾驶员解释决策的原因,如检测到前方突然出现的障碍物或其他车辆的异常行为,让驾驶员更好地理解和接受自动驾驶系统的操作。

2. 结合案例分析潜在优势:

XAI 技术在其他领域的应用已经取得了显著的成果,为其在自动驾驶领域的应用提供了有力的参考。在医疗领域,XAI 技术被用于辅助医生进行疾病诊断 。IBM Watson for oncology 是一款基于人工智能的医疗诊断系统,它利用 XAI 技术对大量的医学文献和病例数据进行分析和学习,能够为医生提供癌症诊断和治疗建议。在面对复杂的癌症病例时,该系统可以通过可视化的方式展示其诊断依据和推理过程,帮助医生更好地理解和评估诊断结果。通过分析患者的基因数据、影像资料和临床症状等多源信息,系统可以生成一份详细的诊断报告,其中不仅包含诊断结果,还会解释每个信息源在诊断过程中的作用和贡献,使医生能够更加信任和依赖该系统的诊断建议 。

在金融领域,XAI 技术被用于风险评估和投资决策 。一些金融机构利用 XAI 技术开发了智能投资顾问系统,该系统可以根据市场数据、投资者的风险偏好和投资目标等因素,为投资者提供个性化的投资建议。通过特征重要性分析,系统可以向投资者解释每个投资决策背后的关键因素,如市场趋势、行业前景、公司财务状况等,让投资者更好地理解自己的投资行为和风险状况 。在评估一只股票的投资价值时,系统可以展示出影响其评估结果的主要因素,如公司的盈利能力、市场份额、市盈率等,帮助投资者做出更加明智的投资决策。

在自动驾驶领域,XAI 技术同样具有巨大的潜力。通过引入 XAI 技术,可以帮助理解决策过程,提升安全性 。当车辆在行驶过程中遇到前方道路施工的场景时,XAI 技术可以向驾驶员解释自动驾驶系统是如何识别出施工区域的,以及为什么选择了特定的绕行路线或减速策略。通过分析传感器数据和模型的决策逻辑,XAI 技术可以展示出系统对施工标志、障碍物和道路状况等关键信息的识别和处理过程,让驾驶员更好地理解和信任自动驾驶系统的决策 。这不仅可以提高驾驶员对自动驾驶系统的接受度,还可以在关键时刻帮助驾驶员做出正确的决策,避免事故的发生。

编辑推荐

最新资讯

-

自动驾驶卡车创企Kodiak 将通过SPAC方式上

2025-04-19 20:36

-

编队行驶卡车仍在奔跑

2025-04-19 20:29

-

全国汽车标准化技术委员会汽车节能分技术委

2025-04-18 17:34

-

我国联合牵头由DC/DC变换器供电的低压电气

2025-04-18 17:33

-

中国汽研牵头的首个ITU-T国际标准正式立项

2025-04-18 17:32

广告

广告