基于CNN的长期和大规模环境中的视觉位置识别

作者:Jianliang Zhu, Yunfeng Ai, Bin Tian, Dongpu Cao and Sebastian Scherer

Ⅰ.介绍

在不断变化的环境中长期导航[2]是当今机器人技术面临的主要挑战之一,因此视觉定位的主要问题之一是在长期和大规模环境中进行位置识别。然而,这是一项艰巨的挑战,因为一些地方不得不应对在不同周、不同月和不同的季节,甚至是一天中不同时间的重大变化。这些条件变化是由外部环境引起的,如光照、天气和季节。诸如快速外观映射(FAB-MAP)[1]等方法已被证明可以映射大型、具有挑战性的环境。最近,名为SeqSLAM [ 3 ]和ABLE - M [ 4 ]的算法定义了匹配序列图像的方法,以提高一些条件变化的鲁棒性。这些位置识别技术依赖于手工制作的功能,例如SIFT或LDB [4],非常不适合处理剧烈的视觉变化,例如从白天到夜晚,从一个季节到另一个季节,或从晴朗天气到雨。 图1给出了不同季节的例子。

图1.视觉位置识别系统必须能够( a )成功地匹配同一位置的感知上非常不同的图像,同时( b )也拒绝不同位置的相似图像对之间的不正确匹配。

最近深度学习技术和卷积神经网络的发展为理解位置识别问题提供了另一种方法。AlexNet [ 5 ]显示,从CNNs中提取的特征经过充分有效的训练,在分类任务上比手工制作的特征获得更好的结果。[ 7 ]提出了一个有效的深度学习框架来生成用于快速图像检索的二进制哈希代码。考虑到位置识别[8]与图像检索相似,我们有理由期望利用基于CNN的特征的力量来设计位置识别问题的解决方案。然而,在视觉定位中,除了对目标识别[9]的一些研究外,深度学习并没有得到充分的应用。在本论文中,我们提出了一种简单而有效的方法,利用改进的CNN模型提取图像描述符,增强图像序列的匹配以进行视觉位置识别。所提出的方法如图2所示,并将在后面的章节中详细介绍。我们的方法具有以下特点:

首先,我们提出了一个基于VGG16-Places365[10]改进的CNN架构。我们的模型适用于通过添加,删除和融合图层来提取图像特征的要求。

其次,我们将CNN层获得的特征转换为二进制表示,从而降低计算复杂度。其中一个主要的好处是他们可以使用汉明距离匹配位置。

第三,我们提出了一种算法,根据SeqSLAM和ABLE - m的一些思路,基于一系列图像来计算匹配最佳候选位置。

论文的其余部分如下所示。我们在第Ⅱ节中简要回顾了位置识别算法和CNN模型的相关工作;我们方法的细节将在第III节中介绍;第Ⅳ节给出了三个数据集的实验结果,比较了所提出方法的性能;最后,我们在第V节中总结了本文,并讨论了未来的工作。

II.相关工作

A.卷积神经网络(CNN)

卷积神经网络可以从训练数据库中学习图像特征。在过去的五年里,随着CNNs在计算机视觉领域变得越来越重要,人们已经做出了许多尝试来改进AlexNet [ 5 ]的原始架构,以获得更高的准确性,比如VGG 11、GoogLeNet 6、ResNet 10等。考虑到位置识别与图像检索相似,而且它是独立的,K. Lin等人[ 7 ]提出了一个有效的深度学习框架来生成用于快速图像检索的二进制哈希代码。

场景识别是另一个与视觉位置识别非常相似的领域,尽管这是深度学习中的一项分类任务。位置[10]包含超过1000万个包含365个独特场景类别的图像,是用于训练场景识别CNN模型的数据集。基于Places数据集和最先进的CNNs,许多研究人员培训了一些CNNs模型,并将其展示给其他研究人员使用。位置识别可以被看作是图像相似性匹配的一项任务,一些研究人员通过预先训练的CNNs模型来实现。从深度学习的进步中得到启发,我们提出了一个问题,我们可以利用深度CNN来实现视觉位置识别吗?

B.视觉位置识别

与其他传感器相比,视觉传感器具有价格低廉、体积小等优点,正成为当今最受欢迎的机器人传感器。循环闭包检测的一种流行方法是基于快速外观的映射(FAB-MAP)[1]。所提出的FAB-MAP使用单个关键点描述符,即尺度不变特征变换(SIFT),以及用于界标描述的离线词袋描述符(BoW)和用于预测循环闭包候选的贝叶斯过滤器。然而,FAB-MAP有一些不足之处,需要提前离线训练,并且在环境变化剧烈的场景中具有较差的稳健性。

如今,视觉定位面临的主要挑战是在长期大规模环境中的位置识别。为了在长期环境中提高拓扑定位的效率,许多其他技术被提了出来。在这方面,一个成功的方法是SeqSLAM,它在相同的路线下被评估为具有挑战性的条件。它引入了使用序列图像而不是单个图像来确定位置的思想,以改善长期方案的性能。

使用序列而不是单一图像利用了移动相机获取的视觉数据的时间一致性,从而减少了自我相似环境识别中的误报数量,并提高了对局部场景变化的容忍度。这个思想被ABLE-M [4]算法使用,它基本上减少了处理后的图像,并将全局二进制描述符与汉明距离的快速计算进行了比较。

深度学习技术和卷积神经网络的最新发展为理解位置识别问题提供了一种替代方法。Z. Chen, 等人[8]结合CNNs提取的有效特征,提出了一种基于Overfeat的视觉场所识别方法;X. Gao等人提出了一种新颖的方法,该方法采用改进的堆叠去噪自动编码器(SDA)来解决视觉SLAM系统的闭环检测问题;D. Bai等人[13]给出了一种融合AlexNet和SeqSLAM来检测循环闭包的方法。最近的建议启发了我们目前的工作,旨在提供一种基于改进和简化的CNN特征的更稳健和有效的位置识别算法。

III.我们的方法

在这一部分,我们描述了我们提出的方法的主要特征:CNN模型、提取图像描述符和相似性匹配。图2显示出了所提出的框架。

A.CNN模型

在第Ⅱ节A部分中,我们讨论了今年麻省理工学院计算机科学和人工智能实验室提出的Places数据集,实验室现在正根据数据集举办2017年地方挑战赛[15]。他们希望更多的研究人员使用他们的数据集来训练CNN用于场景识别任务,并提供基于CNN模型的Places365-CNN,例如AlexNet,VGG,GoogLeNet,ResNet在他们的数据集上训练。根据论文的实验结果,我们选择VGG16-Places365作为位置识别的基本模型,在多个数据集上具有最佳性能。

从LeNet-5 [16]开始,卷积神经网络通常具有标准的结构堆叠卷积层(可选地,随后是批量归一化和最大池化)之后是一个或多个完全连接的层。VGG 16 - Place 335与VGG具有相同的结构,它具有16个重量层,包括13个卷积层和3个完全连接的层。Places数据集包含超过1000万个包含365个唯一场景类别的图像,因此最后一个完全连接的图层的尺寸应修改为365。这13个卷积层被划分为5个部分,其中一个部分的每一层都有相同的数据维度。每个部分后面都有一个最大汇集层,该层通过2 x2像素窗口执行,跨距为2。卷积层的堆叠之后是三个完全连接的( FC )层:前两个层各有4096个信道,第三个层执行365路位置分类,因此包含365个信道(每类一个)。除了这些层之外,最后一层是soft-max层,并且所有隐藏层都配备有整流(ReLU)非线性。表1给出了VGG16-Places365网络的权重层和池化层的输出尺寸。

图2.视觉位置识别方法的全局系统架构。(从Nordland数据集的两个原因捕获图像,我们将序列定义为i和j。最后,图片是相似度矩阵的可视化。)

通过深层架构,CNN能够在不同的抽象层次上学习高级语义特性。有了深度架构,CNN能够在不同抽象级别学习高级语义特征。然而,图像的空间信息通过完全连接的层丢失,这在视觉位置识别等应用中可能是不理想的。在[ 8 ] [ 13 ]的实验结果表明,在卷积层产生的基于CNN的深层特征,在环路闭合检测中比全连接层特征获得更好的性能。根据这些,我们选择VGG16-Places365的三个层'conv3_3','conv4_3'和'conv5_3'来提取我们任务的图像特征。此外,我们对CNN模型进行了大量修改,包括添加几个池层和删除完全连接的层,以减少特征尺寸并节省图像处理时间。然后,在将三层的特征调整为一维后,我们使用连接[ 17 ]的操作来融合它们。我们做了很多实验来调整增加的池化层的网络参数,您可以在第Ⅳ节中看到实验细节。最终的模型结构如图3所示。

B.用于位置识别的特征描述符

视觉特征是影响图像匹配准确性的最重要因素之一。我们的方法使用从上面给出的CNN模型中提取的CNN特征,而不是传统手工制作的特征来计算图像之间的相似性。浮点是我们最终从模块中获取的CNN功能的类型。我们将该特征命名为Fcnn,其尺寸为1×100352。降低图像匹配的计算成本的实用方法是将特征向量转换为二进制代码,这可以使用汉明距离快速比较。我们首先将其每个元素标准化为8位整数(0~255),然后得到整数特征如(2)所示。然后,可以很容易地转换为二进制特征。

C.二值化的有效匹配

使用二进制描述符匹配汉明距离比使用L2范数匹配描述符更快更有效,并且在此用于计算图像之间的距离。在很多研究中,我们注意到他们通过匹配单个图像来计算两帧的相似度。如果我们将两个图像的特征描述符定义为

和

和 ,我们可以计算它们的汉明距离HmDij来表示相似性。计算过程如(3)所示。

,我们可以计算它们的汉明距离HmDij来表示相似性。计算过程如(3)所示。

因为在长期和大规模的环境中表现更好,所以像[ 3 ] [ 4 ]等作品中介绍的那样,位置被认为是图像序列而不是单个图像。在我们的方法中,我们将Slength定义为匹配当前帧的图像序列长度。因此,第i帧的图像序列由范围(i - Slength+1,i)中的连续图像组成,并且我们将

,

, ,...,

,..., 连接为用于匹配的最终特征Fi。在这种情况下,我们可以使用(4)的序列信息来获得图像之间的距离。该距离是不同地方的相似度得分,我们将其保持在相似度矩阵(M)中。如果我们发现两帧之间的距离小于给定的阈值,那么这些位置就会被成功识别。

连接为用于匹配的最终特征Fi。在这种情况下,我们可以使用(4)的序列信息来获得图像之间的距离。该距离是不同地方的相似度得分,我们将其保持在相似度矩阵(M)中。如果我们发现两帧之间的距离小于给定的阈值,那么这些位置就会被成功识别。

表一. VGG16 - Place335网络各层的输出尺寸

图3.基于vg16 - place 335的CNN模型用于视觉位置识别。(所有完全连接的层都被移除,三个名为pool 3 _ fuse、pool 4 _ fuse、pool 5 _ fuse的池层分别被添加到Conv 3 _ 3、Conv 4 _ 3和Conv 5 _ 3的背面。三个轮询层的输出被融合为最终的CNN特征。)

IV.绩效评估

在本节中,演示了一组离线实验来评估我们方法的性能。我们的实现是一个基于Caffe [18]的python程序,它是一个开源的深度学习框架。我们首先介绍数据集和评估指标,然后与公共数据集上的几种著名算法的性能进行比较。

A.数据集和评估指标

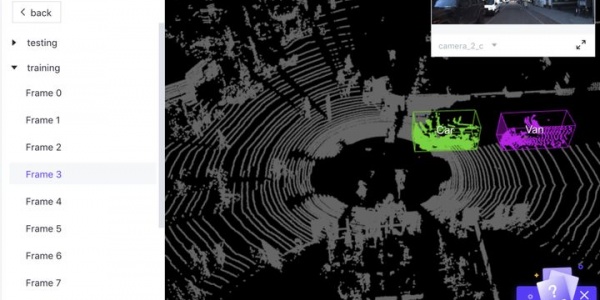

用于实验的第一个数据集是FAB-MAP最初使用的City Center [1]数据集。它是一个基本的数据集,广泛应用于闭环检测和位置识别研究实验,因此我们使用它来调整和优化网络模型。然后我们使用Nordland [2]数据集进行了测试,这些数据集是使用单目摄像机在长期条件下记录的。根据CNN模型的参数设置,我们将在每张图像进入网络之前对其进行224×224的新尺寸预处理。最常用的位置识别算法评估方法是绘制Precision-Recall(PR)曲线,该曲线提供了算法性能的更多信息。其主要要素定义如下:精度定义为检测总数的真正位置数;Recall被定义为真实地点的数量与地面真实地点的数量之比。(5)显示了计算过程。我们通过扫描不同的距离阈值θ来获得PR曲线,如(6)所示。

B.城市中心数据集中的结果

第一个数据集,城市中心[1],在康明斯和纽曼市中心附近的公共道路上收集。它包含1237对大小为640×480的图像,由两个摄像头(左和右)在机器人上拍摄,机器人以每1.5米一个图像的频率穿过环境。这些图像包括动态物体,此外,它是在有阳光的大风天收集的,这使得丰富的树叶和阴影特征不稳定,如图4 ( b )和4 ( c )所示。提供了数据集GPS信息和地面实况。机器人绕一个环路行进两次,总路径长度为2 km,当机器人绕第二个环路运行时,我们可以在这些位置实现位置识别,标记为红色曲线,如图4(a)所示。

图4.城市中心数据集。( ( a )是GPS信息的可视化,红色曲线是机器人运行的第二个环,我们应该在这些位置进行位置识别。( b )和( c )是该数据集的两对代表性图片。)

由于网络的输入只能是一个图像,我们只将左摄像头的图像作为我们的测试集。我们还在机器人退出循环后修改了一些地面实况值,因为当双目机器人在相同位置向后移动时,一个摄像机的图像完全不同。在这种情况下,不可能实现位置识别。

首先,我们在VGG16-Places365的每一层上做一些实验,PR曲线如图5(a)所示。如预期的,结果证明提取卷积特征获得了最佳效果,并且每一层的性能都优于FABMAP算法的开放工具箱open FABMAP [ 20 ]。图5的其他部分分别给出了添加的汇集层的实验结果,“pool3_fuse”,“pool4_fuse”和“pool5_fuse”。通过调整这些层的类型,MAX或AVE,以及滤波器的尺寸,2×2、4×4、7×7、8×8或14×14,我们在综合考虑实时性和准确性的情况下获得了每一层的最佳参数设置。当特征维数小于某个值时,算法的效果急剧恶化,当滤波器的大小变大时,最大滤波器优于平均滤波器。pool5_fuse图层使用大小为2×2的平均过滤器,pool3_fuse图层和pool4_fuse图层都使用大小为4×4的最大过滤器。此外,我们给出了通过这些设置的多层特征融合方法获得的实验结果,它们也在图5中示出。很容易看出融合方法比单层获得了更好的结果,我们认为原因是多层的特征融合包含更多的空间信息。我们将此作为最终的CNN模型,如最后的第3接A部分所述。

C.Nordland数据集的结果

Nordland 数据集 [ 2 ]记录了挪威北部728公里的火车旅程,在四个不同的季节,火车前方的同一视角。因此,数据集可以被认为包含一个循环,并遍历四次。如图6所示,风景已经发生了巨大的变化,从冬天的积雪覆盖到春天和夏天的新鲜植被和绿色植被,再到秋天的彩色树叶。大多数旅程都是通过自然风光,但火车也经过市区,偶尔停留在火车站或信号站。这可能是目前用于长期视觉位置识别评估的最长和最具挑战性的数据集。在处理之后,数据被确定为25fps并且大小为1920×1080,并且图像序列被同步,即,在相同时间点数据处的每个序列表示相同的位置。

图5.城市中心数据集的实验结果。(关于VGG16-Places365的不同层的曲线显示在(a)中。(b),(c),(d)显示了添加的具有不同设置的池层的结果)

在我们的方法中,我们关注匹配图像序列的问题,而不是识别位置的单一图像。在Nordland数据集中,我们首先通过比较春季和秋季之间的序列来进行不同长度图像序列的实验。该方法可以在长期和大规模的视觉位置识别中获得更好的结果,如图7所示。注意图片中的PR曲线,我们可以发现,随着Slength的增加,算法的效果越来越好,这证明了我们想法的正确性。但是当Slength大于200时,算法的效果开始受到限制。我们分析当Slength足够长以包含一些无法匹配的特定位置时会发生这种情况,可以将其视为噪声。考虑到准确性和复杂性,25 fps数据的最佳序列长度配置为200。因此,我们在其他实验中使用Slength= 200。然后,我们将我们的方法的性能与主要的最新工作进行比较,包括FAB-MAP,SeqSLAM和ABLE-M算法。由于OpenFABMAP [20],OpenSeqSLAM [2]和OpenABLE [21]的作者开发的源代码,实现了评估。如果我们不指定任何参数,我们将使用开源代码中的默认设置。

图6.每个季节的Nordland 数据集的示例图像。

图7.不同Slength的PR曲线。

图8. Nordland数据集的实验结果。

现在,我们处理了六种组合的结果,春天对比夏天,春天对比秋天,春天对比冬天,夏天对比秋天,夏天对比冬天,秋天对比冬天,对应的序列。这些评估由图8中所示的PR曲线描述,其中我们可以观察到不同季节对位置识别性能的影响。值得注意的是,没有匹配图像序列的OpenFABMAP已经取得了比其他方法更差的结果。除了位置识别,准确率为100 %的Recall也是一个很好的性能指标。以100%的精度,我们的方法比其他方法实现了更好的Recall。应该注意到,受开始时序列的影响并不完整,基于序列的方法实现100%Recall是一个限制。在相同条件下,冬季实验表现较差,因为积雪增加了识别难度。

D.讨论

从以上三部分的实验中,我们可以看到,与传统的使用手工特征描述图像的方法相比,我们基于CNN的方法在位置识别任务中具有很大的优势。我们给出如下原因:

(1)通过CNN对大量数据进行学习的图像描述符可以更准确地描述图像之间的差异,

(2)通过融合三个最佳CNN层保留更多图像空间信息的特征,

(3)基于图像序列的识别消除了噪声场所的影响。

此外,在上述实验中,我们的方法在某些地方没有取得好的识别结果。例如,在连续多帧图像中,大部分区域被移动的物体覆盖,或者被天空和地面积雪占据。目前,所有识别算法的性能都很差,这是长期和大规模环境下视觉位置识别最难解决的问题。

V.结论

在这项工作中,我们提出了一个简单有效的基于VGG的CNN框架来提取用于位置识别的图像描述符。我们在卷积层“conv3_3”,“conv4_3”和“conv5_3”后面添加了三个具有合适滤波器的池化层,并将它们的输出融合为描述符组合二值化。此外,用于描述地点的最终二进制字符串是从图像序列而不是单个图像中提取的,并且通过汉明距离进行匹配以进行识别。本文的想法来自我们之前关于大规模交通场景的工作[19]。我们的方法已经证明,它可以通过与其他最先进的方法(如FABMAP,ABLE-M或SeqSLAM)在季节、环境或视点发生极端变化的具有代表性的公共数据集上进行比较,成功地实现长期和大规模的视觉位置识别。

REFERENCES

[1] M. Cummins and P. Newman, “FAB-MAP:Probabilistic localization and mapping in the space of appearance,”International Journal of Robotics Research (IJRR), vol. 27(6), pp. 647-665,Jun. 2008.

[2] N Sünderhauf, P. Neubert, and P.Protzel, “Are we there yet? Challenging SeqSLAM on a 3000 km journey across allfour seasons,”in Workshop on Long-Term Autonomy at the IEEE International Conferenceon Robotics and Automation (W-ICRA), Karlsruhe, 2013.

[3] M. Milford and G. F. Wyeth, “SeqSLAM:Visual route-based navigation for sunny summer days and stormy winter nights,”in IEEE International Conference on Robotics and Automation (ICRA), St. Paul, 2012,pp. 1643-1649.

[4] R. Arroyo, P. F. Alcantarilla, L. M. Bergasa,and E. Romera, “Towards life-long visual localization using an efficientmatching of binary sequences from images,” in IEEE International Conference onRobotics and Automation (ICRA), Seattle, 2015, pp. 6328-6335.

[5] A. Krizhevsky, I. Sutskever, and G. Hinton,“Imagenet classification with deep convolutional neural networks,” In the 25thInternational Conference on Neural Information Processing Systems, Lake Tahoe ,2012, pp.1097-1105.

[6] C. Szegedy, W. Liu, Y. Jia, P. Sermanet,S. Reed, D. Anguelov, D. Erhan, V. Vanhoucke, and A. Rabinovich. “Going deeperwith convolutions,” In IEEE Conference on Computer Vision and Pattern Recognition,Boston, 2015, pp. 1-9.

[7] K. Lin, H. Yang, J. Hsiao, and C. Chen,“Deep learning of binary hash codes for fast image retrieval,” In IEEEConference on Computer Vision and Pattern Recognition Workshops, Boston, 2015,pp. 27-35.

[8] Z. Chen, O. Lam, A. Jacobson, and M.Milford, “Convolutional neural network-based place recognition,” arXiv:1411.1509, 2014.

[9] L. Bo, X. Ren, and D. Fox, “Learning hierarchicalsparse features for rgb-d object recognition,” International Journal ofRobotics Research, vol. 33(4), pp. 581-599, April 2014.

[10] B. Zhou, A. Lapedriza, A. Khosla, A. Oliva,and A. Torralba, “Places: A 10 million Image Database for Scene Recognition,”IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol. pp(89),pp. 1-1, July 2017.

[11] K. Simonyan and A. Zisserman. “Verydeep convolutional networks for large-scale image recognition,” arXiv:1409.1556v2, 2015.

[12] K. He, X. Zhang, S. Ren, and J. Sun,“Deep residual learning for image recognition,” arXiv: 1512.03385, 2015.

[13] D. Bai, C. Wang, B. Zhang, X. Yi andX. Yang, “CNN Feature boosted SeqSLAM for Real-Time Loop Closure Detection,”arXiv: 1704.05016v1, 2017.

[14] X. Gao and T. Zhang, “Loop closure detectionfor visual slam systems using deep neural networks,” In the 34th Chinesecontrol conference, Hangzhou, July 2015.

[15] http://placeschallenge.csail.mit.edu/.

[16] Y. LeCun, L. Bottou, Y. Bengio, P. Haffner,“Gradient-based learning applied to document recognition,” Proceedings of theIEEE, Vol. 86(11), Nov. 1998, pp. 2278-2324.

[17] R. Arroyo, P. F. Alcantarilla, L. M. Bergasa,and E. Romera, “Fusion and binarization of CNN features for robust topologicallocalization across seasons,” in IEEE/RSJ International Conference onIntelligent Robots and Systems (IROS), Daejeon, 2016.

[18] Yangqing Jia, Evan Shelhamer, JeffDonahue, Sergey Karayev, Jonathan Long, Ross Girshick, Sergio Guadarrama, andTrevor Darrell, “Caffe: Convolutional Architecture for Fast Feature Embedding,” arXiv:1408.5093,2014.

[19] Jianliang Zhu, Yunfeng Ai, Bin Tian,“Real-time vehicle queue estimation of large-scale traffic scene,” in IEEEInternational Conference on Image, Vision and Computing, 2017, pp. 1160-1165.

[20] A. J. Glover, W. Maddern, M. Warren,S. Reid, M. Milford, and G. F. Wyeth, “Open FABMAP: An open source toolbox forappearance based loop closure detection,” in IEEE International Conference on Roboticsand Automation (ICRA), Saint Paul, 2012, pp. 4730-4735.

[21] R. Arroyo, L. M. Bergasa, and E.Romera, “Open ABLE: An Open-source Toolbox for Application in Life-Long VisualLocalization of Autonomous Vehicles,” In IEEE 19th International Conference on IntelligentTransportation Systems (ITSC), Rio de Janeiro, Nov. 2016.

作者情况:

*This work was supported in part by the National Natural Science

Foundation of China under Grant 61503380 and in part by the Natural Science Foundation of Guangdong Province, China under Grant 2015A030310187.

Jiangliang Zhu and Yunfeng Ai (corresponding author) are with the

School of Artificial Intelligence, University of Chinese Academy of Sciences, Beijing 100190, China (e-mail:zhujianliang15@mails.ucas.edu.cn,

aiyunfeng@ucas.ac.cn).

Bin Tian is with the State Key Laboratory of Management and Control for Complex Systems, Institute of Automation, Chinese Academy of Sciences,Beijing 100190, China, and also with the Cloud Computing Center, Chinese Academy of Sciences,Dongguan 523808, China (e-mail: bin.tian@ia.ac.cn).

Dongpu Cao is with the Department of Mechanical & Mechatronics

Engineering, University of Waterloo, Waterloo, ontario N2L 3G1, Canada, (e-mail: dongpu.cao@uwaterloo.ca).

Sebastian Scherer is with the Robotics Institute, Carnegie Mellon

University, Pittsburgh, PA 15213, U.S.A, (e-mail: basti@cs.cmu.edu).

最新资讯

-

大卓智能端到端直播实测,16公里复杂路段挑

2025-04-25 17:16

-

《汽车轮胎耐撞击性能试验方法-车辆法》等

2025-04-25 11:45

-

“真实”而精确的能量流测试:电动汽车能效

2025-04-25 11:44

-

GRAS助力中国高校科研升级

2025-04-25 10:25

-

梅赛德斯-AMG使用VI-CarRealTime开发其控制

2025-04-25 10:21

广告

广告